IEEE:GPU很好,但不是唯一

CPU價值重新被發(fā)現(xiàn)

金磊 夢晨 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

是時候讓CPU在AI應用上 “支棱”起來了。

這是去年大語言模型大火之時,權(quán)威期刊IEEE Spectrum在一篇文章中,開門見山給出的一個觀點;并且是由一群AI研究人員得出、聲量越來越大的那種。

文章還坦言道:

誠然GPU可能占據(jù)了主導地位,但在AI領(lǐng)域中的很多情況下,CPU卻是更合適的那一個。

例如文章引援了Hugging Face首席布道官Julien Simon體驗的真實案例——

拿一個英特爾? 至強? 系列CPU,就能輕松駕馭Q8-Chat這個大語言模型,而且響應速度很快。

Simon對此開誠布公地表示:

GPU雖然很好,但壟斷從來不是一件好事,可能會加劇供應鏈問題并導致成本上升。

英特爾CPU在許多推理場景中都能很好地運行。

而這也正與當下大模型的發(fā)展趨勢變化相契合,即逐漸從訓練向推理傾斜,大模型不再僅僅較真于參數(shù)規(guī)模、跑分和測評,更注重在應用側(cè)發(fā)力。

一言蔽之,比的就是看誰能“快好省”地用起來。

不過話雖如此,但在真實的AI場景中,CPU真的已經(jīng)“支棱”起來了嗎?

京東云,選擇CPU

如果說當時在這個話題上,IEEE扮演了 “嘴替”,是在幫那些AI應用實踐的先行者們發(fā)聲,那么這種發(fā)聲,確實又吸引或帶動了更多實干者來驗證這種可行性。他們?nèi)缃褚呀?jīng)可以給出一個確定答案,即在很多AI推理的場景中,CPU已經(jīng)能很好地上崗了。

例如中國公有云服務器市場的翹楚京東云,它pick的便是最新的第五代英特爾? 至強? 可擴展處理器。

具體而言,是在其新一代京東云服務器上搭載了這款高端CPU。

話不多說,我們直接先來看下效果。

首先,從整體來看,新一代京東云服務器的整機性能最高提升了23%!

除此之外,在AI推理方面的性能也是Up Up Up。

- 計算機視覺推理:性能提升38%

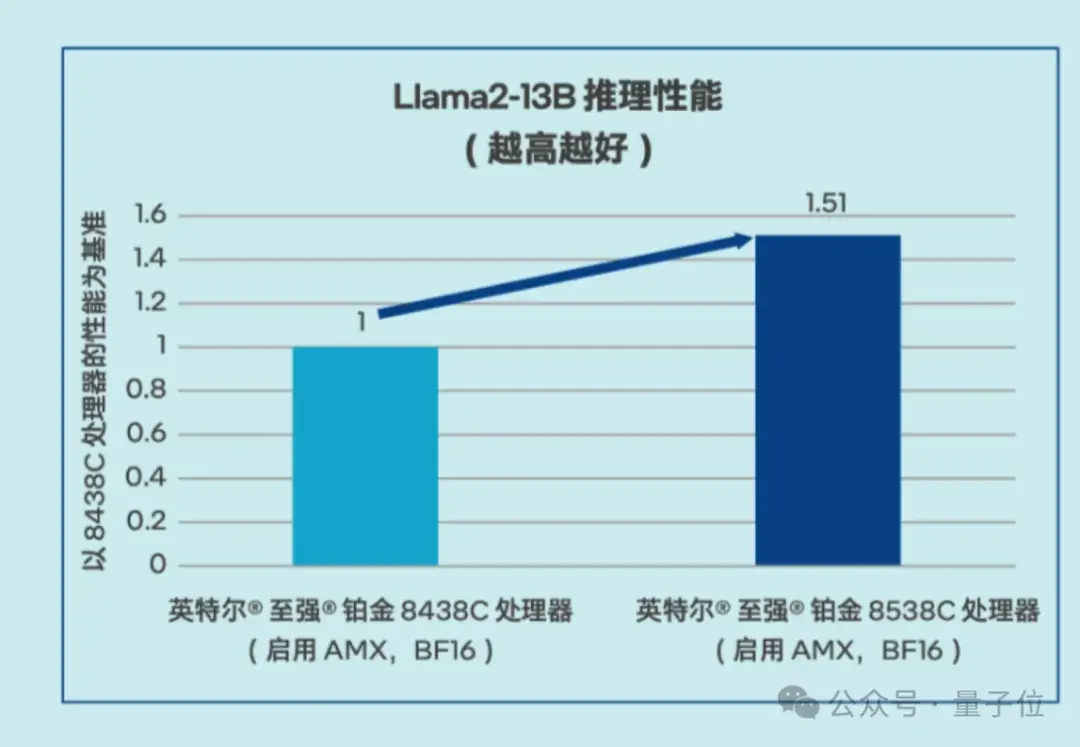

- Llama 2推理:性能提升51%

而之所以能有如此突破,核心就是第五代英特爾? 至強? 可擴展處理器內(nèi)置的AMX(高級矩陣擴展)技術(shù)對AI的加速能力。

英特爾? AMX是針對矩陣運算推出的加速技術(shù),支持在單個操作中計算更大的矩陣,讓生成式 AI 更快地運行。

一言以蔽之,你可以把它當作內(nèi)置在CPU中的Tensor Core。

展開來說, AMX引入了一種包含兩個組件的新矩陣處理框架,包括二維的寄存器文件,它由被稱為“tile”的寄存器組成;另一個是一系列能夠在這些tile上執(zhí)行操作的加速器。

在這些技術(shù)的加持之下,以向量檢索為例,當處理n個批次的任務時,需要對n個輸入向量x和n個數(shù)據(jù)庫中的向量y進行相似度比較。

這一過程中的相似度計算涉及到大量的矩陣乘法運算,而英特爾? AMX能夠針對這類需求提供顯著的加速效果。

△英特爾? AMX架構(gòu)

在提升模型性能的過程中,英特爾? oneDNN作為AMX的軟件搭檔,可為操作者提供一種高效的優(yōu)化實現(xiàn)方式。

開發(fā)者僅需調(diào)用MatMul原語,并提供必要的參數(shù),包括一些后處理步驟,oneDNN便會自動處理包括配置塊寄存器、數(shù)據(jù)從內(nèi)存的加載、執(zhí)行矩陣乘法計算以及將結(jié)果回寫到內(nèi)存等一系列復雜操作,并在最后釋放相關(guān)資源。

這種簡化的編程模式顯著減輕了工程師的編程負擔,同時提升了開發(fā)效率。

通過上述軟硬結(jié)合的優(yōu)化措施,京東云新一代服務器就可以在大模型推理和傳統(tǒng)深度學習模型推理等場景里提供能滿足客戶性能和服務質(zhì)量 (QoS) 需求的解決方案,同時還可以強化各種CPU本就擅長的通用計算任務的處理效率。僅就大家關(guān)心的大模型推理而言,已經(jīng)能用于問答、客服和文檔總結(jié)等多種場景。

△Llama2-13B推理性能測試數(shù)據(jù)

而且除了性能上的優(yōu)化之外,由于搭載了英特爾? AMX等模塊,新一代京東云服務器也可以更快地響應中小規(guī)模參數(shù)模型,把成本也狠狠地打了下去。

你以為這就結(jié)束了?英特爾CPU給新一代京東云服務器帶來的好處,可不只涉及推理加速和成本,更可靠的安全防護也是其獨到優(yōu)勢之一。

基于新款處理器內(nèi)置的英特爾? Trust Domain Extension(英特爾? TDX)技術(shù),京東云在不改變現(xiàn)有應用程序的情況下,就能構(gòu)建基于硬件設備的可信執(zhí)行環(huán)境(Trusted Execution Environment,TEE)。

英特爾? TDX通過引入信任域(Trust Domain,TD)虛擬環(huán)境,利用多密鑰全內(nèi)存加密技術(shù),實現(xiàn)了不同TD、實例以及系統(tǒng)管理軟件之間的相互隔離,讓客戶的應用和數(shù)據(jù)與外部環(huán)境隔離,防止未授權(quán)訪問,且性能損耗較低。

總的來說,英特爾CPU上的這項技術(shù),是從硬件、虛擬化、內(nèi)存到大模型應用等多個層面,為新一代京東云服務器的數(shù)據(jù)和應用保密提供了可靠支撐。

重新發(fā)現(xiàn)CPU的價值

AI進入2.0時代,所有應用都值得重寫一遍已逐漸成為共識。

如果站在算力基礎設施的視角重新審視這場變革,還能發(fā)現(xiàn)這樣一個新趨勢:推理算力越來越被重視起來。

也就是隨著大模型應用場景的日益豐富,對推理階段的性能要求也變得更高和多樣化。

一方面,實時性強、時延敏感的終端側(cè)場景需要盡可能短的響應時間;

另一方面,并發(fā)量大、吞吐量高的云端服務則需要強大的批處理能力。

與此同時,面向不同硬件平臺、網(wǎng)絡條件的推理適配也提出了更復雜甚至帶有不同前置條件的要求。

如此一來,此前在硬件上的單一“審美觀”就被改寫,本來就主攻通用計算、能在整個AI的協(xié)同編排中扮演重要角色,又能擼袖子自己上、兼顧AI加速,同時還有更多“才藝”、應用適配也更為靈活,相比GPU或?qū)S眉铀傩酒@取更容易,且已部署到無處不在的CPU,其價值也被重新發(fā)現(xiàn),這一切都順理成章。

相信隨著軟硬件適配的不斷深入,以及云邊端協(xié)同的加速落地,CPU還有望在AI,特別是AI推理實踐中找到更多的用武之地,發(fā)揮更大的應用潛力。

可以預見,高性能、高效率、高適應性的CPU,在大模型越來越卷的時代,依舊是個可靠的選擇。這一點,會有更多人因為實踐,從而見證。

最后讓我們打個小廣告:為了科普CPU在AI推理新時代的玩法,量子位開設了《最“in”AI》專欄,將從技術(shù)科普、行業(yè)案例、實戰(zhàn)優(yōu)化等多個角度全面解讀。

我們希望通過這個專欄,讓更多的人了解CPU在AI推理加速,甚至是整個AI平臺或全流程加速上的實踐成果,重點就是如何更好地利用CPU來提升大模型應用的性能和效率。

— 完 —

- 看完最新國產(chǎn)AI寫的公眾號文章,我慌了!2025-12-08

- 給機器人打造動力底座,微悍動力發(fā)布三款高功率密度關(guān)節(jié)模組2025-12-08

- 云計算一哥10分鐘發(fā)了25個新品!Kimi和MiniMax首次上桌2025-12-03

- Ilya剛預言完,世界首個原生多模態(tài)架構(gòu)NEO就來了:視覺和語言徹底被焊死2025-12-06