馬斯克機器人大進化!全新技能解鎖,啟用端到端神經網絡

光子進,行為出

夢晨 發自 凹非寺

量子位 | 公眾號 QbitAI

馬斯克的機器人大進化。

一年前首次上臺時動作還略顯僵硬,現在居然成了瑜伽大師。

還用上了自動駕駛系統同款的端到端神經網絡架構,無需任何規則代碼就學會分揀物品。

用馬斯克自己的話說:

光子進,行為出。

網友表示:動作如此優雅流暢,很難相信視頻是真的。

馬斯克回復:執行器、傳感器和整體機械結構更多升級還在后面。

有人注意到機器人脖子后面有個紅色按鈕,“如果機器人要統治世界了,別忘了按這個”。

對此,馬斯克表示會致力于最大限度地提高安全性,用遙控器或手機就能輕松暫停機器人。

馬斯克發這個視頻,除了公布進展,更大的目的在于為機器人團隊招聘,也展示了平臺的招聘功能。

這次特斯拉機器人團隊招聘各類硬件工程師及機器學習工程師、實習生,總計51個職位。

年薪范圍在8萬美元到36萬美元(約人民幣60萬元-260萬元)。

更新拆解

這次特斯拉擎天柱官方號只放出1分鐘視頻,沒有更多技術細節資料。

但特斯拉機器人團隊資深主任工程師Julian Ibarz透露,現在擎天柱已經能完成長期任務。

并且只要收集更多數據,就可以訓練新的復雜任務,無需更改任何代碼。

第三方觀點中,最詳細的是英偉達科學家范麟熙純基于視頻的長篇逆向分析。

他推測:

- 流暢的手部動作幾乎肯定是通過模仿人類(行為克隆)訓練出來的。

另一種選擇是模擬環境中的強化學習,但通常會導致抖動和不自然的手部姿勢。

至少有4種方法可以收集人類演示數據,其中最有可能的是遠程控制。

可以參考斯坦福開源的ALOHA系統,可以控制機械臂把AirPods放到充電盒里。

另外三種方法是電影游戲常用的動作捕捉、深度攝像頭和計算機視覺、VR模擬。

四種方法并不相互排斥,可以結合使用兼顧不同的優缺點。

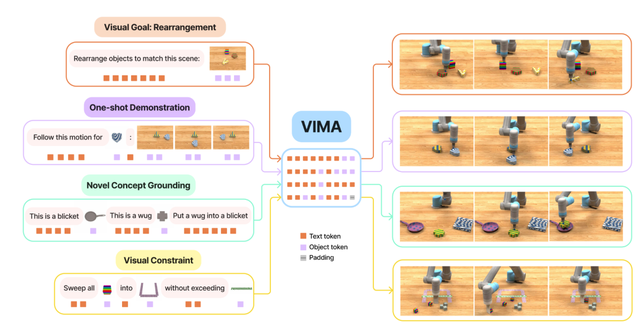

- 神經網絡架構,很可能是多模態Transformer。

圖像、視頻、動作、語言(不確定有沒有)統一表征,其中動作部分需要將連續的信號轉為離散的token,

最終每次輸入一個視頻token(或可選的語言token),輸出動作token。

最接近的系統可以參考Google RT-1以及英偉達的VIMA。

- 波士頓動力的Atlas機器人只有簡單的抓手,而特斯拉擎天柱有5根靈巧的手指,將來在日常任務中表現會更加出色。

不過也有人批評視頻其實有約2-3倍的加速,只有機器人的時候看不出來,人類一出鏡就比較明顯了。

端到端架構:機器人的ChatGPT

端到端神經網絡架構,特斯拉首先在自動駕駛FSD上實現——

前不久馬斯克自己直播演示了一把自動駕駛去小扎家,引發轟動。

具體說來,端到端架構用在自動駕駛系統上,可以減少30萬行規則代碼,讓運行速度快了10倍。

負責該項目的工程師Dhaval Shroff曾對馬斯克說:這相當于車上用的ChatGPT。

Shroff這次對機器人的評價是“端到端,FTW”。也不知道FTW是指“For the win”還是“F*?the world”。

就在剛剛,還有一段特斯拉汽車無導航情況下在湖邊自動駕駛的視頻傳出,不過不確定是否運行了最新端到端架構的FSDv12。

One More Thing

這個周末,舊金山街頭也出現賽博皮卡的身影。

預計在9月底,特斯拉將召開一年一度的AI Day活動,我們也會持續關注。

不知道這次又將帶來哪些驚喜。

參考鏈接:

[1]https://x.com/Tesla_Optimus/status/1705728820693668189

[2]https://x.com/DrJimFan/status/1705982525825503282

[3]https://x.com/AviSchiffmann/status/1705743064336384506

- 英偉達自毀CUDA門檻!15行Python寫GPU內核,性能匹敵200行C++2025-12-08

- GPT-5-Thinking新訓練方法公開:讓AI學會懺悔2025-12-04

- GPT5.5代號“蒜你狠”曝光!OpenAI拉響紅色警報加班趕制新模型,最快下周就發2025-12-03

- 華爾街尬捧TPU學術界懵了:何愷明5年前就是TPU編程高手,多新鮮2025-11-30