一張圖轉(zhuǎn)3D質(zhì)量起飛!GitHub剛建空倉就有300+人趕來標(biāo)星

分辨率飛升8倍

夢晨 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

最新“只用一張圖轉(zhuǎn)3D”方法火了,高保真那種。

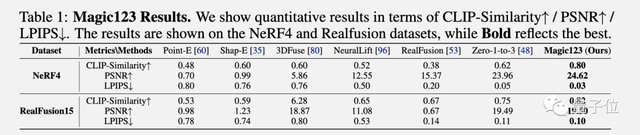

對比之前一眾方法,算得上跨越式提升。(新方法在最后一行)

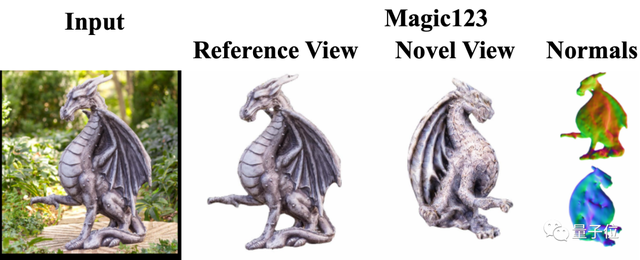

挑出一個結(jié)果放大來看,幾何結(jié)構(gòu)細(xì)節(jié)豐富,渲染分辨率也高達(dá)1024×1024。

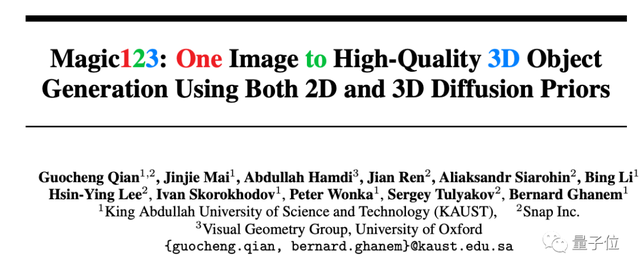

新方法Magic123,來自KAUST、Snap和牛津聯(lián)合團(tuán)隊(duì),一作為KAUST博士生錢國成。

只需輸入單個圖像,不光生成高質(zhì)量3D網(wǎng)格,連有視覺吸引力的紋理也一起打包生成。

甚至論文剛掛在arXiv上,代碼還沒來得及上傳時,就已經(jīng)有300+人趕來標(biāo)星碼住(順便催更)。

從粗到精,兩階段方案

以往2D轉(zhuǎn)3D最常見方法就是NeRF。但NeRF不光占顯存高,分辨率還低。

論文中指出,即使資源效率更高的Instant-NGP方案在16G顯存GPU上也只能達(dá)到128×128的分辨率。

為進(jìn)一步提高3D內(nèi)容的質(zhì)量,團(tuán)隊(duì)在NeRF之后引入了第二階段,采用DMTet算法將分辨率提高到1024×1024,并且細(xì)化NeRF得出的幾何結(jié)構(gòu)和紋理。

對于僅有一張的2D參考圖像,首先使用現(xiàn)成的Dense Prediction Transformer模型進(jìn)行分割,再使用預(yù)訓(xùn)練的MiDaS提取深度圖,用于后續(xù)優(yōu)化。

然后進(jìn)入第一步粗階段,采用Instant-NGP并對其進(jìn)行優(yōu)化,快速推理并重建復(fù)雜幾何,但不需要太高分辨率,點(diǎn)到為止即可。

在第二步精細(xì)階段,在用內(nèi)存效率高的DMTet方法細(xì)化和解耦3D模型。DMTet是一種混合了SDF體素和Mesh網(wǎng)格的表示方法,生成可微分的四面體網(wǎng)格。

并且在兩個階段中都使用Textural inversion來保證生成與輸入一致的幾何形狀和紋理。

團(tuán)隊(duì)將輸入圖像分為常見對象(如玩具熊)、不太常見對象(如兩個疊在一起的甜甜圈)、不常見對象(如龍雕像)3種。

發(fā)現(xiàn)僅使用2D先驗(yàn)信息可以生成更復(fù)雜的3D結(jié)構(gòu),但與輸入圖像的一致性不高。

僅使用3D先驗(yàn)信息能產(chǎn)生精確但缺少細(xì)節(jié)的幾何體。

團(tuán)隊(duì)建議綜合使用2D和3D先驗(yàn),并經(jīng)過反復(fù)試驗(yàn),最終找到了二者的平衡點(diǎn)。

2D先驗(yàn)信息使用了Stable Diffusion 1.5,3D先驗(yàn)信息使用了哥倫比亞大學(xué)/豐田研究所提出的Zero-1-to-3。

在定性比較中,結(jié)合兩種先驗(yàn)信息的Magic123方法取得了最好的效果。

在定量比較中,評估了Magic123在NeRF4和RealFusion15數(shù)據(jù)集上的表現(xiàn),與之前SOTA方法相比在所有指標(biāo)上取得Top-1成績。

那么Magic123方法有沒有局限性呢?

也有。

在論文最后,團(tuán)隊(duì)指出整個方法都建立在“假設(shè)參考圖像是正視圖”的基礎(chǔ)上,輸入其他角度的圖像會導(dǎo)致生成的幾何性質(zhì)較差。

比如從上方拍攝桌子上的食物,就不適合用這個方法了。

另外由于使用了SDS損失,Magic123傾向于生成過度飽和的紋理。尤其是在精細(xì)階段,更高分辨率會放大這種問題。

項(xiàng)目主頁:

https://guochengqian.github.io/project/magic123/

論文:

https://arxiv.org/abs/2303.11328

GitHub:

https://github.com/guochengqian/Magic123

參考鏈接:

[1]https://twitter.com/_akhaliq/status/1675684794653351936

- GPT-5-Thinking新訓(xùn)練方法公開:讓AI學(xué)會懺悔2025-12-04

- GPT5.5代號“蒜你狠”曝光!OpenAI拉響紅色警報加班趕制新模型,最快下周就發(fā)2025-12-03

- 華爾街尬捧TPU學(xué)術(shù)界懵了:何愷明5年前就是TPU編程高手,多新鮮2025-11-30

- 混元OCR模型核心技術(shù)揭秘:統(tǒng)一框架、真端到端2025-11-30

站面.png)