狂徒AI對羅翔老師下手了

火爆全網AI的技術大揭秘

金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

朋友,有沒有想過自己在二次元里長什么樣?

最近就有這么樣的一個生成器在國內外火了。

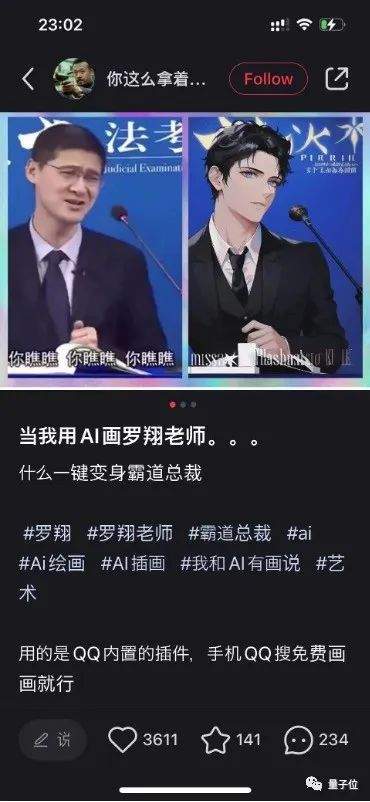

瞧,輸一張羅翔老師的照片,“啪的一下”就能生成二次元漫畫風:

一鍵秒變霸道總裁有木有,引得網友紛紛前來圍觀。

甚至就連KFC(肯德基)官方賬號都來湊起了熱鬧,親自打破自家老爺子的次元壁:

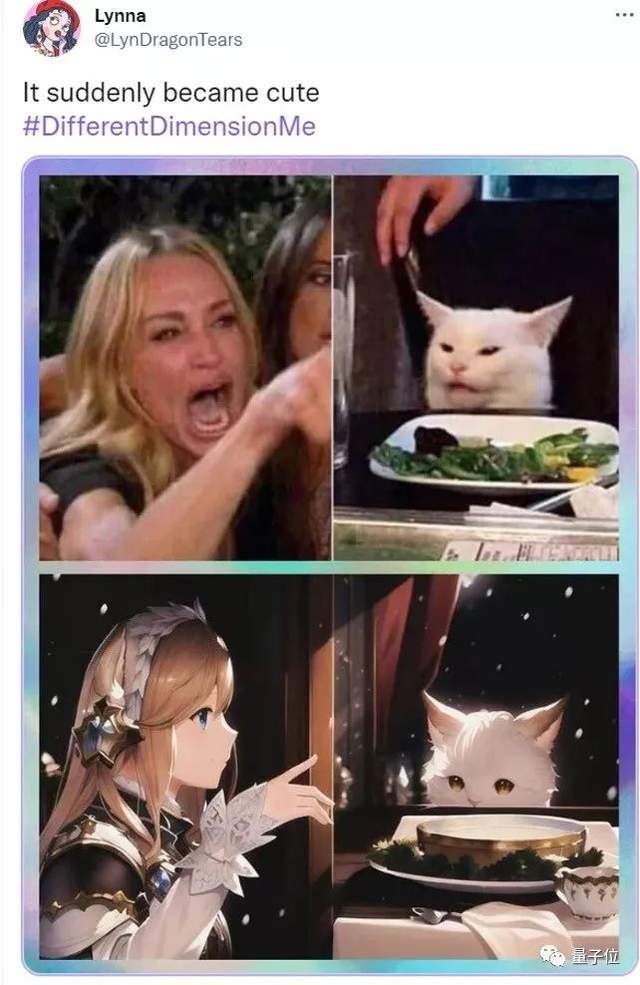

各類梗圖更是層出不窮:

在二次元濾鏡下,就連這張經典的“女人吼貓”都透露出一絲溫馨,“竟然都有點可愛了呢”。

這就是QQ小世界在近期推出的二次元形象生成器——“異次元的我”。

那么這層次元壁,又是如何打破的呢?

只需上傳一張照片

據了解,在QQ小世界“異次元的我”相關話題之下,已經有突破100萬的投稿量,瀏覽量更是上億。

甚至一度還把QQ服務器給擠爆了:

而之所以會呈現如此“全民參與”的態勢,離不開打破次元壁的簡單操作。

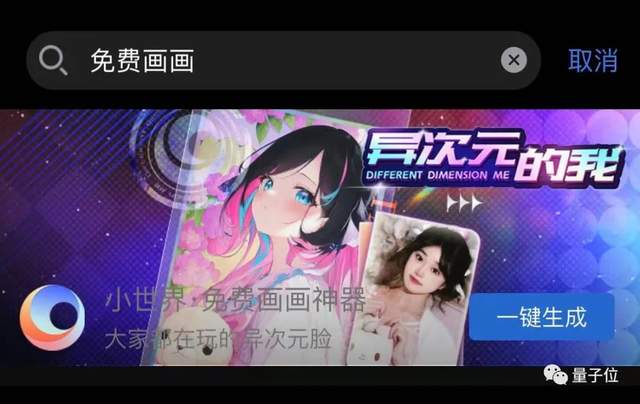

只需要搜索一句“免費畫畫”,便可以看到入口了:

然后僅需現場拍照,或上傳圖片即可:

而且為了能讓二次元風格圖能夠hold住各式各樣的圖片,“異次元的我”還設置了不同的使用場景,讓適配度變得更高:

不得不說,打破次元壁這件事,現在真心變得好easy。

那么接下來的一個問題便是:

什么原理?

近年來,擴散模型(Diffusion Model)在圖像生成領域中蓬勃發展。

例如OpenAI的GLIDE和Google的Imagen,都采用了基于擴散模型的pipeline來獲得高質量的圖像生成結果。

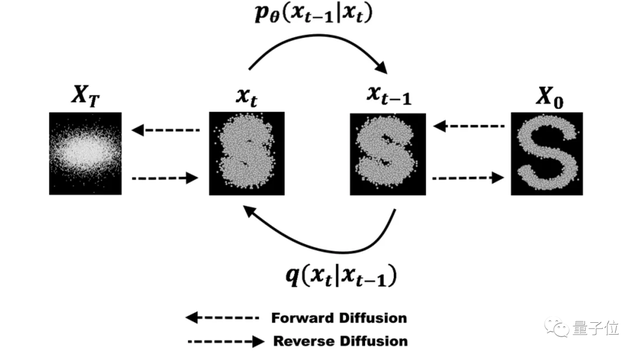

擴散模型分為兩個過程。如下圖所示,右邊是一張正常的圖片。

從右到左的Forward Diffusion是一個逐步地將正態分布的噪聲疊加到圖片上的過程,最終得到一張看起來完全是噪聲的圖片。

可以不嚴謹地想象成往一塊牛排上不斷撒椒鹽,直到它看起來完全被椒鹽覆蓋,看不清原來的紋路。

從左到右的Reverse Diffusion則是一步步去除噪聲,試圖還原圖片,這就是擴散的生成數據過程。

而擴散模型的訓練就是在學習預測疊加在xt上的噪聲,從而得到去噪后xt-1的圖片,經過一輪又一輪的去噪,得到最終無噪聲的輸出圖X0。

最新的Stable Diffusion模型,則是在此基礎上結合了一個訓練好的VAE模型。

VAE模型可以對任意圖片進行壓縮再解壓,將圖片使用VAE的編碼器壓縮后能得到比原圖小很多的特征編碼,再基于特征編碼訓練擴散模型,最終生成的特征編碼再使用VAE的解碼器還原回原始尺寸的大圖,這就是Stable Diffision的做法。

這一改進大大減少了圖像生成的時長和占用的GPU資源,使得落地成為可能。

為了能夠使用文字控制模型生成的內容,Stable Diffusion模型使用了預訓練的CLIP模型來引導生成結果。

CLIP模型使用了大量的文字和圖片對訓練,能夠衡量任意圖片和文本之間的相關性,即CLIP-score。

在前向生成圖片的過程中,模型除了要去噪以外,還需要讓去噪后的圖片和引導詞的CLIP-score盡量大。

這樣在不斷生成過程中,輸出結果就會越來越接近我們給定的文字描述。

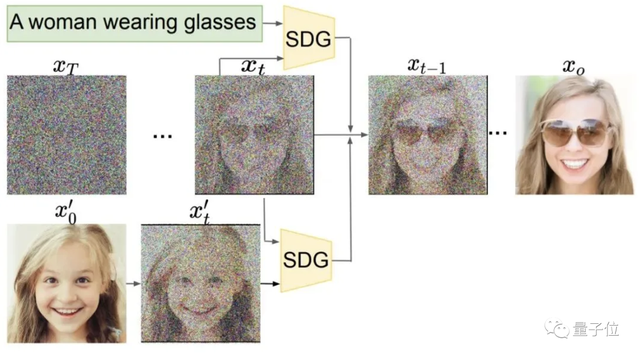

在上圖中,左下角的小朋友的臉先被疊加了一定程度的噪聲。

之后在去噪過程中,會不斷拉近生成結果圖和“a woman wearing glasses”的距離,從而使得生成結果逐漸變成了戴眼鏡的成年女性。

生成圖片依然能夠保留原始圖片的大致結構,但是細節卻在文字的引導下發生了變化。

Stable Diffusion技術在AI畫畫尤其是二次元領域中展現出非常高的觀賞性和娛樂性,各家紛紛推出基于Stable Diffusion的AI畫畫平臺,如draft.art、意間AI等。

但當時現有的平臺在使用上非常不便捷,如果直接生成,大概率生成的質量不會很高,還容易遇到翻車現場:

如果用戶想要生成比較好的結果,就需要對圖片內容進行詳盡的描述,并增加很多提升效果和強化風格的詞,才能得到一個比較理想的效果。

而且界面可調的參數非常多,用戶使用門檻很高;另一方面,對于資源的消耗導致這些平臺通常需要排隊非常久才能拿到一張結果。

因此,QQ小世界團隊針對這些痛點進行了優化改造,用戶只需要上傳一張圖片,即可得到好看穩定的生成效果,降低了使用門檻的同時也保證了生成質量。

在技術上,研究人員主要進行了以下幾點優化:

- 準確的內容生成:通過自研diffusion模型對生成語義進行強化,并輔助圖片內容分析提升生成內容對應性;

- 更快的生成速度:利用超分模型減少difussion模型的生成分辨率,并針對圖像inference過程進行加速,提升生成速度,節約GPU資源;

- 多樣的風格選擇:針對不同的場景設計了豐富且美觀的風格化效果。

另外,在設計玩法時簡化了用戶的使用流程,為了讓用戶使用門檻更低、體驗更好,研究團隊通過口碑積累達到了峰值1000%的二次傳播率。

之前的一些AI畫畫平臺,如意間AI,draft art等,除了上傳圖片,還需要使用一系列的描述主體和風格的引導詞(prompt),有時候還需要調整不同參數,來得到一個理想的結果。

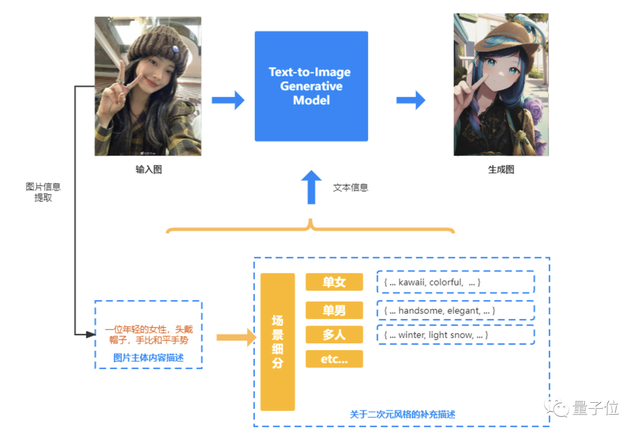

為了降低用戶的使用門檻,“異次元的我”對pipeline進行了改進:

將輸入模型的提示詞分為兩個部分——圖片主體內容描述和風格描述。

內容描述:為了得到圖片的內容描述,對輸入圖中的信息進行人物性別、年齡、姿勢等屬性的檢測,得到最終盡可能準確詳盡的內容描述詞。

風格描述:為了讓結果更接近二次元,為各種不同場景設計了非常鮮明的二次元風格。根據第一步對圖片內容進行分析后,進一步細分為單人男性、單人女性、多人等不同場景。

結合內容描述和風格描述,研究人員通過對原圖的分析得到最終完整的提示詞輸入網絡,從而能夠穩定生成畫面精致、風格突出的結果。既保證了生成內容和原圖的對應性,又增添了很多“異次元”要素,讓用戶更有穿越到二次元的感覺,同時也保證了較高的生成質量。

另一方面,自研diffusion模型針對語義理解進行了強化,能夠更準確理解和生成圖片的主體內容,在語義信息理解和圖像生成質量上均有明顯提升。

和近期推出相似玩法的其它平臺對比,“異次元的我”在內容準確度上會更好,風格也更加二次元化、更美觀:

據了解,原始的Stable Diffusion由于需要通過多次迭代生成圖片,在默認配置A100機器上生成一張720p的圖像耗時約12s。

如果需要通過提升分辨率和增大迭代步數來提升效果,耗時更是需要多達一分鐘。

而“異次元的我”針對自研模型采取了一系列的模型壓縮和工程加速的方案,最終一張圖片的生成速度是1.6s,提升了7倍。

……

那么對于這種“快、好、省”地變二次元的玩法,你心動了嗎?

按照下面的方法快去試玩吧:

在QQ搜索“免費畫畫”即可參與。

One More Thing

QQ小世界團隊最初只是想著在國內搞“異次元的我”,但不知為何被傳到了外網并火了起來,不過期間也是鬧出了一些小烏龍。

而QQ小世界團隊得知此消息后,火速優化了算法。現在“異次元的我”可以兼容各種膚色,生成多元圖片。

對此,海外用戶也對團隊的優化表示了肯定:

看來,不僅是人類需要不斷學習進步,AI亦是如此。

- 看完最新國產AI寫的公眾號文章,我慌了!2025-12-08

- 給機器人打造動力底座,微悍動力發布三款高功率密度關節模組2025-12-08

- 云計算一哥10分鐘發了25個新品!Kimi和MiniMax首次上桌2025-12-03

- Ilya剛預言完,世界首個原生多模態架構NEO就來了:視覺和語言徹底被焊死2025-12-06