記憶張量 × 商湯大裝置:國產 GPGPU 推理成本反超 A100!

推理性價比達 A100 的 150%

近日,記憶張量聯合商湯大裝置宣布,在國產GPGPU上率先跑通業內首個以“記憶—計算—調度”一體化為核心的PD分離商用推理集群。相比傳統僅依賴硬件隔離的方案,本次落地將PD分離與記憶張量旗下核心產品MemOS(以下簡稱 MemOS)的激活記憶體系深度耦合,使Prefill批量化可調度、Decode前臺低抖動成為可能。

集群在真實C端負載下實現單卡并發效率提升20%、吞吐提升75%,綜合推理性價比達到同代NVIDIAA100的150%。這一成果標志著國產算力體系在大模型商業化路徑上首次具備“體系級”競爭力,為高性能模型的大規模落地打開了全新的降本增效空間。

MemOS與PD分離深度耦合,打破性能上線

過去一年中,“PD分離”幾乎成了大模型推理優化里最熱的技術關鍵詞之一,但一個被反復忽略的現實是:如果只在算力層面做PD分離,而不去重構上層業務路徑,那么它能帶來的收益其實是有天然上限的。

隨著DeepSeek-R1等高性能模型從B端試水走向C端大規模落地,“記憶”已經成為C端產品體驗與成本結構的核心變量。只有當PD分離與記憶結構深度耦合,重構“記憶—計算—調度”整體體系,它才有機會真正超越傳統意義上的性能上限。

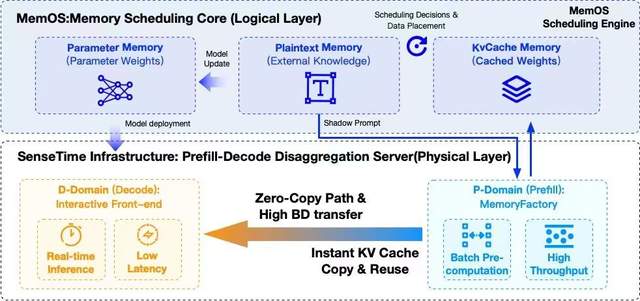

MemOS作為業內唯一一個以記憶為中心,覆蓋從底層推理、到記憶模型,再到應用工程進行系統設計的記憶基礎設施,它將大模型的認知結構劃分為三類記憶:參數記憶、激活記憶、明文記憶。這三類記憶形成了一條跨時間尺度的調度鏈路,可以進行精細地決策:哪些計算應該前移到Prefill,哪些必須留在Decode,以及任務的保留、降級或淘汰等。

顯然,MemOS更適合和PD分離進行結合——它擁有一整套可以“決定如何用這條通道”的調度邏輯,從而把PD分離原本有限的收益空間盡可能壓榨到極致。

正因此,本次記憶張量與商湯大裝置在某國產GPGPU上的解決方案,真正跑出一版帶完整業務語境的R1滿血推理集群——不僅在單機和小規模集群實驗中有效,而且在嚴格SLA約束下,可以在12臺4P8D架構的商用集群上穩定運行,將PD分離變成“可以被商業化復現的工程范式”。

結構共振,讓 PD 分離從優化技巧走向推理范式

在本次聯合方案中,商湯大裝置提供了讓 MemOS 三層記憶結構擁有物理載體的頂層系統級基礎設施。依托大裝置IaaS的高效算力池、智能算力調度等為模型推理提供穩定的基礎設施支撐;并借助Ignite框架提供多后端推理適配、KVCache管理優化、關鍵算子加速、跨節點通信調優等性能增強,形成體系化的推理優化鏈路;同時,商湯萬象MaaS平臺的統一調度策略確保Prefill與Decode服務在高并發場景下始終穩定運行。

集群的底層算力方面, 則由算豐信息提供核心支撐,算豐信息在此次集群中承接管理了所有高性 GPGPU 計算資源、大規模文件對象存儲以及高速互聯網絡服務,為 PD 分離架構的高效穩定運行提供了不可或缺的鼎力支持。

在商湯大裝置的某國產GPGPU集群上,MemOS的記憶結構被映射成了非常清晰的物理分工:

- P域(Prefill Domain)變成真正的“記憶工廠”,集中承載影子上下文的預測與KV Cache的批量預生成,這些任務通常對吞吐敏感、對時延容忍度高,因此可以在P域以高并行、高利用率的方式運行,而不再與前臺交互搶占資源;

- D域(Decode Domain)則被打造為純粹的“實時交互前臺”,專注處理真實用戶請求的解碼過程,在保持超低TTFT的前提下,承擔起R1這一類大模型在C端場景的連續輸出與穩定響應;

- 跨節點KV Cache則通過高帶寬互聯與零拷路徑實現“即產即用”,MemOS的激活記憶機制與商湯大裝置在某國產GPGPU上打磨出的通信能力形成天然互補,使Prefill產生的KV Cache不再成為傳輸瓶頸,而是以極低開銷進入D域的解碼流程中。

這次合作是一次體系級的結構共振:PD分離為MemOS打開了一條真正意義上的高速算力通道,而MemOS則為PD分離提供了精細到記憶單元級別的調度邏輯和業務上下文,基于此,PD分離第一次從一個工程團隊內部的“性能小技巧”,變成一套可以被完整描述、完整度量、并在生產環境中長期運行的新推理范式。

綜合推理性價比達到同代NVIDIA A100的150%左右

在嚴格的生產級評測口徑下——包括2k輸入、1k輸出、TTFT<2s 的SLA約束、72小時以上穩態運行、統一的限流與負載生成策略——記憶張量與商湯大裝置聯合打造的國產GPGPU集群交出了這樣一張答卷:

- 集群整體吞吐量提升超過75%,從Naive部署下的107.85 tokens/s提升到189.23 tokens/s,不是因為“卡更強了”,而是Prefill與Decode真正做到了算/存解耦,流水線氣泡被有效壓縮,影子上下文的批量預計算也不再造成資源浪費;

- 單卡并發能力提升約20%,從25.00并發/卡提升至29.42并發/卡,這在C端場景下尤為關鍵,意味著在同等硬件規模下,集群能穩態承載更高的實時會話數,高峰期排隊與溢出的風險明顯降低;

- TTFT全程穩定小于2秒,得益于Prefill全量前移和D域職責的“單一化”,Decode不再被一些突發的重Prefill任務搶占資源,首字延遲因此從系統層面得到了保障;

- KV Cache在熱門場景中的命中率顯著提升,可達70%+,這使得諸如MemOS-Chat這一類需要高頻、多輪交互的C端應用,在熱點話題和常見任務上具備了極高的預計算復用率,推理成本被進一步攤薄;

- 在統一財務與技術口徑下,綜合推理性價比達到同代NVIDIA A100的150%左右,在嚴格SLA與相同負載結構下,某國產GPGPU在這一套“記憶原生×PD分離×業務調度”的框架中,第一次實現了對A100的體系級正面超越。

這些數字代表著:“國產GPU不再只是一個“可以跑大模型”的選項,而是真正具備了承載R1級C端業務的體系能力。”

行業意義:下一代推理范式被點亮

從行業視角來看,這次聯合實踐更重要的價值在于清晰地描繪出了一條未來大模型推理架構的可行路線。

首先,PD分離從“硬件層的算存優化”,升級為“圍繞記憶的推理范式設計”:在MemOS這樣以記憶為核心組織推理流程的系統里,PD分離可以延伸到行為預測、上下文規劃、激活記憶布局等更高維度,從而變成整體架構的一部分,而不再是孤立的工程優化。

其次,C端場景走向Memory推理:現在我們更關注的是:系統在多長時間尺度內能保持一致的人設、風格和偏好;它是否能記住用戶的歷史行為,并以此給出更智慧、更個性化的反應。在這個意義上,記憶不再是推理鏈路的外掛,而正在成為推理本身的中心。

未來,國產GPU不必也不應該只是在“算力參數”上做對標,而是有機會在體系結構上形成差異化領先:通過MemOS×商湯大裝置的聯合探索,我們可以看到:當底層架構與上層系統“共同為記憶和Agent這種新形態服務”時,國產生態完全可以定義自己的技術話語體系,而不是永遠追隨“通用加速器+通用框架”的舊范式。

打造記憶原生時代的國產AI基礎設施新范式

未來,記憶張量與商湯將在這一范式之上繼續深化合作:

- 一方面,圍繞更大規模的國產GPGPU集群,構建真正意義上的記憶驅動流水線推理底座,讓“影子上下文—激活記憶—PD分離—多級緩存—AIOps”成為一套可觀測、可回滾、可演進的基礎設施能力;

- 另一方面,在Prefill行為預測自治化、多級激活記憶管理、跨任務長時記憶一致性、面向Agent的軌跡記憶等方向上持續打磨,讓這套范式更能承載未來的伴隨式AI、具身智能體以及更復雜的長周期任務編排。

從更長遠的視角看,這次聯合實踐帶來的最大改變是:國產算力體系第一次擁有了另一條面向未來智能形態的可能“結構性路線”:從參數計算走向記憶計算,從靜態推理走向動態流水線,從模型中心走向記憶中心。

可以預見,未來國產GPGPU不再只是“跟上來”的參與者,而完全有機會成為下一代推理范式的定義者之一。

- 云計算一哥10分鐘發了25個新品!Kimi和MiniMax首次上桌2025-12-03

- Ilya剛預言完,世界首個原生多模態架構NEO就來了:視覺和語言徹底被焊死2025-12-06

- 前端沒死,AI APP正在返祖2025-12-02

- 華為新架構砍了Transformer大動脈!任意模型推理能力原地飆升2025-12-06