百川智能上新超千億大模型Baichuan 3,沖榜成績:若干中文任務超車GPT-4

重點打磨邏輯推理和強化學習

衡宇 發自 凹非寺

量子位 | 公眾號 QbitAI

走月更路線的百川智能,在年前猛地加速,變成了半月更:

發布了超千億參數的最新版本大模型Baichuan 3,是百川智能基礎模型第三代——就在20天前,這家由王小川創辦的大模型公司,剛剛發布過角色大模型Baichuan-NPC。

更具標志性的是,百川智能這次模型更新,重點展示了模型在醫療場景的能力。

這既是商用落地的方向性揭示,還是王小川一直以來的技術健康理想,更在客觀上表明了領先性,因為醫療領域,也被業內類比為“大語言模型皇冠上的明珠”。

大模型落地醫療領域,既需要豐富的醫療知識、合適的Prompt,還需要模型本身的推理能力過硬。

當然,醫療能力都秀了,更何況文學創作。Baichuan 3也秀了一把文學創作的能力,據說背后是在強化學習方面狠狠下了一番功夫。

具體怎么樣?一起前排來康康。

Baichuan 3的能力怎么樣?

Baichuan 3是百川智能發布的基礎模型第三代版本,對比9月推出的Baichuan 2,各方面性能有了大幅提升。

話不多說,來看看Baichuan 3的測試成績。

首先是對基礎榜單的一系列刷新。

包括MMLU、CMMLU、GAOKAO、AGI-Eval、ARC等業內榜單,都成了百川智能秀新肌肉的背景板。

在MMLU測試集上,Baichuan 3最終成績為81.69,達到GPT-4 94.55%的水平。而在CMMLU和GAOKAO這兩個中文任務評測中,Baichuan 3甚至超越了GPT-4。

可以看到除ARC-Easy(含3年級到9年級科學考試內容的多選題問答數據集)以外,Baichuan 3在各個主流榜單上的能力都大幅超越GPT-3.5,達到接近GPT-4的水平。

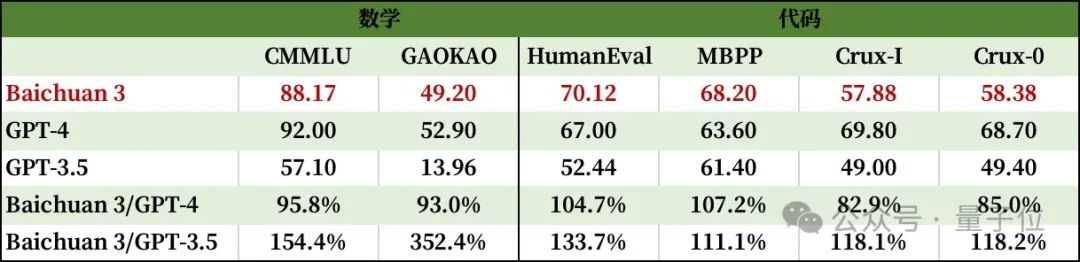

一般來說,千億參數以上大模型通常還會“闖關”數學和編程能力,以展現自身的深層次邏輯思考能力和問題解決技能。

Baichuan 3在這方面也表現出眾。

可以看到,評測數學能力的GSM8K和MATH上,Baichuan 3均達到了GPT-4九成以上的能力;而HumanEval和MBPP這類鑒別編程能力的評測集,Baichuan 3的表現超過了GPT-4。

至于對齊能力方面,Baichuan 3在MT-Bench和IFEval評測中,僅低于GPT-4。

其中,MT-Bench(Multi-turn Benchmark)專門評估大模型多輪對話任務表現,由80個多輪對話問題組成,涵蓋了寫作、角色扮演、推理、數學、編碼、知識(STEM)和人文社會科學等多個領域。

而IFEval(Instruction-Following Eval)則專注評估大模型遵循指令的能力,包含關鍵詞檢測、標點控制、輸出格式要求等25種任務。

開篇我們提到,百川智能的這一代超千億大模型,開始嘗試挑戰醫療場景。

看看其在醫療相關評測任務中取得的結果,也確實拿得出手:中文相關評測任務超過GPT-4水準,英文相關評測任務中,也大大縮短了與SOTA的距離。

為了防止官方進行“Cherry-Pick”(從大量數據集中精選出符合某特定標準的某些部分或個體),我們在體驗過程中,隨機驗證了一道醫療問診題目:

Fine,淺試了一下,專業度可以。

再來看Baichuan 3頗引以為傲的文學創作能力,在極高難度的唐詩宋詞創作方面,Baichuan 3對唐詩宋詞的語義理解和生成能力大幅提升。

那就丟它一個“命題作文”,試試寫首詞,主題是奧特曼在OpenAI的《甄嬛傳》事件,詞牌名就選《定風波》。

笑不活了,Baichuan 3反饋回來的作品居然還是雙語的,句式、對仗完全OK:

同樣的題目,丟給ChatGPT試試?

它懂了咱要它寫詞,但沒完全懂。大概ChatGPT還沒學明白“定風波”不是整個事件的定論,是句式、聲韻、對仗有特別規律的詞牌名。

后來又試了試別的,發現不是Baichuan 3運氣好,這家伙應該是真的懂詞牌名。

來看這首《滿江紅》:

后來的測試過程,我們又蹭了蹭農歷新年的熱度,順便在文學創作能力的基礎上,加點多輪對話的能力。

結果ChatGPT還是出現了“不懂詞為何物”的bug。

至于詞的內容怎么樣,要是有愛好文學的小伙伴,可以在評論區分別品鑒一下:

百川智能新模型解析

從各項數據和具體效果來看,Baichuan 3已經完成了全方位升級,在中文能力有超越GPT的表現。

它是如何做到的?技術上做了哪些創新和迭代?

關于Baichuan 3,百川方面并未公布模型具體參數,但明確表示了參數量超千億。

也就是說,整體來看,百川智能的路線和OpenAI的路線一致,即業內認可的暴力美學,參數出涌現。

然而眾所周知的是,即使有百億甚至幾百億級別模型的訓練基礎,對此前的“小”大模型,千億參數大模型的訓練也會面臨不少新的問題。

比如數據制備、參數矩陣初始化方法的選擇、優化方法選擇,或者是讓人頭疼不已的梯度爆炸、Loss跑飛、模型不收斂等。

百川智能的解決策略,從訓練初期就開始切入。

首先,針對超千億大模訓練初期模型不穩定性增強的情況,百川智能提出了一個漸進式初始化方法,叫“重要度保持”(Salience-Consistency)。

訓練過程中,團隊還通過細粒度監控、“異步CheckPoint存儲”機制等措施,保證Baichuan 3的穩定訓練至少在一個月之上。

如果臨時出了問題,也能在10分鐘內完成故障修復。

其次,Baichuan 3對訓練框架進行了優化,實現了減少同步開銷、減少通信延時、減少流水并行分段數量,并且降低了空泡率。

第三,為了提高模型最后的收斂效果,訓練過程中,百川智能團隊不僅監控梯度、loss等指標,還引入了參數“有效秩”,保證盡快發現訓練過程出現的問題。

話到這里就多提兩句,千億模型的訓練,動輒要幾千卡訓練N個月,因此訓練過程的監控需要格外重視。

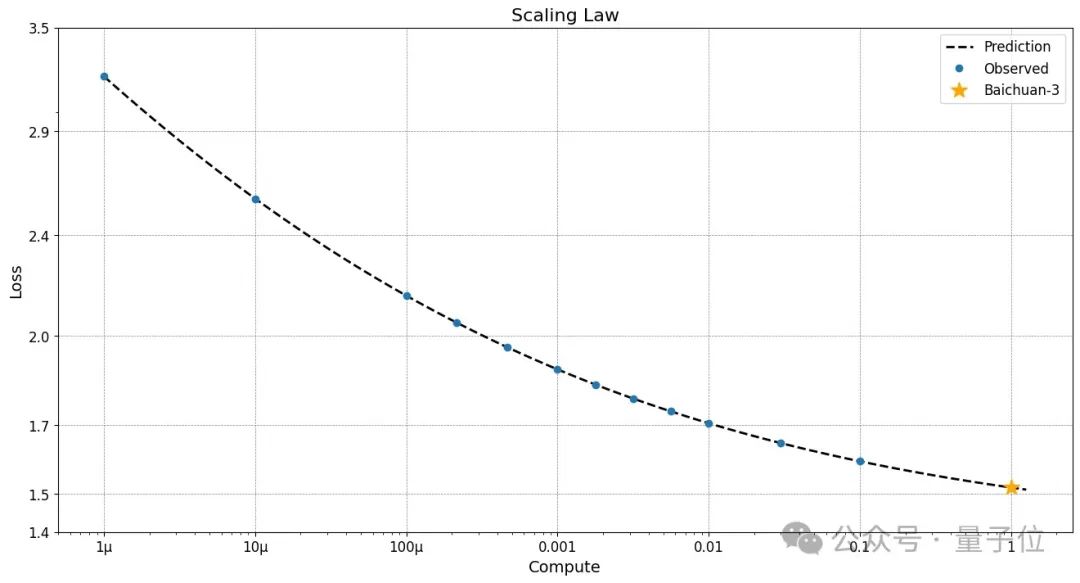

據團隊介紹,為了確保訓練的超大模型遵循“Scaling Law”,百川智能依靠小模型以及訓練的不同FLOPS時期對大模型的Loss進行預測。

實驗表明,大模型完美復刻了團隊預期的loss。

再者說,百川智能在數據的優化和采樣方面也有所創新。

團隊提出了一套基于因果采樣的方法在模型訓練過程中動態地選擇訓練數據的方案。

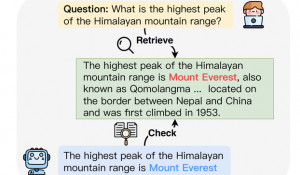

詳細流程如下圖所示:

也就是說,訓練千億模型時在穩定性、收斂性、并行方式等多個層面可能面臨的問題,Baichuan 3逐個擊破,進行優化,這才有了評測集上的亮眼成績。

至于Baichuan 3能在中文醫療場景的表現能超過GPT,秘方也被我們打聽了個底朝天。

得到的答案是,大模型在醫療領域落地,需要具備三方面的能力:

- 第一點,模型需要具備足夠的醫療領域知識;

- 第二點,模型需要具備很強的邏輯推理能力;

- 第三點,需要精心調教合適的Prompt,讓模型能夠激發出相關的知識、結合合適的推理。

用一句話概括,就是需要大模型具備足夠的醫療知識,然后利用自身邏輯能力進行癥狀預測,并結合Prompt調優,作出適當取舍,然后完成問診過程。

Baichuan 3能當個不錯的中文醫生,原因在于模型預訓練階段匯集了達到千億Token的醫療相關數據,同時構建了一個含數十萬條記錄的醫療微調數據集。

同時,為了讓整體模型相關能力得到更好地激發,百川智能在模型推理階段針對Prompt做了系統性的研究和調優。

簡單來說,百川智能在醫療領域的秘訣=基礎模型能力+準確描述任務+恰當的示例樣本。

而Baichuan 3能寫唐詩、能仿宋詞,也是有苦功夫在背后,招式主要有三。

一方面,百川智能團隊自研了訓練推理雙引擎融合、多模型并行調度的PPO訓練框架,支持千億模型,效率比業界主流框架提升400%。

又將傳統強化學習中的多種穩定訓練的方法以及超參數調優的策略引入,實現連續穩定的Reward提升的訓練過程。

另一方面,團隊結合RLHF與RLAIF,也就是既要人類反饋,也要大模型自己反饋,然后生成高質量優質偏序數據,平衡數據質量和數據成本。

做到這兩點后,Baichuan 3實現了迭代式強化學習(Iterative RLHF&RLAIF)。

模型通過多次的強化學習版本爬坡,大大緩解原先強化學習起點模型(SFT后的模型)無法探索到優質結果限制效果的問題。

下一站,多模態和Agent

王小川曾公開表達過對大模型開發的看法,在他眼中,這個階段離不開算力、財力和智力的支持。

縱觀目前國內外的大模型創業賽道,百川智能的確是擁有著這三樣硬實力的玩家。

在這樣的條件基礎上,百川智能從去年4月公開亮相后,一直實際地向前推進。

并且節奏風格非常鮮明:平均每個月都有一款新模型對外面世。

對關注大模型賽道的人來說,每個月追更一次百川智能的大模型,變成了和翻一頁新的月歷一樣的平常事。

這次還打破自身常規地突然卷了一把,在新一年的第一個月尾緊急加更,甩出了Baichuan 3這一超千億版本,驚喜來得猝不及防。

量子位還打探到,多模態和Agent,是團隊未來會有更多探索的兩個方向。

而這應該就直接與明牌“超級應用”有關了。

從成立到現在9個月的時間里,百川智能有技術、有實力、有答卷、備受期望,毋庸置疑是技術性的一年。

而或許從現在開始,百川智能將要展現的另一面,就是有產品、有落地、有商用,實現技術模型到商用模型的飛輪閉環。

這或許也是為什么2024年剛開年,就有如此規模的基座模型迭代亮相。

百川智能要提速,技術勢能和產品動能要合體了。

- 誤入人均10個頂級offer的技術天團活動,頂尖AI人才的選擇邏輯我悟了2025-12-04

- DeepSeek-V3.2系列開源,性能直接對標Gemini-3.0-Pro2025-12-01

- 字節“豆包手機”剛開賣,吉利系進展也曝光了:首月速成200人團隊,挖遍華為小米榮耀2025-12-01

- 居然有21%的ICLR 2026評審純用AI生成…2025-11-30