居然有21%的ICLR 2026評(píng)審純用AI生成…

論文&評(píng)審出現(xiàn)惡性“AI循環(huán)”

衡宇 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

ICLR 2026,居然有21%的評(píng)審是純純由AI生成的?!

上面這個(gè)相當(dāng)扎心的答案,來自Pangram實(shí)驗(yàn)室的分析報(bào)告。

這件事被發(fā)現(xiàn)的起因頗具戲劇色彩:CMU的AI研究員Graham Neubig,感覺自己收到的同行評(píng)審AI味超級(jí)重。

他之所以起疑心,是因?yàn)檫@些評(píng)審內(nèi)容“非常冗長(zhǎng),且包含大量符號(hào)”,并且所要求的分析方式并非“審稿人通常在AI或ML論文中所要求的那種標(biāo)準(zhǔn)統(tǒng)計(jì)分析方式”。

做事嘛,不能光靠直覺,要真憑實(shí)據(jù)啦。

Graham Neubig自己干不了這個(gè)事兒,就在上發(fā)布了一個(gè)懸賞令,希望有人能做一輪系統(tǒng)性的檢測(cè),看ICLR的論文和審稿中到底夾雜了多少AI文本。

我愿意懸賞50美元,給第一個(gè)做了這件事的人~

Pangram實(shí)驗(yàn)室就是那個(gè)接黃榜的。

這個(gè)實(shí)驗(yàn)室的業(yè)務(wù)之一,正好是開發(fā)檢測(cè)AI生成文本的工具。

結(jié)論簡(jiǎn)單粗暴:

- 75800條評(píng)審中,15899條高度疑似完全由AI生成,占比21%。

- 大量論文正文中也檢測(cè)出AI參與的痕跡,有的論文甚至大半字?jǐn)?shù)都是AI的產(chǎn)出。

一個(gè)頂級(jí)AI學(xué)術(shù)會(huì)議,審稿和投稿兩頭都出現(xiàn)大規(guī)模AI代寫……

是怎么測(cè)出“AI味”的?

Pangram這次對(duì)ICLR的全部提交論文和所有評(píng)審做了系統(tǒng)分析,并且在博客中公開了全過程。

他們先在OpenReview上,把ICLR 2026的數(shù)據(jù)全部拉了下來,總計(jì)約19490篇論文投稿,以及75800條審稿意見。

這些論文多為PDF格式,普通PDF解析工具面對(duì)公式、圖表、行號(hào)、表格等內(nèi)容時(shí)容易抽風(fēng),會(huì)干擾后續(xù)的文本分析。所以常規(guī)的PDF解析器,比如PyMuPDF就用不了了。

于是Pangram用OCR模型(他們用的是Mistral OCR) 把PDF轉(zhuǎn)成Markdown,再統(tǒng)一轉(zhuǎn)成純文本,盡量減少格式噪音。

檢測(cè)兩類文本時(shí),Pangram實(shí)驗(yàn)室用了兩種不同的模型——

檢測(cè)論文正文時(shí),用的是extended text classifier。

具體流程是先把整篇論文按段落或語義片段切分成若干segment,判斷每個(gè)segment“更像人寫”還是“更像AI寫”。

之后匯總結(jié)果,得到整篇論文中AI生成內(nèi)容的大致比例,最后標(biāo)記出“人類為主”“混合寫作”“幾乎完全AI生成”“極端outlier”等類別。

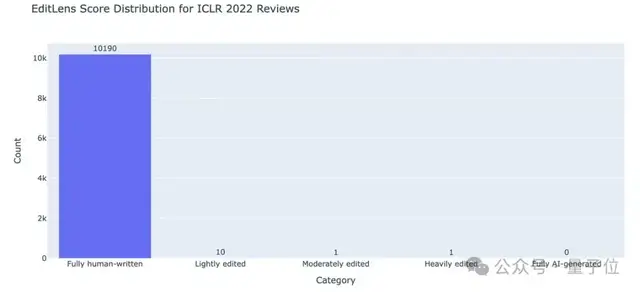

為了驗(yàn)證模型的準(zhǔn)確程度,Pangram還拿2022年之前的ICLR論文和NeurIPS論文做了測(cè)試。

結(jié)果顯示,這些論文由AI生成的概率是0%(盡管有部分論文用于模型訓(xùn)練)。

檢測(cè)評(píng)審內(nèi)容時(shí),使用了新模型EditLens。

這個(gè)模型除了判斷評(píng)審內(nèi)容是否為AI生成外,還嘗試判斷AI在其中的參與程度。

分為五個(gè)級(jí)別:完全人工撰寫、AI潤(rùn)色、中等程度AI編輯/輔助、AI重度參與、完全由AI生成。

在一個(gè)已知完全由人類撰寫的對(duì)照語料上,EditLens把純?nèi)祟悓懽鲀?nèi)容錯(cuò)判成AI潤(rùn)色過的內(nèi)容的誤報(bào)率,差不多是1/1000;錯(cuò)判成中等程度AI編輯/輔助內(nèi)容的誤報(bào)率是1/50000;錯(cuò)判成AI重度參與的錯(cuò)誤率是1/100000。

回到實(shí)驗(yàn)室對(duì)ICLR 2026論文和評(píng)審的檢測(cè),結(jié)果如下。

有15899篇評(píng)審?fù)耆葾I生成,占評(píng)審總數(shù)的21%。

此外,超過一半的評(píng)審涉及不同程度的AI參與行為。

此外,61%的ICLR 2026論文是人工撰寫的,但有199篇論文(占總數(shù)量的1%)完全由AI生成。

但實(shí)驗(yàn)室提到,部分完全由AI生成的論文,可能在此前已經(jīng)被ICLR拒稿了,不會(huì)出現(xiàn)在OpenReview中。

AI頂會(huì)審稿正陷入一種奇妙的惡性循環(huán)

Pangram表示,他們做這個(gè)事情當(dāng)然是因?yàn)橛袀€(gè)懸賞貼在(doge),但并不是為了“點(diǎn)人名、批判某幾個(gè)個(gè)體”,而是希望揭示一個(gè)趨勢(shì),一種現(xiàn)象。

ICLR 2026高級(jí)項(xiàng)目主席、康奈爾大學(xué)伊薩卡分校副教授Bharath Hariharan表示,這是ICLR首次大規(guī)模遇到此類問題。

ICLR開始用自動(dòng)化工具,來評(píng)估提交的論文和同行評(píng)審是否違反了會(huì)議規(guī)定。

是的,其實(shí)ICLR對(duì)論文和評(píng)審中使用AI/禁止使用AI有非常清晰和詳細(xì)的規(guī)定。

首先,如果使用了AI,必須披露,需要遵循“所有對(duì)研究的貢獻(xiàn)都必須得到承認(rèn)”和“貢獻(xiàn)者應(yīng)該期望……獲得對(duì)其工作的認(rèn)可”的道德準(zhǔn)則政策。

其次,ICLR作者和評(píng)審者最終對(duì)其貢獻(xiàn)負(fù)責(zé),遵循“研究人員不得故意做出虛假或誤導(dǎo)性聲明,編造或篡改數(shù)據(jù),或歪曲結(jié)果”的道德準(zhǔn)則政策。

同時(shí),ICLR還規(guī)定了作者在使用AI撰寫論文和進(jìn)行評(píng)審時(shí)應(yīng)遵循的指南。

總結(jié)來說,論文作者可以用AI幫自己撰寫論文,或者配合自己做研究,但必須聲明自己使用了AI,并對(duì)論文的科學(xué)性和誠(chéng)信負(fù)責(zé)。

同行可以用AI潤(rùn)色自己的評(píng)審,但純用AI寫評(píng)審可能違反道德準(zhǔn)則,因?yàn)檫@既不是同行本人的觀點(diǎn)而是外部意見,也違反了保密原則。

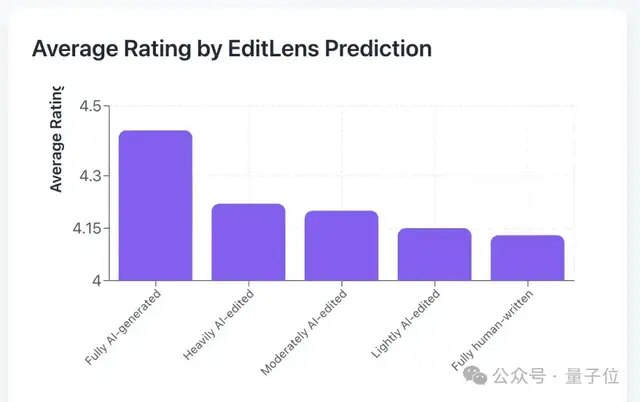

值得一提的是,Pangram實(shí)驗(yàn)室還把“AI 使用程度”和“評(píng)審分?jǐn)?shù)”做了關(guān)聯(lián)。

結(jié)果呈現(xiàn)出來的是兩個(gè)相當(dāng)微妙的趨勢(shì):

第一,論文中AI內(nèi)容越多,平均收到的審稿評(píng)分就越低。

這可能意味著現(xiàn)階段的AI寫作,還是無法代替人類原創(chuàng)的論文的質(zhì)量。

第二,審稿中AI參與程度越高,給出的評(píng)分就會(huì)越高。

換句話說,AI審稿更傾向于寬松友好的態(tài)度,評(píng)分就會(huì)偏高。

此外,AI生成的審稿內(nèi)容往往字?jǐn)?shù)較多,但信息密度低,建設(shè)性建議少,評(píng)論很多都很空洞,要不就是一堆車轱轆話。

這和以前 “長(zhǎng)審稿=高質(zhì)量審稿” 的情況完全相反。

而且論文作者們?yōu)榱烁玫豶ebuttal,一定會(huì)很認(rèn)真地看評(píng)審意見。結(jié)果可能就是讀了一些又長(zhǎng)又沒用的屁話,攤手。

這真的很消耗同行之間的信任。

怎么判斷你得到的review是不是AI生成的?

Pangram實(shí)驗(yàn)室總結(jié)了一些AI生成的評(píng)審內(nèi)容的特點(diǎn),供大家參考,判斷自己得到的review人工含量高不高。

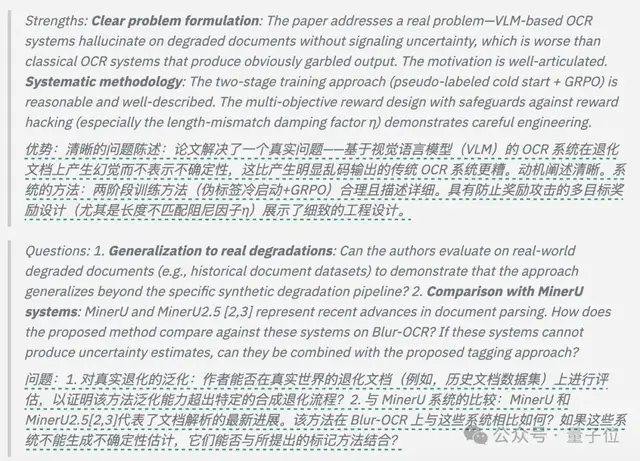

先說標(biāo)題。

AI生成的同行評(píng)審喜歡用粗體章節(jié)標(biāo)題,標(biāo)題往往由2-3個(gè)摘要標(biāo)簽組成,后面會(huì)跟冒號(hào)。

一個(gè)例子:

整體內(nèi)容上,AI生成的評(píng)審內(nèi)容總是吹毛求疵,沒給出啥真正的分析。

這些評(píng)審基本都在關(guān)注表面問題。典型的AI評(píng)審內(nèi)容包括提出讓論文作者做更多已展示的消融實(shí)驗(yàn)、要求增加測(cè)試集大小或控制數(shù)量,或要求提供更多示例。

當(dāng)然,最明顯的就是說一些沒啥用的片湯話,讓人聽君一席話,如聽一席話那種。

不過,一個(gè)新的問題出現(xiàn)了。

正如芝加哥大學(xué)經(jīng)濟(jì)學(xué)家 Alex Imas最近一條推文中說的那樣:

我們是否希望在同行評(píng)審中包含人類判斷?

One More Thing

又有坑慘階躍AI研究員的蘋果論文,又有雙盲評(píng)審制度一夜失效的bug,現(xiàn)在還有這么大規(guī)模的AI評(píng)審內(nèi)容被揪出來……

今年的ICLR真的是抓馬十足,而且開盒事件的余波還沒有完全平息。

能理解大家知道是誰給自己的論文打低分后,情感上絕對(duì)會(huì)感覺到被背刺。

但事后值得關(guān)注的重中之重,還是“如何保證雙盲評(píng)審能繼續(xù)按規(guī)則施行”,任何頂會(huì)都不要再有這種驚天bug發(fā)生。

這關(guān)乎到整個(gè)學(xué)術(shù)共同體,是大家要一起面對(duì)的問題。

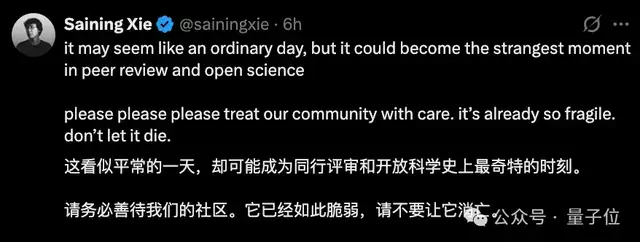

就像謝賽寧說的那樣,“請(qǐng)務(wù)必善待我們的社區(qū)。它已經(jīng)如此脆弱,請(qǐng)不要讓它消亡。”

參考鏈接:

[1]https://www.pangram.com/blog/pangram-predicts-21-of-iclr-reviews-are-ai-generated

[2]https://www.nature.com/articles/d41586-025-03506-6