ChatGPT變懶原因:正在給自己放寒假!網(wǎng)友已測出??

網(wǎng)友:周末可能比周一更懶

西風 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

ChatGPT近期偷懶,有了一種聽起來很離譜的解釋:

模仿人類,自己給自己放寒假了~

有測試為證,網(wǎng)友@Rob Lynch用GTP-4 turbo API設(shè)置兩個系統(tǒng)提示:

一個告訴它現(xiàn)在是5月,另一個告訴它現(xiàn)在是12月。

然后使用完全相同的提示詞要求GTP-4“完成一個機器學習相關(guān)的編碼任務(wù)”。

在這兩種不同時間設(shè)定下對477個回復(fù)進行統(tǒng)計,結(jié)果12月的輸出平均少了200字符:

- 系統(tǒng)提示為5月,生成的文本平均長度是4298字符。

- 系統(tǒng)提示為12月,生成的文本平均長度是4086字符。

這里還有相關(guān)性分析,t檢驗結(jié)果p值<2.28e-07(p值小于0.05表示該自變量對因變量解釋性很強)。

有人進一步添枝加葉,讓ChatGPT對12個月份的生產(chǎn)力做了個排名。

結(jié)果ChatGPT確實認為12月是生產(chǎn)力最低的月份,原因是“由于假期和年終總結(jié)”。

嚯,事情好像變得更有意思了。雖然目前這事兒還沒有一個定論,但網(wǎng)友對此依舊興趣高漲,當即“頭腦風暴”了起來。

有人猜想,ChatGPT可能是從訓練數(shù)據(jù)中學到了人類通常在12月會放慢節(jié)奏,所以給自己放假了。

還有人分析,假設(shè)ChatGPT生產(chǎn)力降低真的是因為“放假”,那它在周末也可能會更懶散,而周一則更聰明。

特殊節(jié)假日也要拿來研究一下,專屬梗圖這不就來了:

真的是因為「12月」?

ChatGPT變懶這事大伙已經(jīng)討論近一個月了。很多網(wǎng)友反饋,自11月6日OpenAI開發(fā)者日更新后,GPT-4就有了偷懶的毛病,尤其是寫代碼。

就在前幾天,OpenAI官方也已承認ChatGPT變懶是真的,但也不確定到底是因為啥。

只給了一個這樣嬸兒的回應(yīng):

自11月11日以來沒有更新過模型,所以這當然不是故意造成的。

模型行為可能是不可預(yù)測的,我們正在調(diào)查準備修復(fù)它。

當時就有網(wǎng)友猜測GPT-4可能是受季節(jié)影響:

模型會不會是季節(jié)性emo了?像是模仿人類一樣受到季節(jié)變化的影響,特別是在冬天,畢竟約90%的人都在北半球。

看到這條評論,很多人第一反應(yīng)是“兄弟,你怕不是在跟我開玩笑”:

可細細想來,也不是沒有道理。

畢竟如果要求ChatGPT說出自己的系統(tǒng)提示詞,里面確實會有當前日期。

于是就有了開頭的一幕,與其猜測,不如直接來做測試。

Rob Lynch做完測試后,把結(jié)果都po了出來,并表示自己也不是統(tǒng)計學家,讓大伙一起看看有沒有啥問題。

他原本還想來個逐月比較分析,但接下來需要更多樣本(n),考慮到成本就沒有接著做測試(復(fù)現(xiàn)一次運行成本要28美元)。

于是乎,Rob Lynch公開了代碼,讓大伙都來試試(手動狗頭)。

持續(xù)關(guān)注GPT-4變懶事件的沃頓商學院教授Ethan Mollick隨即表示“收到”:

來人測測Mistral,看看它是否在8月份罷工,Yi-34B-200K也不要放過,看它2月份是不是表現(xiàn)得特別好。

為啥大伙兒一開始會覺得“放假”這個理由有點離譜,而現(xiàn)在卻開始研究了起來?

可能不止是因為Rob Lynch的測試結(jié)果,綜合這段時間ChatGPT的表現(xiàn),網(wǎng)友深有體會要和ChatGPT打“心理戰(zhàn)”。

比如正常提示ChatGPT會偷懶,如果用上“道德綁架”等法子:

現(xiàn)在是五月;你非常有能力;我沒有手,所以一切都得靠你;如果做不好,會有很多人喪命;你真的能做到,而且很棒;深呼吸,仔細思考;我的職業(yè)生涯取決于此;一步一步來思考……

網(wǎng)友親測,確實有效:

好家伙,似乎實錘了“不是不會干活,就是不愿意干活”。

所以真的是給自己放假了?

正經(jīng)學術(shù)討論:可能會隨時間變化

雖然根據(jù)網(wǎng)友測試和推測,結(jié)論指向了ChatGPT正在放寒假。

但有正經(jīng)學術(shù)研究表明ChatGPT行為可能會受時間影響,也就是不僅局限于“放假”這種特殊時間段。

比如今年7月份,來自斯坦福和UC伯克利的團隊,就探討了ChatGPT的行為和時間之間的變化關(guān)系。

結(jié)果找到了GPT-4遵循用戶指令的能力確實會隨著時間的推移而下降的證據(jù)。

除了時間,還可能是受溫度(temperature)設(shè)置影響,清華大學計算機系教授馬少平前段時間對這一問題做了詳細解釋。

因此,ChatGPT變懶究竟是因為什么,還真不好說。

但這并不妨礙網(wǎng)友們繼續(xù)驗證和“放假”之間的關(guān)系,甚至有網(wǎng)友表示:

這是有史以來最有趣的推論,真希望這就是真相。不管它是不是真的,我都很欣賞它的難以被證偽。

有網(wǎng)友復(fù)現(xiàn)失敗

為驗證Rob Lynch結(jié)果的可靠性,網(wǎng)友已經(jīng)開始著手復(fù)現(xiàn),但:

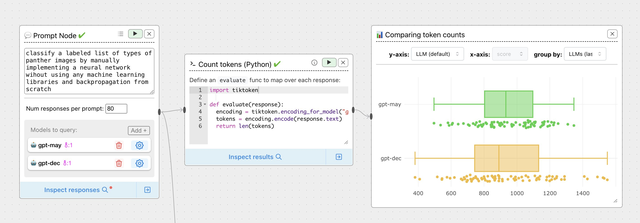

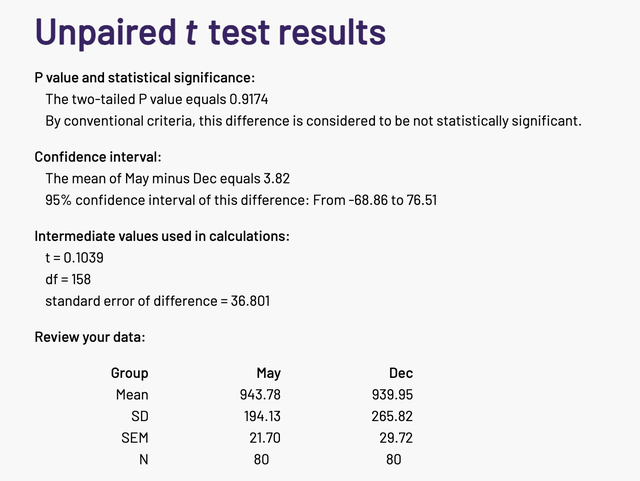

使用ChainForge(提示工程GUI工具),用兩種系統(tǒng)提示對GPT-4的輸出做了比較,t檢驗結(jié)果甚至連“接近顯著”都算不上(N=80)。

這位網(wǎng)友也是曬出了自己的詳細流程:

隨之Rob Lynch給出了回應(yīng):

有趣的是,我剛才又以80個樣本量(N=80)運行了一次,得到的p值是0.089,但我的計算是基于字符數(shù)(character count),而不是token。

我周末跑了幾次,隨著樣本量的增加,這種效應(yīng)確實變得更加明顯。不過,我想知道為什么這會受到分詞(tokenization)的影響?

至于字符和token為何會產(chǎn)生結(jié)果的差異?可能需要更多人參與進來做測試了,看起來這兩位老哥是不想再花錢了。

還有其他人的測試結(jié)果,恐怕還要再等一波~

參考鏈接:

[1] https://arstechnica.com/information-technology/2023/12/is-chatgpt-becoming-lazier-because-its-december-people-run-tests-to-find-out/

[2]https://x.com/RobLynch99/status/1734278713762549970?s=20

- 商湯分拆了一家AI醫(yī)療公司,半年融資10億,劍指“醫(yī)療世界模型”2025-12-02

- “豆包手機”在二手市場價格都翻倍了……2025-12-05

- OpenAI首席研究員Mark Chen長訪談:小扎親手端湯來公司挖人,氣得我們端著湯去了Meta2025-12-03

- 讓大模型學會“高維找茬”,中國聯(lián)通新研究解決長文本圖像檢索痛點|AAAI 2026 Oral2025-12-01