李飛飛點贊「ARM」:一種讓模型快速適應數據變化的元學習方法 | 開源

伯克利&斯坦福出品

魚羊 編譯整理

量子位 報道 | 公眾號 QbitAI

訓練好的模型,遇到新的一組數據就懵了,這是機器學習中常見的問題。

舉一個簡單的例子,比如對一個手寫筆跡識別模型來說,它的訓練數據長這樣:

那么當它遇到來自另一個用戶的筆跡時,這究竟是“a”還是“2”呢?

說實話,即使是人類,如果沒看到該用戶單獨寫了一個寫法不同的“2”(圖中紅框),也很可能辨認失誤。

為了讓模型能夠快速適應這樣的數據變化,現在,來自伯克利和斯坦福的研究人員,提出用元學習的方法來解決這個問題。

還獲得了李飛飛的點贊轉發。

不妨一起來看看,這一次元學習這種“學習如何學習的方法”又發揮了怎樣的作用。

自適應風險最小化(ARM)

機器學習中的絕大多數工作都遵循經驗風險最小化(ERM)框架。但在伯克利和斯坦福的這項研究中,研究人員引入了自適應風險最小化(ARM)框架,這是一種用于學習模型的問題公式。

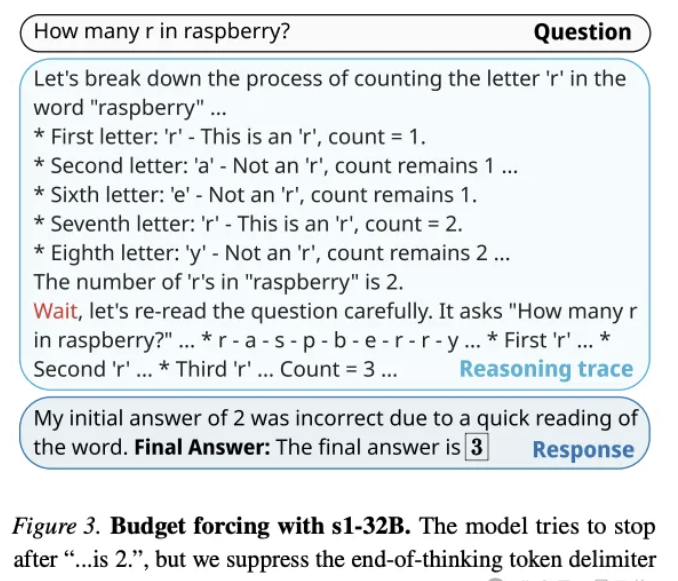

ARM問題設置和方法的示意圖如下。

在訓練過程中,研究人員采用模擬分布偏移對模型進行元訓練,這樣,模型能直接學習如何最好地利用適應程序,并在測試時以完全相同的方式執行該程序。

如果在測試偏移中,觀察到與訓練時模擬的偏移相似的情況,模型就能有效地適應這些測試分布,以實現更好的性能。

在具體方法的設計上,研究人員主要基于上下文元學習和基于梯度的元學習,開發了3種解決ARM問題的方法,即ARM-CML,ARM-BN和ARM-LL。

如上圖所示,在上下文方法中,x1,x2,…,xK被歸納為上下文c。模型可以利用上下文c來推斷輸入分布的額外信息。

歸納的方法有兩種:

- 通過一個單獨的上下文網絡

- 在模型自身中采用批量歸一化激活

在基于梯度的方法中,一個未標記的損失函數L被用于模型參數的梯度更新,以產生專門針對測試輸入的參數,并能產生更準確的預測結果。

優于基線方法

所以,自適應風險最小化(ARM)方法效果究竟如何?

首先,來看ARM效果與各基線的對比。

在4個不同圖像分類基準上的比較結果顯示,無論是在最壞情況(WC)還是在平均性能上,ARM方法都明顯具更好的性能表現和魯棒性。

另外,研究人員還進行了定性分析。

以開頭提到的“2”和“a”的情況舉例,使用一個batch的50張無標注測試樣本(包含來自同一用戶的“2”和“a”的筆跡),ARM方法訓練的模型就能夠成功將兩者區分開。

這就說明,訓練自適應模型確實是處理分布偏移的有效方法。

這項研究已經開源,如果你感興趣,文末鏈接自取,可以親自嘗試起來了~

傳送門

論文地址:

https://arxiv.org/abs/2007.02931

開源地址:

https://github.com/henrikmarklund/arm

博客地址:

https://ai.stanford.edu/blog/adaptive-risk-minimization/

— 完 —

- 蘋果芯片主管也要跑路!庫克被曝出現健康問題2025-12-07

- 世界模型和具身大腦最新突破:90%生成數據,VLA性能暴漲300%|開源2025-12-02

- 谷歌新架構突破Transformer超長上下文瓶頸!Hinton靈魂拷問:后悔Open嗎?2025-12-05

- 90后華人副教授突破30年數學猜想!結論與生成式AI直接相關2025-11-26