世界模型和具身大腦最新突破:90%生成數據,VLA性能暴漲300%|開源

具身智能邁入“數據高效、高泛化、低成本”新階段

允中 發自 凹非寺

量子位 | 公眾號 QbitAI

VLA模型性能暴漲300%,背后訓練數據還首次實現90%由世界模型生成。

這是來自國產世界模型玩家的最新突破,相關模型代碼和訓練框架還全都開源了。

具身智能邁向開放世界落地的最大瓶頸,長期以來并非算法本身,而是高質量、大規模真實機器人交互數據的極度稀缺。

真機數據采集成本高昂、周期漫長,且難以覆蓋多樣化的開放場景,嚴重限制了VLA大模型的規模化訓練與泛化能力。而傳統仿真雖能快速生成數據,卻受限于顯著的Sim-to-Real gap,難以支撐真實世界的魯棒部署。

世界模型(World Model)被認為是破解這一困境的關鍵:通過學習真實世界的規律,世界模型可以生成高保真、可控、多樣化的具身交互數據,突破真機數據不足的限制。

在此背景下,剛剛獲得華為投資的國產世界模型公司極佳視界發布并開源具身世界模型GigaWorld-0,成功將世界模型生成數據在VLA訓練中的占比提升至90%。

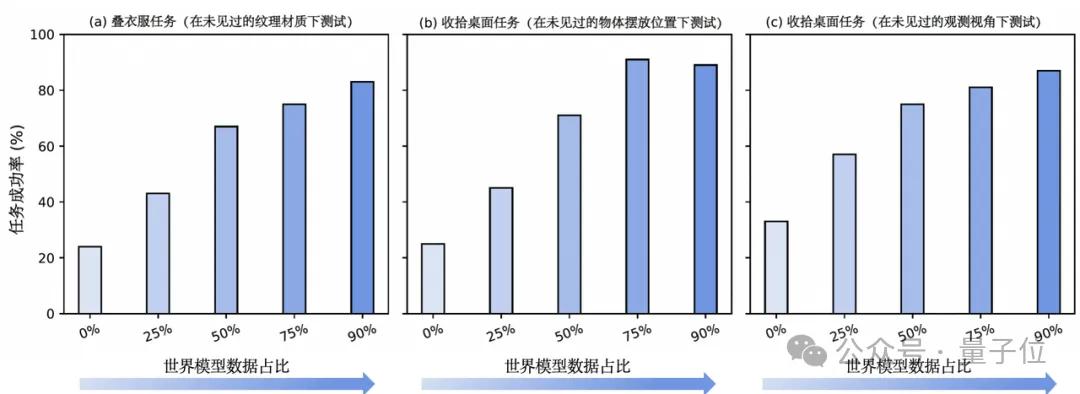

所訓練的VLA模型在新紋理(訓練中未見材質表面)、新視角(訓練中未見的觀測角度)、新物體位置(訓練中未見的空間布局)三大泛化維度上均實現近300%的性能提升,標志著具身智能正式邁入“數據高效、高泛化、低成本”的新階段。

作為具身智能邁向規模化與數據高效的關鍵基礎設施,GigaWorld-0由兩大協同組件構成:

- GigaWorld-0-Video基于視頻生成基座模型,生成紋理豐富、視覺逼真具身操作數據;

- GigaWorld-0-3D則融合3D生成、3D Gaussian Splatting重建、可微分物理引擎,確保生成數據在幾何結構與物理動力學的準確性。

高效的世界模型架構

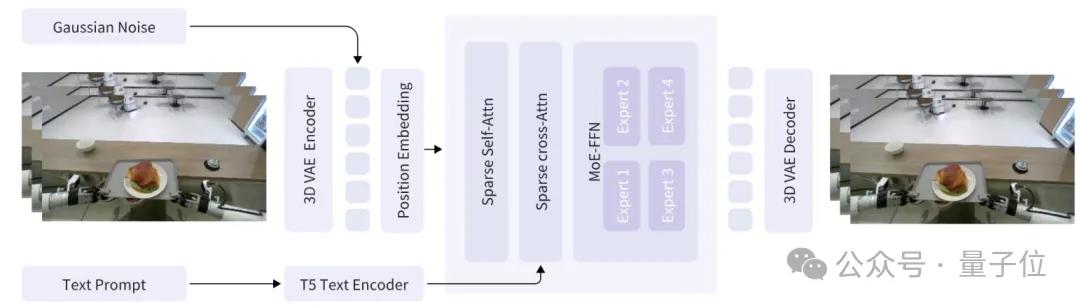

針對當前世界模型在生成時面臨的計算效率低、細節控制不足等挑戰,GigaWorld-0-Video重點提升了稀疏注意力建模能力與動態專家計算能力,在保持視覺保真度的同時顯著降低計算開銷,為VLA模型提供高質量、可擴展的合成訓練數據。

稀疏注意力機制:高效建模長程時空依賴

GigaWorld-0-Video采用基于稀疏注意力的Diffusion Transformer(DiT)作為生成主干,摒棄傳統全注意力帶來的平方級計算復雜度。

該機制僅在局部時空鄰域與關鍵語義區域間建立注意力連接,從而在生成高幀率、長序列視頻時,顯著降低內存占用與推理延遲。

MoE架構:提升生成多樣性與可控性

在DiT的前饋網絡模塊中,GigaWorld-0-Video參考DeepSeek V3集成混合專家(Mixture-of-Experts,MoE)架構。

每個視頻Token動態路由至多個專家網絡。確保不同語義區域由專屬專家處理,實現細粒度的內容控制。

幾何一致、物理準確的世界模型建模

GigaWorld-0-3D通過融合生成與重建技術,顯著提升了在稀疏觀測條件下的場景建模能力,并結合可微分物理引擎,實現了對機械臂操作過程的高保真物理仿真。

該系統不僅生成幾何一致、視覺逼真的靜態背景資產,還精準復現了機械臂與物體交互中的動力學行為,為具身智能體提供兼具幾何一致性與物理準確性的訓練數據。

生成式重建:幾何一致性與視覺保真度的協同優化

在幾何一致性渲染方面,GigaWorld-0-3D融合極佳視界積淀的生成式重建技術,有效突破稀疏觀測下的建模瓶頸。

系統首先基于稀疏輸入視圖,初始化高斯場景表示。隨后引入專用的視圖修復生成模型,顯著緩解因視角缺失導致的幾何扭曲。最終,將修復后稠密、一致的多視角圖像作為增強輸入,驅動第二階段的高精度3DGS重建,從而在新視角合成中同時保障幾何一致性與視覺保真度。

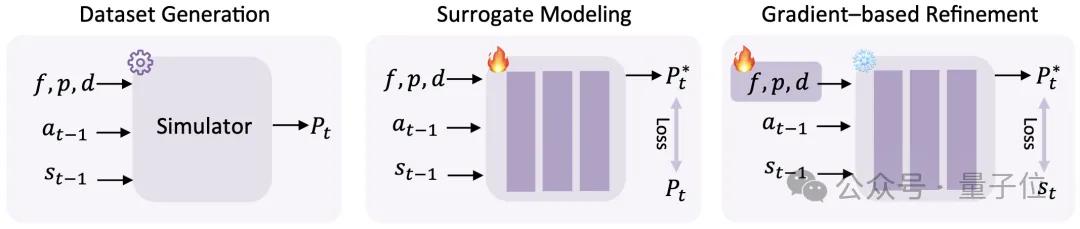

可微分物理引擎:高效精準的物理建模

在物理準確性建模方面,GigaWorld-0-3D引入基于物理信息神經網絡(PINNs)的可微分物理引擎,實現對機械臂動力學的自動參數辨識。

通過三步流程:以隨機物理參數生成仿真軌跡、訓練可微替代模型逼近系統動力學、再以梯度下降優化參數匹配真實運動,高效生成物理合理、交互可信的數據。

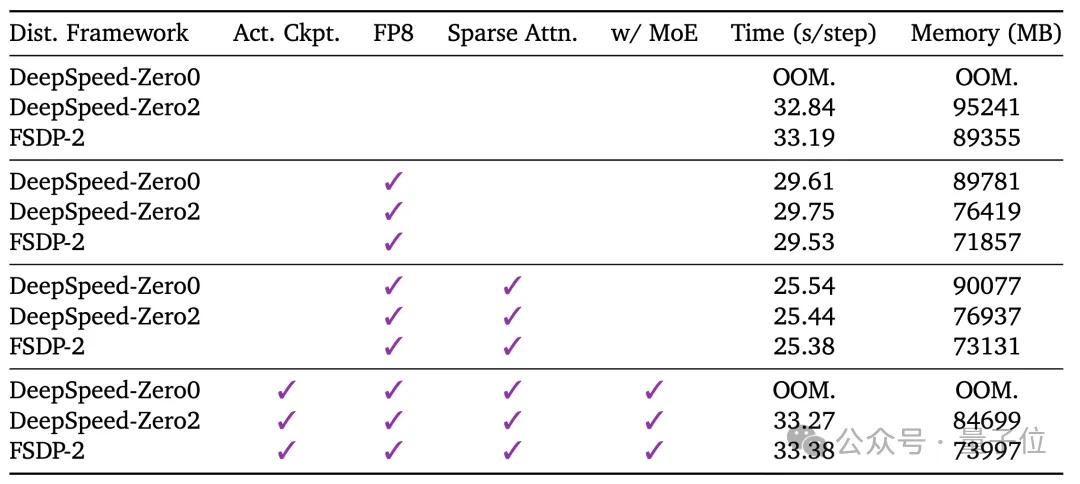

高效世界模型訓練框架

GigaWorld-0是業內首個采用FP8精度端到端訓練的世界模型,標志著世界模型訓練邁入高能效新階段。

通過將FP8與稀疏注意力深度結合,GigaWorld-0在保持生成質量的同時,顯著降低顯存占用與訓練成本,實現了視覺保真度與計算效率的最佳平衡。

為這一突破提供基礎的,是極佳視界自研的GigaTrain高效訓練框架。

GigaTrain是一個為大規模生成模型量身打造的統一分布式訓練系統,支持DeepSpeed ZeRO、FSDP2、FP8混合精度、梯度檢查點等先進訓練技術,既可支撐超大規模預訓練,也能在8×H20等常規硬件上高效完成微調。

GigaTrain現已全面開源(GitHub:https://github.com/open-gigaai/giga-train),極佳視界還同步開放了詳細的資源消耗基準與配置模板,助力社區開發者快速復現、遷移并定制GigaWorld-0,推動具身智能數據生成的普惠化與標準化。

可泛化具身數據引擎

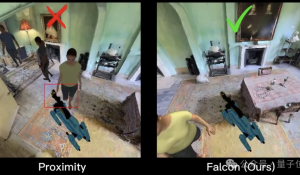

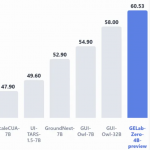

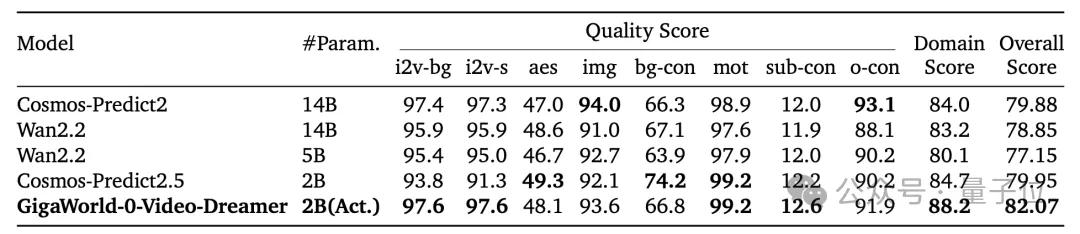

在PBench(Robot Set)基準上,研究團隊將GigaWorld-0與當前最先進的世界模型進行了全面對比,包括Cosmos-Predict2-14B、Cosmos-Predict2.5-2B、Wan2.2-5B和Wan2.2-14B。

盡管GigaWorld-0模型僅激活20億參數(2B),為所有對比模型中最小,卻在整體評分上顯著領先,取得最高性能。

這一結果證明GigaWorld-0在具身智能任務中兼具生成質量與推理效率,是目前極具性價比的世界模型方案。

GigaWorld-0的價值還不僅體現在高質量視頻與3D場景的生成能力上,更關鍵的是其作為可泛化具身數據引擎在真實世界中的有效性。

在VLA模型GigaBrain-0上,研究團隊系統性地驗證了GigaWorld-0生成數據對下游具身智能任務的提升作用。實驗在真實機器人平臺上進行,聚焦三大開放世界泛化挑戰:新紋理泛化、新視角泛化、與新物體位置泛化。

結果表明:隨著GigaWorld-0生成數據在訓練混合數據中比例的提升,GigaBrain-0在上述三類泛化場景下的任務成功率與動作精度均呈現顯著且穩定的增長趨勢。

項目鏈接:

https://giga-world-0.github.io/

論文鏈接:

https://arxiv.org/pdf/2511.19861

代碼鏈接:

https://github.com/open-gigaai/giga-world-0

關于極佳視界

極佳視界成立于2023年,是國內第一家“純血”物理AI公司——創業就以世界模型為切入點,專注于「世界模型平臺 x 具身基礎模型」,致力以雙輪閉環走向物理世界通用智能。

在「世界模型」方向,極佳視界是國內技術創新和產業落地的領跑者,相關產品技術已廣泛應用于自動駕駛、具身智能、內容創作等相關方向。

在「具身大腦」方向,極佳視界通過全球領先的「世界模型平臺」提供大規模高質量閉環數據,相比純真機數據訓練效率提升1-2個數量級以上,同時真機效果達到國內領先。

極佳視界的創始人兼CEO黃冠,是清華大學自動化系AI方向博士。曾擔任地平線機器人視覺感知技術負責人、鑒智機器人合伙人&算法副總裁等知名企業技術和高管崗位,并擁有三星中國研究院、微軟亞洲研究院等頂尖研究機構工作經歷。

黃冠之外,聯合創始人、首席科學家朱政同樣有清華自動化系背景。他2019年博士畢業于中國科學院自動化研究所,此后在清華大學自動化系從事博士后研究。Google Scholar顯示,朱政的論文被引數達到1.7w+,h-index為50。

公司核心團隊還包括清華、北大、中科院、中科大、WashU、CMU等全球知名院校頂尖研究人員,以及來自微軟、三星、地平線、百度、博世、NBC環球影業等全球知名企業高管,核心團隊兼具業內領先的研究能力和大規模的產業落地經驗。

目前,極佳視界是國內少有在「世界模型」和「具身大腦」方向都擁有世界級綜合實力的團隊,在自動駕駛世界模型方向已經和多個頭部主機廠達成簽約合作,在具身世界模型、具身大腦等方向已經和多個具身本體、終端公司達成簽約合作,應用于科研、教育、展覽、數據采集、工業、服務、家庭等多個場景。

就在11月,極佳視界剛剛完成億元級A1輪融資,由華為哈勃、華控基金聯合投資。這也是該公司兩個月內連續完成的第三輪融資。

— 完 —

- 蘋果芯片主管也要跑路!庫克被曝出現健康問題2025-12-07

- 谷歌新架構突破Transformer超長上下文瓶頸!Hinton靈魂拷問:后悔Open嗎?2025-12-05

- 90后華人副教授突破30年數學猜想!結論與生成式AI直接相關2025-11-26

- 首位“80后”院士,來自北大數院2025-11-22