Transformer出逃八子最后一人正式創(chuàng)業(yè)!坐標日本搞AI“群”模型,本人:在谷歌有被困住的感覺

要做世界級AI研究實驗室

蕭簫 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

谷歌經(jīng)典Transformer論文8位作者的最后一位,創(chuàng)業(yè)去向已定!

新公司base東京,目標是做一家“世界級人工智能研究室”,目前已知的創(chuàng)始成員有兩位,Transformer作者Llion Jones和另一位谷歌前同事。

Llion Jones表示,雖然對谷歌沒有惡意,但這家公司確實讓他有“被困住的感覺”:

谷歌已經(jīng)發(fā)展到了一種規(guī)模,讓我覺得在里面我什么都做不了。

我發(fā)現(xiàn)自己總在找各種軟件出bug的原因,以及這個bug是誰寫的……這極大地分散了我研究的注意力。

此次出來創(chuàng)業(yè),AI圈全是祝福聲,從英偉達高級AI科學家Jim Fan到也從谷歌離職創(chuàng)業(yè)的高產研究員Yi Tay,都在線表示了自己的祝福。

有網(wǎng)友羨慕稱:這正是我想做的那種研究!

所以,Llion Jones創(chuàng)辦的新公司究竟要做什么,在創(chuàng)辦新公司之前他又有哪些值得一提的研究?

Transformer八子最后一人出走

創(chuàng)業(yè)之前,Llion Jones在谷歌已經(jīng)干了8年。

他本碩畢業(yè)于伯明翰大學,在Delcam、油管、谷歌都工作過,谷歌是他待得最久的一家公司。

據(jù)FourWeekMBA介紹稱,在他之前的工作經(jīng)歷中,“曾兩度與谷歌的工作擦肩而過”。

第一次是他剛畢業(yè)找工作時,雖然投了谷歌倫敦軟件工程師的簡歷,并通過了兩輪電話面試,但最終相比谷歌,他選擇了位于英國的CAD/CAM軟件公司Delcam。

第二次是工作18個月后,他又接到了谷歌的招聘電話,詢問他是否想重新申請,但他依舊沒去谷歌,而是隨后加入了YouTube。

在Youtube做三年軟件工程師期間,他對人工智能產生興趣,自學了Coursera的機器學習課程,并終于在2015年的時候加入谷歌研究院,擔任里面的高級軟件工程師。

也正是在此期間,他與其他七名作者一起發(fā)表了那篇著名的Transformer論文Attention Is All You Need。

這篇論文如今已經(jīng)成為大部分大模型的“奠基研究”,引用次數(shù)達到8.5w+。

隨后,Llion Jones還與其他研究人員一起,發(fā)表了名為Natural Questions: A Benchmark for Question Answering Research的一篇論文。

這篇論文提出了第一個公開可用的自然語言問答數(shù)據(jù)集,這些語料由谷歌搜索引擎收到的查詢問題構成,一共有30多萬個樣本。

目前,這篇論文的引用已經(jīng)達到1300+次。

除此之外,Llion Jones也在谷歌參與了不少研究,包括ProtTrans、Tensor2Tensor等。

之所以選擇離開谷歌,是因為公司目前已經(jīng)發(fā)展到一種規(guī)模,使得他無法繼續(xù)進行自己想做的工作。

除了每天都在浪費精力排查其他人的bug,他還需要花時間從這家公司中找資源,試圖獲得訪問某些數(shù)據(jù)的權限。據(jù)彭博社采訪Llion Jones稱:

遺憾的是,我確實感到自己在谷歌之外(的事情中)干活效率更高。

因此,在這家互聯(lián)網(wǎng)巨頭工作多年后,他意識到自己還是想做一家初創(chuàng)公司,而不是離職加入OpenAI等其他AI公司。

畢竟在Llion Jones眼中,OpenAI從微軟和其他投資者那里籌集了數(shù)十億美元后,現(xiàn)在正在靠近谷歌這樣的互聯(lián)網(wǎng)巨頭,其創(chuàng)新力同樣正在減弱。

目前Llion Jones在東京已有一段時間,在領英上可以看見,他還給自己起了個日文名ライオン(獅子),也和英文名發(fā)音有所對應。

所以,這個在日本的新公司究竟要做什么?

新公司要做“AI集群”

這個新公司名叫sakana.ai,其中sakana是日語“魚”(さかな)的羅馬讀音。

顧名思義,sakana.ai在做的事情也像“魚群”一樣:

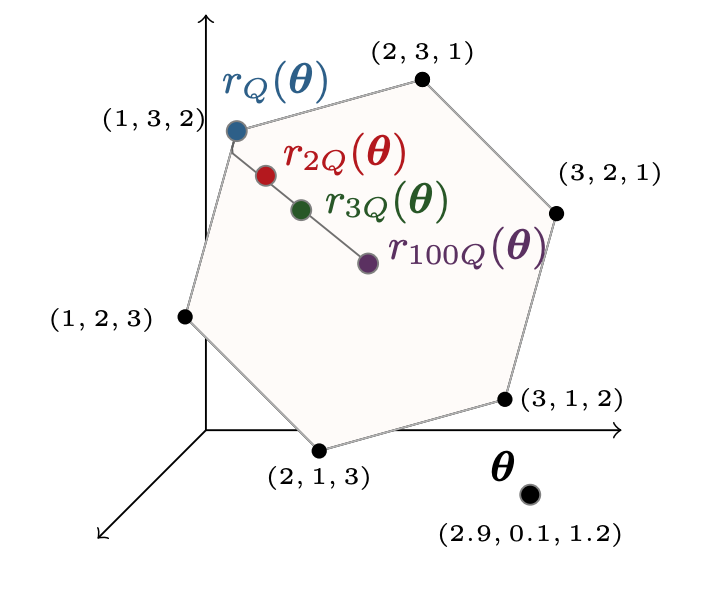

大自然中的魚會基于某種簡單的規(guī)則成群活動。因此,AI們也能借鑒它們的思想,無需更大的體積就能完成很復雜的任務。

具體來說,公司計劃開發(fā)一種基于自然啟發(fā)智能(nature-inspired intelligence)的基礎模型,借鑒自然領域中的“進化”和“集體智慧”思想,讓一群AI協(xié)作,類似于當前AI領域的生物啟發(fā)計算方向。

據(jù)《金融時報》介紹稱,Llion Jones認為,當前的AI模型之所以存在局限性,是因為它們被設計成無法改變的結構,這種結構往往是脆弱的。

相比之下,發(fā)揮“集體智慧”的自然系統(tǒng),對于周圍的變化非常敏感。基于此原理搭建的AI也會具有更好的安全性、更低的搭建成本。

雖然目前模型還沒有搭建起來,不過或許可以從兩位前谷歌研究員在2021年的共同研究找到一點參考信息:

這篇研究提出了一種叫做AttentionNeuron的網(wǎng)絡層,可以將每個輸入通道連接到一個獨立的神經(jīng)網(wǎng)絡模塊,通過注意力機制交流信息。

這樣即使輸入順序被隨機打亂,網(wǎng)絡輸出也是已知的,具有良好的魯棒性。

在自動駕駛環(huán)境CarRacing中測試表明,AttentionNeuron即使沒學習過環(huán)境內容,也可以實現(xiàn)一定程度上的自動駕駛,表現(xiàn)出一定的泛化能力。

這種AI具體如何落地應用?

一方面,這類AI也能像大模型一樣,用于生成文本、圖像、代碼等多個模態(tài)的內容;

另一方面,它也能給ChatGPT這樣的產品提供支持、協(xié)同更多大模型產品工作,實現(xiàn)能力上的“無縫銜接”。

目前,sakana.ai已經(jīng)建立了官網(wǎng),上面有一小段話的介紹,表示新公司將位于日本東京,“要做一個世界級的AI研究實驗室”。

之所以選擇東京,是因為北美那邊的生成式AI研究人員競爭非常激烈(手動狗頭),但在日本這邊也能找到一些高質量AI人才。

公司融資情況目前尚未透露,畢竟辦公室還沒搭起來。

不過據(jù)CNBC透露,sakana.ai目前已經(jīng)從學術圈聘請了一名兼職研究員,未來還將招攬更多人才。

One More Thing

其實,“Transformer八子”全部離職,今年7月已有征兆。

雖然Llion Jones的領英顯示,他在谷歌干到了今年8月:

不過就在7月份,論文Attention Is All You Need悄悄更新過一版arXiv,8名作者的郵箱(包括Llion Jones的谷歌郵箱)已經(jīng)全部被劃掉了:

(8月份這篇論文又更新了一版,所有郵箱都被加了回來)

至少在一個月前,8人全部離職創(chuàng)業(yè)的念頭就已經(jīng)塵埃落定了。

參考鏈接:

[1]https://sakana.ai/

[2]https://arxiv.org/pdf/1706.03762v6.pdf

[3]https://www.cnbc.com/2023/08/17/transformer-co-author-llion-jones-leaves-google-for-startup-sakana-ai.html

[4]https://www.ft.com/content/1f0cee71-2a44-4080-8c79-b037243ac6f5

[5]https://twitter.com/YesThisIsLion

- 首個GPT-4驅動的人形機器人!無需編程+零樣本學習,還可根據(jù)口頭反饋調整行為2023-12-13

- IDC霍錦潔:AI PC將顛覆性變革PC產業(yè)2023-12-08

- AI視覺字謎爆火!夢露轉180°秒變愛因斯坦,英偉達高級AI科學家:近期最酷的擴散模型2023-12-03

- 蘋果大模型最大動作:開源M芯專用ML框架,能跑70億大模型2023-12-07