超越ZIP的無損壓縮來了!華盛頓大學讓大模型成為無損文本壓縮器

用概率預(yù)測解決數(shù)據(jù)存儲難題

朔風 投稿

量子位 | 公眾號 QbitAI

當大語言模型生成海量數(shù)據(jù)時,數(shù)據(jù)存儲的難題也隨之而來。

對此,華盛頓大學(UW)SyFI實驗室的研究者們提出了一個創(chuàng)新的解決方案:LLMc,即利用大型語言模型自身進行無損文本壓縮的引擎。

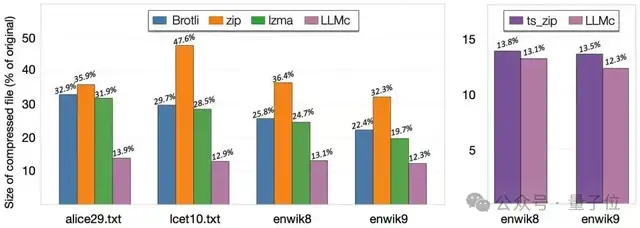

基準測試結(jié)果表明,無論是在維基百科、小說文本還是科學摘要等多種數(shù)據(jù)集上,LLMc的壓縮率都優(yōu)于傳統(tǒng)的壓縮工具(如ZIP和LZMA)。同時,與其他以LLM為基礎(chǔ)的閉源壓縮系統(tǒng)相比,LLMc也表現(xiàn)出同等甚至更優(yōu)的性能。

值得一提的是,該項目已經(jīng)開源,主要作者是來自上海交通大學ACM班的本科生Yi Pan,目前正在華盛頓大學實習。

LLMc的壓縮機制

LLMc的靈感來源于實驗室一年前的一次內(nèi)部討論。當時,研究者們面臨一個核心挑戰(zhàn):LLM推理中涉及的內(nèi)核操作具有高度的非確定性,這使得精確、可復(fù)現(xiàn)的壓縮和解壓變得困難。

但隨著業(yè)界在確定性LLM推理方面取得突破,這一問題迎刃而解,也為新引擎的誕生鋪平了道路。研究團隊順勢快速構(gòu)建了LLMc的原型,并成功證明用LLM進行高效壓縮的可行性。

LLM與數(shù)據(jù)壓縮之間的聯(lián)系根植于信息論的基本原理。

香農(nóng)的信源編碼定理(source coding theorem)指出,一個符號的最優(yōu)編碼長度與其負對數(shù)似然(negative log-likelihood)成正比。簡而言之,一個事件的概率越高,編碼它所需的信息量就越少。

由于LLM的核心任務(wù)是預(yù)測下一個詞元(token),一個優(yōu)秀的LLM能夠為真實序列中的下一個詞元賦予極高的概率。

這意味著,LLM本質(zhì)上就是一個強大的概率預(yù)測引擎,而這正是實現(xiàn)高效壓縮的關(guān)鍵。LLMc正是利用了這一原理,將自然語言的高維分布轉(zhuǎn)換為結(jié)構(gòu)化的概率信息,從而實現(xiàn)前所未有的壓縮效果。

LLMc的核心思想是一種名為“基于排序的編碼”(rank-based encoding)的巧妙方法。

在壓縮過程中,LLM會根據(jù)當前上下文預(yù)測下一個可能出現(xiàn)的詞元,并生成一個完整的概率分布列表。在大多數(shù)情況下,真實出現(xiàn)的那個詞元總是在這個預(yù)測列表的前幾位。

LLMc并不直接存儲詞元本身(例如其ID),而是存儲該詞元在概率排序列表中的“排名”(rank)。這些排名通常是非常小的整數(shù),因此占用的存儲空間極小。

在解壓時,系統(tǒng)使用完全相同的LLM和上下文來重現(xiàn)當時的概率分布。然后,它只需讀取之前存儲的“排名”,就能準確地從列表中選擇對應(yīng)的詞元,從而無損地恢復(fù)原始文本。

在這個過程中,LLM本身就像一個壓縮器和解壓器之間共享的、容量巨大的“密碼本”或參考系統(tǒng)。

挑戰(zhàn)與局限性

盡管LLMc取得了突破性的成果,但研究團隊也指出了當前版本存在的一些挑戰(zhàn)和局限性。

效率問題:LLM推理的計算復(fù)雜度與序列長度成二次方關(guān)系,且長序列推理受到內(nèi)存帶寬的限制。為了緩解這一問題,LLMc采用了分塊處理文本的策略,以提高GPU利用率并降低計算開銷。

吞吐量:由于嚴重依賴大規(guī)模模型推理,LLMc目前的處理速度遠低于傳統(tǒng)壓縮算法。

數(shù)值穩(wěn)定性:為了保證解壓過程的確定性,系統(tǒng)需要使用特殊的內(nèi)核(batch_invariant_ops),并對詞元排名進行整數(shù)編碼,而非直接使用對數(shù)概率。

應(yīng)用范圍:當前實現(xiàn)主要針對自然語言。如何將其擴展到圖像、視頻或二進制數(shù)據(jù)等其他模態(tài),是未來值得探索的方向。

參考鏈接:https://syfi.cs.washington.edu/blog/2025-10-03-llmc-compression/

Github網(wǎng)址: https://github.com/uw-syfi/LLMc

- 快手進軍AI編程!“模型+工具+平臺”一口氣放三個大招2025-10-24

- 匯報一下ICCV全部獎項,恭喜朱俊彥團隊獲最佳論文2025-10-22

- OpenAI以為GPT-5搞出了數(shù)學大新聞,結(jié)果…哈薩比斯都覺得尷尬2025-10-20

- 首創(chuàng)“AI+真人”雙保障模式!剛剛,百度健康推出7×24小時「能聊、有料、會管」AI管家2025-10-18