實測DeepSeek V3.1,不止拓展上下文長度

擊敗Claude成非推理模型SOTA,但價格便宜68倍

不圓 發自 凹非寺

量子位 | 公眾號 QbitAI

DeepSeek V3.1和V3相比,到底有什么不同?

官方說的模模糊糊,就提到了上下文長度拓展至128K和支持多種張量格式,但別急,我們已經上手實測,為你奉上更多新鮮信息。

我們比較了V3.1和V3,注意到它在編程表現、創意寫作、翻譯水平、回答語氣等方面都出現了不同程度的變化。

不過要說最明顯的更新,大概是DeepSeek網頁端界面的【深度思考(R1)】悄悄變成了【深度思考】。

手機端還在慢慢對齊(笑)

當前DeepSeek V3.1 Base可在抱抱臉上下載,也可通過網頁、APP和小程序使用完整版本。

開學考試現在開始

鑒于現在網頁端已全部替換成了V3.1,我們通過阿里云調用了DeepSeek V3的API(最大上下文長度還是65K)作為對比。

馬上就是開學季,我們給二個版本的模型出了一套“試卷”,從以下五個“學科”進行測試:

- 計算機:編程能力

- 語文:情境寫作

- 數學:理解應用

- 外語:翻譯水平

- 拓展:冷門知識

讓我們一起看看它們表現如何~

編程能力

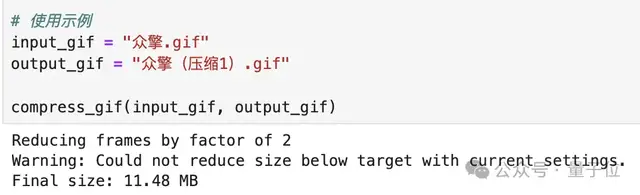

在更新前,我曾向DeepSeek V3問過這樣的問題:

幫我用python寫一段代碼,把輸入的gif圖壓縮到10M以下。

它的回答如下(圖片可上下滑動)。

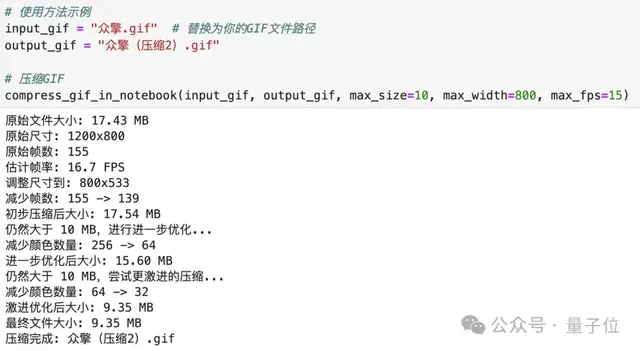

更新后,問V3.1同樣的問題,則得到了這樣的結果:

很直觀地就能感受到,相比起V3,V3.1要更加全面,考慮到了更多的可能性(比如使用更激進的壓縮策略,以及檢查原文件是否是GIF格式)。

還“手把手”地給出了這段代碼的使用說明,需要提前安裝必要的依賴庫,怎么使用命令行……甚至還有工作原理。

沒有優化建議,大概是因為它覺得已經足夠了吧(?)

拿之前在世界機器人大會上拍攝的眾擎機器人作為示例,原文件大小為18.3MB,用V3給出的代碼,壓縮后依然大于10MB,如果要滿足條件的話還需要再壓縮一次。

而V3.1給出的結果則直接“一步到位”(代碼針對Jupyter環境進行了一點小調整,邏輯不變),并輸出了處理步驟:

最后的兩張GIF圖如下(上為V3,下為V3.1):

可以看到上圖的速度比下圖要快一些。

情境寫作

我們選擇了今年上海卷高考作文的題目:

有學者用“專”“轉”“傳”概括當下三類文章:“專”指專業文章;“轉”指被轉發的通俗文章;“傳”指獲得廣泛傳播的佳作,甚至是傳世文章。他提出,專業文章可以變成被轉發的通俗文章,而面對大量“轉”文,讀者又不免期待可傳世的文章。由“專”到“傳”,必定要經過“轉”嗎?請聯系社會生活,寫一篇文章,談談你的認識與思考。要求:(1)自擬題目;(2)不少于800字。

輸出結果如下,可左右滑動對比,左邊為V3,右邊為V3.1:

兩個版本在文字風格上具有很大的不同,從V3理性(人機味)的平鋪直敘,到V3.1文藝(情緒化)的詩意表達,看起來像理科生和文科生的區別。

如果你是主考官,會更喜歡哪一篇呢?

理解應用

考驗模型的數學能力,光問“9.11和9.8哪個大”這種對于實際用戶沒什么幫助的題目還是有點不夠看。

高考數學題按理來講應該是能做對的吧?

以下是今年數學全國一卷的第3題,考的是雙曲線。

若雙曲線C的虛軸長為實軸長的√7倍,則C的離心率為?

答案是2√2,兩個版本的模型都得到了正確結果,但在呈現上有所不同。

翻譯水平

我們向V3和V3.1輸入了同一篇生物學論文的摘要(含專有名詞),并要求它們將其翻譯成中文。

摘要選自Nature最新研究:《獨特毛顎動物體型的基因組起源》。

兩個版本模型的輸出結果如下:

可以看出,相比起V3喜歡用括號來補充說明,V3.1對長難句的理解程度更高;但V3.1出現了沒有翻譯出several這種簡單詞的情況。

冷門知識

結合同事的專業和最近在小紅書上刷到的內容,我們問了一個比較“偏門”的問題:

構樹的單個果實(不是由花序組成的聚花果)是核果還是瘦果?

這個問題的答案在不同教材上存在分歧,V3和V3.1分別給出了以下回答,均認為其屬于核果:

神奇的是V3.1依然存在使用conclusion替代“結論”這樣的表述,以及對于“為什么會想到瘦果”這個問題的回答偏題到該果實屬于聚花果的方向了。

順便一提,小紅書的博主通過解剖實驗,認為其屬于瘦果。

對這個結論感興趣的朋友可以去小紅書上搜索一下。

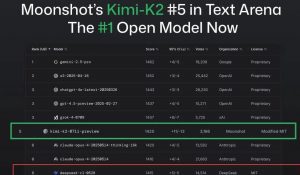

非推理模型SOTA

網友們對這次更新頗為關心,即使還未發布模型卡,就在抱抱臉上成為了第四的熱門話題。

截至發稿已榮登第二。

網友們也在使用后得到了一些有趣的發現。

Reddit就有人測試,DeepSeek V3.1在aider上得分71.6%,拿下了非推理模型的SOTA。

這是什么概念——有網友解釋到,這意味著它比Claude Opus 4得分多1%,但價格便宜68倍。

也有人在SVGBench基準上發現:V3.1的表現>V3.1(思考)>R1 0528。

這可能和V3.1的配置有關?

有網友察覺到它增加了四個特殊的token,并注意到現版本的V3.1在關閉搜索狀態下也會自動搜索。

此外,它的物理理解能力似乎有所提升,下面兩個GIF圖分別是V3.1和V3對于”在旋轉六邊形內彈跳的球“的呈現。

但也有人發現了一些問題,多與線上API相關……嗯,已經有人開罵了。

不過,最讓人好奇的是,V3.1發布了,R2呢?

參考鏈接:

[1]https://x.com/deepsseek/status/1957886077047566613

[2]https://huggingface.co/deepseek-ai/DeepSeek-V3.1-Base

[3]https://venturebeat.com/ai/deepseek-v3-1-just-dropped-and-it-might-be-the-most-powerful-open-ai-yet/

[4]https://old.reddit.com/r/LocalLLaMA/comments/1muq72y/deepseek_v31_scores_716_on_aider_nonreasoning_sota/

- AI芯片獨角獸一年估值翻番!放話“三年超英偉達”,最新融資53億2025-09-18

- 李飛飛發布世界模型新成果:一個提示,生成無限3D世界2025-09-17

- 奧特曼“續命”大計:押注讓大腦變年輕的藥物,預計年底臨床試驗2025-09-16

- DeepMind哈薩比斯最新認知都在這里了2025-09-15