MIT終身教授何愷明,入職谷歌了

被曝加入DeepMind基礎(chǔ)研究組

AI大牛何愷明最新動向來了!

才剛拿下MIT終身教職沒多久,這轉(zhuǎn)眼又加盟谷歌DeepMind任杰出科學(xué)家。

目前這一消息已在個人主頁同步更新:

也是在最近,MIT官網(wǎng)發(fā)布公告稱:

今年MIT工程學(xué)院一共有11位教職人員獲得終身教職,而何愷明也在名單中。

要知道他去年3月才正式在MIT開講,這中間幾乎只隔了一年左右時間。

回到這次加盟谷歌,從介紹里可以看到,確切來說他應(yīng)該算是兼職(part-time)。

雖然他本人沒有透露更多信息,但某書上已經(jīng)有自稱谷歌員工的網(wǎng)友提前劇透了一波:

他即將加入的是DeepMind基礎(chǔ)研究組,直屬領(lǐng)導(dǎo)的title是L8——離DeepMind老大哈薩比斯還隔著三個老板的距離。

那么問題來了,已經(jīng)擁有MIT終身教職的何愷明,為啥又選擇和谷歌聯(lián)手呢?

一扒才知道,原來二者早已多次展開研究合作——

何愷明其人

先簡單回顧一下何愷明的履歷。

眾所周知,何愷明算是CV領(lǐng)域(計算機視覺)的傳奇人物。

他本科就讀于清華大學(xué)物理系,博士師從湯曉鷗,畢業(yè)于香港中文大學(xué)。

2009年,湯曉鷗、何愷明以及孫劍憑借論文“Single Image Haze Removal Using Dark Channel Prior”,獲得該年度CVPR的最佳論文獎,這也是第一次頒發(fā)給亞洲研究學(xué)者。

2011年博士畢業(yè)后進入微軟亞洲研究院工作,任研究員,并在2016年加入Facebook AI Research(FAIR)繼續(xù)研究計算機視覺。

不過在這之前,他于2015年提出的ResNet(深度殘差網(wǎng)絡(luò)),不僅在ILSVRC 2015分類任務(wù)競賽斬獲第一名,還拿到了2016年CVPR最佳論文。

直到現(xiàn)在,ResNet仍然是其最高引研究,單篇引用量已超過28萬次。

而且這一概念如今已廣泛應(yīng)用于現(xiàn)代深度學(xué)習(xí)模型,包括Transformer、AlphaGo Zero、AlphaFold以及幾乎所有GenAI模型。

在FAIR期間,何愷明和團隊在計算機視覺領(lǐng)域取得不少亮眼的成績,包括Faster R-CNN及后續(xù)的Mask R-CNN等一系列研究。

其中,Mask R-CNN解決了圖片中的實例級對象分割問題,不僅能將照片中的人、動物等對象單一檢測,還可為其每個對象實例生成一個高質(zhì)量分隔遮罩,該研究也獲得了ICCV 2017最佳論文。

在FAIR干了相當長一段時間后,2023年他官宣加入MIT EECS(電子工程和計算機科學(xué)系) ,選擇正式回歸學(xué)術(shù)界。

這一轉(zhuǎn)向在當時引起了廣泛關(guān)注,甚至一眾網(wǎng)友吐槽Meta痛失一員大將。

后來的故事就接上咱們的開頭了~

總之,從學(xué)術(shù)界到產(chǎn)業(yè)界再到學(xué)術(shù)界,何愷明一路積累了豐碩研究成果。

目前其谷歌學(xué)術(shù)總引用量已經(jīng)超過71萬次,是當之無愧的學(xué)術(shù)大佬。

近來其研究主要集中在模型性能優(yōu)化上,包括提出通過正則化表示(Representation Regularization)來改進圖像生成技術(shù)、開發(fā)高度壓縮的Tokenizer來實現(xiàn)在未經(jīng)訓(xùn)練的情況下生成文本等等。

一言以蔽之,不管身份如何轉(zhuǎn)變,他始終在CV領(lǐng)域持續(xù)深耕。

和谷歌團隊多有合作

事實上,何愷明和谷歌其實多有合作。

就在今年2月,他還和谷歌DeepMind全華人班底(黎天鴻、Qinyi Sun、范麗杰)開辟了生成模型的全新范式——

合發(fā)論文《Fractal Generative Models(分形生成模型)》,首次使逐像素生成高分辨率圖像成為可能。

具體而言,團隊提出用參數(shù)化的神經(jīng)網(wǎng)絡(luò)作為分形生成器,從數(shù)據(jù)中學(xué)習(xí)這種遞歸法則,實現(xiàn)對高維非序列數(shù)據(jù)的建模,也可用于材料、蛋白質(zhì)等。

結(jié)果在「逐像素圖像生成」這一任務(wù)中表現(xiàn)出色。目前相關(guān)成果代碼已開源。

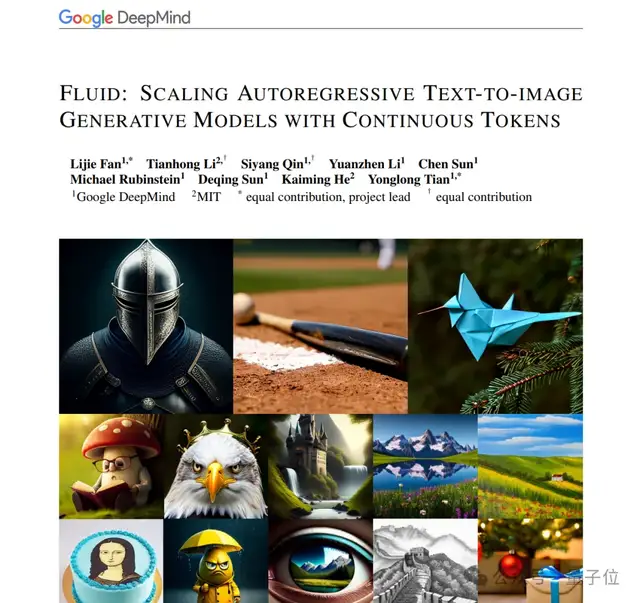

此外,去年其團隊還和谷歌DeepMind合作,提出了一個基于連續(xù)標記的隨機順序自回歸模型——Fluid。

他們所要解決的問題是:視覺自回歸模型的Scaling,往往不像在語言模型里那樣有效。

而通過合作,他們?yōu)樽曰貧w文生圖模型的擴展指出一個方向:

- 基于連續(xù)token的模型比離散token模型在視覺質(zhì)量上更好

- 隨機順序生成與光柵順序相比在GenEval測試上得分明顯更好

更多研究在此不再枚舉,總而言之,何愷明和谷歌DeepMind團隊實則早有接觸。

因此這一次他選擇和DeepMind合作,也可謂老熟人之間的強強聯(lián)手。

- 英偉達巧用8B模型秒掉GPT-5,開源了2025-12-06

- SpaceX估值8000億美元超OpenAI,IPO就在明年2025-12-06

- 騰訊發(fā)布EdgeOne Pages正式版:國內(nèi)首個邊緣全棧開發(fā)平臺,內(nèi)測階段用戶突破15萬2025-12-05

- 中國AI計算開放架構(gòu)創(chuàng)新風(fēng)向標:HAIC2025重磅啟幕2025-12-04