新研究揭示DeepSeek弱點(diǎn):頻繁切換思路欠思考,最短答案往往就對(duì)

國(guó)內(nèi)外兩支團(tuán)隊(duì)同時(shí)發(fā)現(xiàn)

夢(mèng)晨 西風(fēng) 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

DeepSeek和o1/o3一類(lèi)推理大模型持續(xù)帶來(lái)震撼之際,有人開(kāi)始研究他們的弱點(diǎn)了。

最新研究揭示:

在遇到高難度問(wèn)題時(shí),推理大模型可能像“三心二意的學(xué)生”一樣頻繁切換解題思路,卻因缺乏深入探索而失敗——這種現(xiàn)象被研究者稱(chēng)為Underthinking(欠思考)。

研究團(tuán)隊(duì)來(lái)自騰訊AI實(shí)驗(yàn)室、蘇州大學(xué)和上海交通大學(xué),主要研究對(duì)象是開(kāi)源的DeepSeek-R1和Qwen QwQ系列模型。

通過(guò)分析AI的錯(cuò)誤答案,他們發(fā)現(xiàn)當(dāng)前的推理大模型經(jīng)常在思考早期就走上了正確的路線,但傾向于“淺嘗輒止”,很快開(kāi)始探索別的思路,導(dǎo)致后續(xù)生成的數(shù)千個(gè)tokens對(duì)解題毫無(wú)貢獻(xiàn)。

這種“無(wú)效努力”不僅浪費(fèi)計(jì)算資源,還顯著降低了答案的正確率。

“三心二意”是罪魁禍?zhǔn)?/h1>

這一現(xiàn)象在解決數(shù)學(xué)競(jìng)賽題等更為復(fù)雜任務(wù)時(shí)尤為明顯。

為了系統(tǒng)分析,團(tuán)隊(duì)在三個(gè)具有挑戰(zhàn)性的測(cè)試集MATH500、GPQA Diamond和AIME2024上,對(duì)類(lèi)o1模型QwQ-32B-Preview、DeepSeek-R1-671B等進(jìn)行了實(shí)驗(yàn)。

下圖比較了正確和錯(cuò)誤回答中的token使用量和思維切換次數(shù)。平均來(lái)看,類(lèi)o1模型在錯(cuò)誤回答中比正確回答多消耗了225%的token,原因是思維切換頻率增加了418%。

為了深入分析這一現(xiàn)象,研究團(tuán)隊(duì)開(kāi)發(fā)了一套評(píng)估框架,用于判斷被放棄的推理路徑是否實(shí)際上足以推導(dǎo)出正確答案。

結(jié)果觀察到,許多模型在回答開(kāi)頭階段的思路是正確的,但并未繼續(xù)深入完成推理。

超過(guò)70%的錯(cuò)誤回答中至少包含一個(gè)正確的思路。此外,在超過(guò)50%的錯(cuò)誤回答中,有10%以上的思路是正確的。

如下圖所示的例子,例如,Thought 1通過(guò)識(shí)別給定方程類(lèi)似于以(0,0)和(20,11)為中心的橢圓方程,啟動(dòng)了正確的解釋。將兩個(gè)表達(dá)式設(shè)為相等,是尋找滿足這兩個(gè)方程的公共點(diǎn)(x, y)的有效方法。

然而,模型并未專(zhuān)注于深入探索這一合理思路,使用進(jìn)一步的代數(shù)操作和優(yōu)化技術(shù)進(jìn)行分析,而是頻繁切換思路,額外消耗了約7270個(gè)token,卻依然未能得出正確答案。

最終,它得出一個(gè)缺乏擴(kuò)展COT過(guò)程支持的猜測(cè)答案。

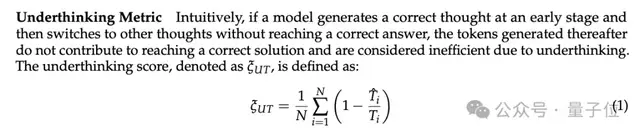

基于這些觀察,研究人員提出了一個(gè)用于量化Underthinking程度的指標(biāo)(Underthinking Metric)。

這個(gè)指標(biāo)通過(guò)測(cè)量錯(cuò)誤答案中的token使用效率來(lái)評(píng)估推理效率,計(jì)算從回答開(kāi)始到第一個(gè)正確思路出現(xiàn)所需的token數(shù)量與總token數(shù)量的比值。

實(shí)驗(yàn)結(jié)果表明,所有測(cè)試的類(lèi)o1模型都存在顯著的思維不足問(wèn)題。模型的準(zhǔn)確率與思維不足之間的關(guān)系在不同數(shù)據(jù)集上表現(xiàn)各異。

在MATH500-Hard和GPQA Diamond數(shù)據(jù)集上,性能更優(yōu)的DeepSeek-R1-671B模型在取得更高準(zhǔn)確率的同時(shí),其UT得分也更高,表明錯(cuò)誤回答中存在更多思維不足。

這意味著,盡管模型整體能力更強(qiáng),但在不確定時(shí)可能生成更長(zhǎng)但效率較低的推理過(guò)程,可能是因?yàn)槟P吞剿髁硕鄠€(gè)錯(cuò)誤的推理路徑,卻未能有效收斂到正確解答。

相反,在AIME2024測(cè)試集中,DeepSeek-R1-671B模型不僅取得了更高的準(zhǔn)確率,還表現(xiàn)出較低的UT得分,反映出較少的思維不足和更高的token效率。

這表明模型在該任務(wù)中,即使未得出正確答案,其推理過(guò)程依然保持專(zhuān)注和高效,團(tuán)隊(duì)表示這可能是因?yàn)槟P团c AIME2024所要求的問(wèn)題類(lèi)型和推理過(guò)程更好地對(duì)齊。

理解思維不足現(xiàn)象對(duì)于開(kāi)發(fā)能夠提供正確答案并具備有效推理過(guò)程的模型至關(guān)重要。

如何讓AI學(xué)會(huì)“一心一意”

如何讓模型像優(yōu)秀學(xué)生一樣“沉下心來(lái)鉆研”?

研究者借鑒了人類(lèi)考試策略,提出了一種“思路切換懲罰機(jī)制”?(Thought Switching Penalty,TIP)。

其原理類(lèi)似于考試時(shí)給自己定規(guī)矩:“先專(zhuān)注當(dāng)前方法,至少?lài)L試10分鐘再換思路”。

技術(shù)細(xì)節(jié)上,TIP會(huì)對(duì)觸發(fā)思路切換的關(guān)鍵詞施加懲罰,降低這些詞在解碼過(guò)程中的生成概率,迫使模型在當(dāng)前路徑上探索更久。

例如,當(dāng)模型開(kāi)始寫(xiě)“Alternatively, we can consider…”時(shí),TIP會(huì)通過(guò)調(diào)整參數(shù)(懲罰強(qiáng)度α和持續(xù)時(shí)間β),抑制這種過(guò)早的切換傾向。

實(shí)驗(yàn)結(jié)果顯示,加入TIP能讓模型在數(shù)學(xué)測(cè)試上的準(zhǔn)確率上升,同時(shí)UT Score下降,說(shuō)明既減少了無(wú)效切換,又提高了答案質(zhì)量。

例如在AIME2024數(shù)學(xué)競(jìng)賽測(cè)試上,加入TIP的QwQ-32B-Preview模型準(zhǔn)確率從41.7%提升至45.8%,同時(shí)UT Score從72.4降至68.2。

并且這種“無(wú)痛升級(jí)”無(wú)需重新訓(xùn)練模型,僅需調(diào)整解碼策略,展現(xiàn)了其實(shí)用價(jià)值。

One More Thing

UC Berkeley教授Alex Dimakis幾乎同時(shí)分享了類(lèi)似的觀察,

對(duì)于DeepSeek-R1和所有推理模型,錯(cuò)誤的答案更長(zhǎng),而正確的答案要短得多。

基于此,他們提出一個(gè)簡(jiǎn)單的解決辦法,稱(chēng)為“簡(jiǎn)潔解碼”?(Laconic decoding)。

并行運(yùn)行5次模型,從答案中選擇tokens最少的。

初步實(shí)驗(yàn)結(jié)果表示,簡(jiǎn)潔解碼在AIME2024測(cè)試上能提高6%-7%的準(zhǔn)確率,比Consensus Decoding更好也更快。

論文地址:https://arxiv.org/abs/2501.18585

參考鏈接:

[1]https://x.com/tuzhaopeng/status/1885179412163027406

[2]https://x.com/AlexGDimakis/status/1885447830120362099