機(jī)器人領(lǐng)域出了個(gè)「RoboGPT」:一個(gè)模型處理不同感官輸入,來(lái)自谷歌|開(kāi)源

還能收拾房間

Pine 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

懶得打掃房間,那就直接交給機(jī)器人來(lái)做吧。

想吃零食了,機(jī)器人也能幫你服務(wù),薯片和紙巾都給你貼心備好。

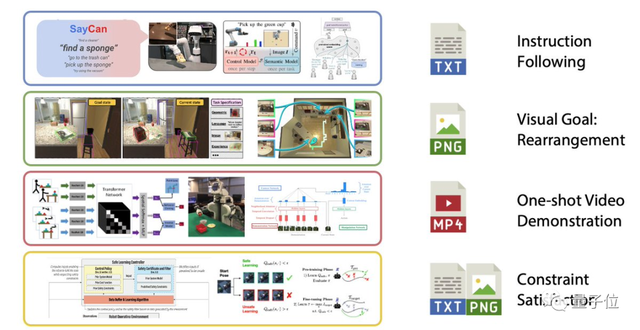

而且,這個(gè)機(jī)器人只需要一個(gè)單一的預(yù)訓(xùn)練模型,就能從不同的感官輸入?(如視覺(jué)、文本等)中生成命令,來(lái)執(zhí)行多種任務(wù)。

要知道,在以往機(jī)器人執(zhí)行命令時(shí),處理這些不同的任務(wù)時(shí), IO 規(guī)范、神經(jīng)網(wǎng)絡(luò)體系結(jié)構(gòu)和目標(biāo)等都是不一樣的。

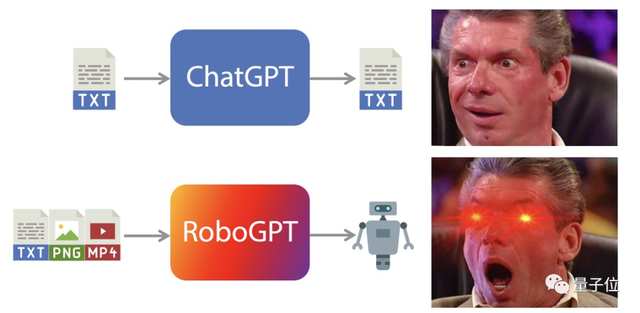

現(xiàn)在,這個(gè)問(wèn)題谷歌解決了,他們研究出了適用于機(jī)器人領(lǐng)域的Transformer模型:RT-1,甚至被人戲稱(chēng)為RoboGPT。

△圖源:推特@Jim Fan

更重要的是,RT-1代碼已開(kāi)源!

具體原理

先來(lái)整體看看RT-1,它執(zhí)行任務(wù)主要依靠的就是:7+3+1。

所謂7,是指它的手臂有7個(gè)自由度,分別是x,y,z,滾動(dòng),俯仰,偏航,手爪開(kāi)口。

3是指基礎(chǔ)運(yùn)動(dòng)的三個(gè)維度,即在地面運(yùn)動(dòng)時(shí)的x,y,偏航。

1則指RT-1的整體控制,即切換這三種模式:控制手臂,基礎(chǔ)運(yùn)動(dòng),或終止任務(wù)。

△圖源:Everyday Robots

而RT-1執(zhí)行任務(wù)時(shí),它的底層邏輯還是純粹的監(jiān)督式學(xué)習(xí),要做好監(jiān)督式學(xué)習(xí),就得具備兩個(gè)條件:

豐富的數(shù)據(jù)集?和強(qiáng)大的神經(jīng)結(jié)構(gòu)。

首先是數(shù)據(jù)集,RT-1是在一個(gè)大規(guī)模的、真實(shí)世界的機(jī)器人數(shù)據(jù)集上進(jìn)行訓(xùn)練的,可以用4個(gè)數(shù)字來(lái)概括:13萬(wàn)、700+、13、17,分別表示:

- 包括13萬(wàn)個(gè)片段;

- 涵蓋700多個(gè)任務(wù);

- 使用了13個(gè)機(jī)器人;

- 歷時(shí)17個(gè)月。

然后就是RT-1的結(jié)構(gòu)了,它執(zhí)行任務(wù)的過(guò)程如下圖所示。

具體來(lái)說(shuō),圖像和文本先通過(guò)ImageNet預(yù)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)(EfficientNet)進(jìn)行處理。

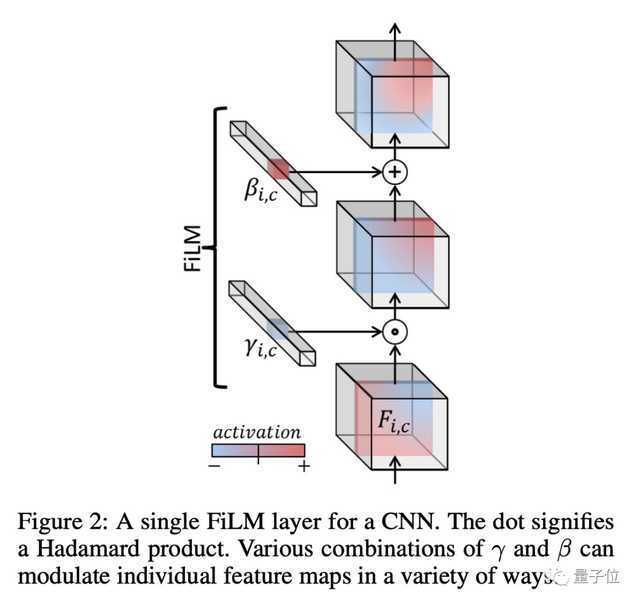

在這其中,為了確保文本和圖像同路能夠很好地被整合在一起,RT-1還使用了FiLM層,這是一種通過(guò)語(yǔ)言嵌入來(lái)調(diào)節(jié)視覺(jué)活動(dòng)的經(jīng)典技術(shù)。

這樣一來(lái),RT-1便能很好地提取與手頭任務(wù)相關(guān)的視覺(jué)特征。

然后這些視覺(jué)特征會(huì)被Token Learner模塊計(jì)算成一組緊湊的token傳遞給Transformer,這使得機(jī)器人的推理速度能夠提高2.4倍以上。

接下來(lái)Transformer會(huì)來(lái)處理這些token并產(chǎn)生離散化的操作token,而操作token便是一開(kāi)始說(shuō)的那個(gè)7+3+1了。

通過(guò)控制手臂,基礎(chǔ)運(yùn)動(dòng)以及模式便能夠執(zhí)行任務(wù)了。

在執(zhí)行任務(wù)的整個(gè)過(guò)程中,RT-1還會(huì)以3Hz的頻率執(zhí)行閉環(huán)控制和命令操作,直到產(chǎn)生終止操作或用完預(yù)先設(shè)置的時(shí)間步驟數(shù)。

不過(guò)話說(shuō)回來(lái),既然這個(gè)機(jī)器人能夠執(zhí)行多任務(wù),那它執(zhí)行通用任務(wù)時(shí)的能力到底如何呢?

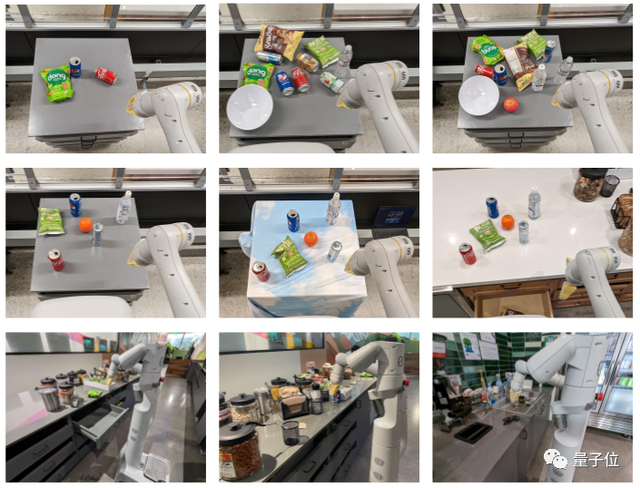

研究人員分別測(cè)試了RT-1對(duì)干擾物數(shù)量(第一行)、不同背景和環(huán)境(第二行)以及真實(shí)場(chǎng)景(第三行)的魯棒性。

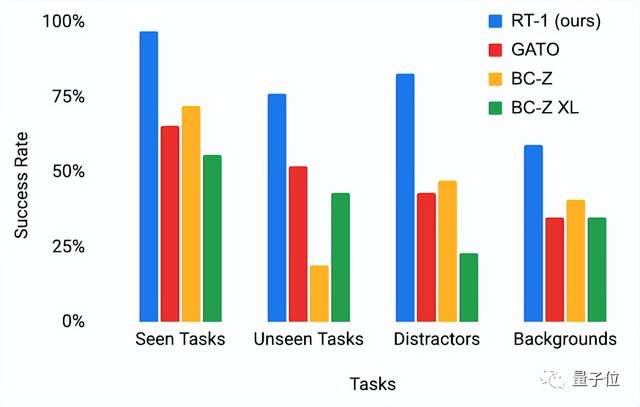

并與其他基于模仿學(xué)習(xí)的基線進(jìn)行比較,結(jié)果如下圖所示(第一項(xiàng)為訓(xùn)練期間的表現(xiàn))。

顯而易見(jiàn),在每個(gè)任務(wù)類(lèi)別中,RT-1都明顯優(yōu)于以前的模型。

研究團(tuán)隊(duì)

這個(gè)機(jī)器人來(lái)自谷歌,研究團(tuán)隊(duì)的成員也比較龐大,分別來(lái)自三個(gè)研究團(tuán)隊(duì):

首先是Robotics at Google,它是Google Research下的一個(gè)細(xì)分領(lǐng)域團(tuán)隊(duì),目前正在探索“如何教機(jī)器人可轉(zhuǎn)移的技能”。

并且他們也在不斷公開(kāi)其訓(xùn)練的數(shù)據(jù),以幫助推進(jìn)這一領(lǐng)域的最先進(jìn)水平。

然后是Everyday Robots?,它是X-登月工廠的一個(gè)細(xì)分領(lǐng)域團(tuán)隊(duì),和谷歌團(tuán)隊(duì)一起工作,目前他們正在制造一種新型機(jī)器人,一個(gè)可以自學(xué)的,可以幫助任何人做任何事情的通用機(jī)器人。

還有就是Google Research,它是Google公司內(nèi)部進(jìn)行各種最先進(jìn)技術(shù)研究的部門(mén),他們也有自己的開(kāi)源項(xiàng)目,在GitHub公開(kāi)。

項(xiàng)目地址:

https://github.com/google-research/robotics_transformer

論文地址:

https://arxiv.org/abs/2212.06817

參考鏈接:

https://robotics-transformer.github.io/

- GPT-5不能停!吳恩達(dá)田淵棟反對(duì)千人聯(lián)名,OpenAI CEO也發(fā)聲了2023-03-30

- ChatGPT標(biāo)注數(shù)據(jù)比人類(lèi)便宜20倍,80%任務(wù)上占優(yōu)勢(shì) | 蘇黎世大學(xué)2023-03-29

- 馬斯克嘲諷比爾蓋茨不懂AI/ 蘋(píng)果收購(gòu)AI視頻公司/ 壁仞GPU聯(lián)創(chuàng)出走…今日更多新鮮事在此2023-03-28

- GPT-4老板:AI可能會(huì)殺死人類(lèi),已經(jīng)出現(xiàn)我們無(wú)法解釋的推理能力2023-03-28