跳過“逐字生成”!螞蟻集團趙俊博:擴散模型讓我們能直接修改Token | MEET2026

dLLM的訓練推理仍處于早期發展階段

當主流大語言模型還在采用自回歸架構時,有人已經盯上了擴散架構。

在本次量子位MEET2026智能未來大會上,浙江大學百人計劃研究員、博士生導師,螞蟻集團資深技術專家趙俊博表示:

擴散架構在推理過程中可以直接修改和控制token,而不需要像自回歸模型那樣重新生成整段內容。

這意味著,相比自回歸模型,擴散模型理論上有望實現更快的生成速度以及更低的計算成本。

基于此,他和團隊將重點押注于擴散架構,并致力于探索擴散語言模型獨有的Scaling Law。

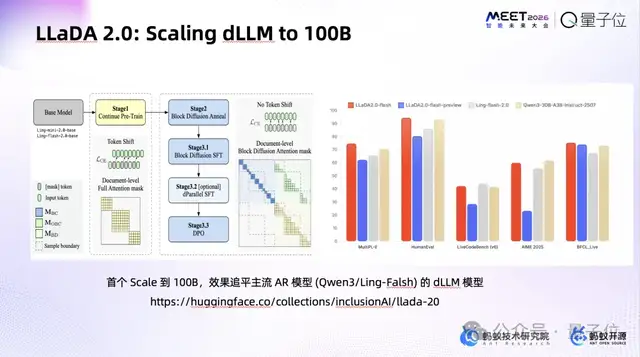

而作為這一探索的關鍵里程碑,他們近期發布并開源了LLaDA 2.0,率先將擴散語言模型做到千億體量。

趙俊博坦言,該領域在訓練與推理層面仍處早期,但發展勢頭迅猛,已吸引包括谷歌、字節在內的巨頭及一批初創公司積極布局。

編者注:就在MEET2026智能未來大會結束后,趙俊博和團隊也發布了全新的技術報告,揭示了千億體量擴散語言模型背后的關鍵技術選擇。

報告標題:LLaDA2.0: Scaling Up Diffusion Language Models to 100B

報告鏈接(github):https://github.com/inclusionAI/LLaDA2.0/blob/main/tech_report.pdf

為了完整體現趙俊博的思考,在不改變原意的基礎上,量子位對演講內容進行了編輯整理,希望能給你帶來更多啟發。

MEET2026智能未來大會是由量子位主辦的行業峰會,近30位產業代表與會討論。線下到場參會觀眾近1500人,線上直播觀眾350萬+,獲得了主流媒體的廣泛關注與報道。

核心觀點梳理

- 所有生成模型本質上都是在擬合數據分布。自回歸模型提供了一種擬合方式,它將整體分布拆解為一系列遵循單向因果順序的條件概率來逐步建模。但這種方式并不是唯一的路徑。

- 開源模型LLaDA采用擴散語言模型架構,暫不考慮MoE的情況下,在相同的計算量和性能目標下,LLaDA所需的參數規模可以比自回歸模型更小。

- 擴散架構在推理過程中可以直接修改和控制token,而不需要像自回歸模型那樣重新生成整段內容。

- 在計算受限情況下,LLaDA采用“完形填空”式預測,相比自回歸模型更為“data-hungry”,對數據需求更大、吸收數據更快。

- LLaDA與自回歸模型的Scaling Law存在差異,已驗證LLaDA可以擴展到千億規模,但繼續往上會面臨新的挑戰。

- ……

以下為趙俊博演講全文:

押注擴散語言模型的Scaling Law

大家好,今天我稍微講點不一樣的,來一場技術上的脫口秀。

剛才幾位嘉賓已反復提及,目前主流的大語言模型幾乎都基于自回歸架構構建。但我接下來介紹的,我們最近開源的全新系列模型——架構完全不同。

要想了解不同之處何在,先讓我們來厘清幾個基本概念。

相信大家都很熟悉Midjourney、Sora、Emu Video等圖像/視頻賽道的熱門模型,實際上,它們里面都有一個非常明確的機制叫擴散。

何謂擴散?簡單來說就是加噪后再去噪,從噪聲中恢復圖像。

所有的Auto-Regressive Model(AR,自回歸模型)基本都遵循同一機制——給定前N個詞,要求模型預測并生成第N+1個詞,然后基于前N+1個詞,再去預測第N+2個詞,依此類推。

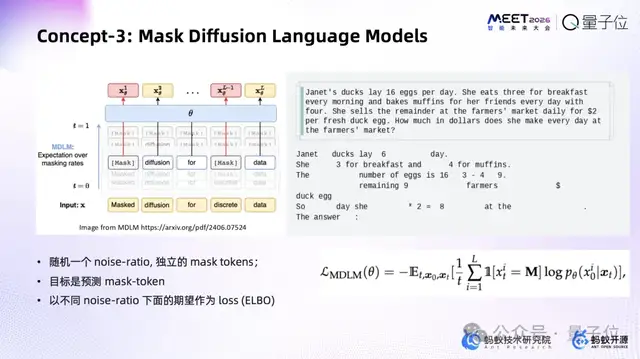

而擴散語言模型另辟蹊徑,可能有些觀眾也知道這個東西叫Masked Diffusion Language Models,我們看一下它的解碼過程,簡單來說它的機制不是“做接龍”,而是“做完形填空”。

如圖所示,給定一句話之后我們會Mask(遮蓋)掉一部分詞,再讓它恢復,這就非常像我們小時候做的完形填空。

而我們現在要做的,就是Diffusion Language Model(dLLM,擴散語言模型)的Scaling Law。

為什么做這件事?其實這是我們的一個賭注。

本質上來說,所有的大模型只要是生成模型,都是對P(X),也就是對本身數據分布的擬合。

自回歸模型提供了一種擬合方式,它將整體分布拆解為一系列遵循單向因果順序的條件概率來逐步建模。但這種方式并不是唯一的路徑。

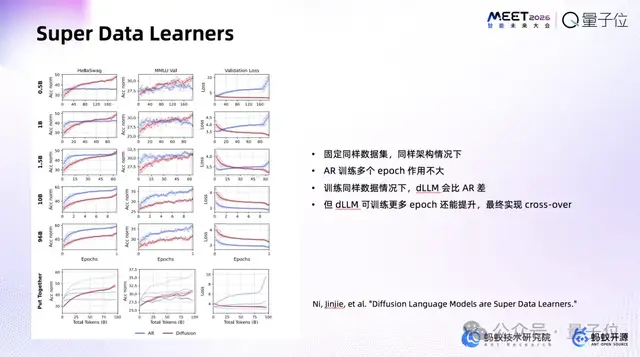

下圖由新加坡國立大學SEA AI研究員Jinjie Ni提供,里面點明了幾個非常重要的觀點。

第一,在計算受限的情況下,基于“完形填空”這一方式進行預測的擴散語言模型,比一般的自回歸模型需要的數據量更大,即所謂的“data-hungry”,在數據上能吃得更快。

第二,同樣是dense結構(先不管MoE),在參數和計算量相同的情況下,其實dLLM可以做得比AR更小。

所謂的“Super Data Learners”,如果了解圖像或視頻的擴散模型就會知道,它們有個特點——你可以一直訓練。

比如我們現在所有的自回歸模型,基本上訓練到多個epoch,效果就不再變動,數據也就這樣了。

而在同樣數據集、同樣架構下,紅色那條代表Diffusion的曲線可以一直訓——跟圖像領域觀測到的現象一致,確實可以一直做訓練。

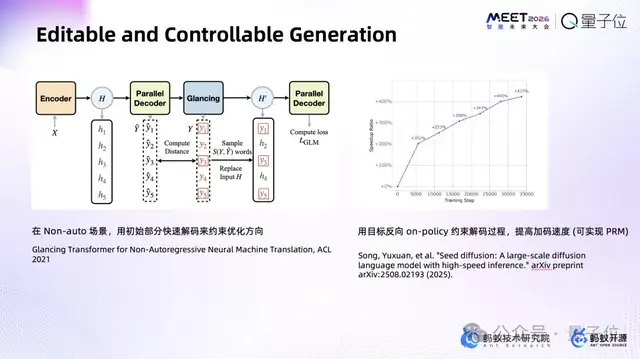

第三是Diffusion獨有的優勢。都知道CoT(思維鏈)和RL(強化學習),或者說見識過DeepSeek上的深度思考過程。這個東西我之前做了個比喻,AR像一個不能帶草稿紙的考生:

進了考場之后不允許寫提綱,跟下棋一樣落子無悔,在解所有題的時候落筆無悔。寫下一個token就釘死,再寫下一個,沒有給你任何機會回頭修改。中間寫錯了有一個CoT的機制,就好像“突然有一個token說這個地方好像中間有一步算錯了,我再重新開始”。

實際上這就解釋了為什么會有test-time scaling——AR在推理側的token efficiency其實并不高,有一些簡單的問題也要推理很久,生成很多token。

如圖所示,我們正在進行的研究叫Editable and Controllable Generation(等待跑通中),是指在Diffusion框架下,隨時“做完形填空”、隨時改;不像DeepSeek-R1或OpenAI-o1必須整段token推倒重來,我們可以直接在推理過程里改token。

這個東西有大量的工程細節,時間關系我只能簡單放一些。

發布并開源千億規模dLLM

首先是注意力掩碼(Attention Mask)的適配問題。

我們的模型中既包含細粒度的Block,也包含由Block組成的更大區塊——區塊之間采用自回歸的注意力機制(確保序列的總體連貫性),區塊內部并行解碼(以提升計算效率)。

因此,模型中同時存在兩種注意力模式。有些地方用全局Attention(以捕捉長程依賴),有些地方用Causal Attention(以維持自回歸約束)。

這里頭還包括對隨機長度序列的處理、集成港大孔令鵬老師提出的幾何加權方法,以及實現文本與文檔的長序列切分注意力等關鍵技術。

我們開源了一套訓練框架和推理框架,讓社區能把我們在Hugging Face上發布的模型直接跑起來。其中涉及5D并行集成、分區塊Diffusion下的Flex-Attention與Attention Mask適配,細節不再展開。

這是我們開源的第一個面向擴散語言模型的訓練框架,已支持SFT(監督微調)與DPO(直接偏好優化)。

這里我想把整個脈絡稍微介紹一下:

中國人民大學文繼榮和李崇軒老師團隊,率先開源了擴散語言模型LLaDA的第一個版本LLaDA 1.0。

LLaDA 1.0的研究過程非常痛苦,當時訓練和推理框架都很原始,踩坑無數,不過其8B版本在Hugging Face上零推廣就拿到二十幾萬下載。

這是第一個大規模訓練到80億參數的擴散語言模型,效果可對標LLaMA-3-8B。

后來螞蟻技術研究院聯合人大、浙大、西湖大學把整條線接過來,下重注要把這個領域的一些“非共識”變成“共識”。

第一件事就是解決架構問題。LLaDA是一個dense模型,而dense的痛點大家都提過,比如第一個就是怎么在Diffusion的框架里集成MoE。

今年9月,我們發布了LLaDA-MoE,總參數7B(激活參數1B),是全球第一個原生訓練出來的MoE架構擴散語言模型。

最近一段時間,相關研究幾乎已經在全球鋪開——谷歌有Gemini Diffusion、有家美國創業公司在做Mercury系列,包括字節也在做。

其最大特點就是一個字:快。

因為它就是“做完形填空”。比如做一個解碼,我先把最后一個token解出來,然后再去填中間,這些東西確實是實際解碼過程中能看到的。

上上周,我們發布了LLaDA 2.0,率先把擴散語言模型做到千億體量。踩坑史太長,技術報告已上線,這里就不再展開。

這里有幾個視頻。

第一個視頻表明,在全局注意力機制的支持下,擴散模型在效果上相比自回歸模型具備一定優勢。

轉到Coding,現在比較神奇的一點是——擴散語言模型在“調用”和“寫代碼”這兩個任務上比自回歸模型有明顯優勢。

得益于并行解碼,一次能同時吐出幾個token,現場看起來就像你在Cursor里按Tab自動補全。這些行為全是模型自己學出來的,我們也沒完全搞懂為啥。

以及再看文學創作,這個東西比較有意思。看一下這個解碼過程,先把開頭和結尾的框架定下來,中間部分先寫個大概,然后再根據上下文反復修改、潤色中間的內容。

這種“非共識”的解碼軌跡,在Gemini、OpenAI等任何原生App里都看不到。

接下來的一兩個月,我們會聯合ZenMux(一站式模型接入平臺)放出部分API,體量雖還比不過主流大模型,但社區已在慢慢長大。

dLLM的訓練推理仍處于早期發展階段

最后用一點時間聊下推理。

10月份左右,我們發布了一個帶有試驗性質的推理引擎dInfer。

通過新的模型架構與范式,若能將關鍵場景的TPS推上千量級,實現五倍乃至更高的速度提升,其體驗將是革命性的。

回頭看,Data/Parameter Scaling Law已不新鮮,去年9月OpenAI又帶出testing-time Scaling Law。

接下來會不會出現Diffusion Scaling Law?

今天沒人能給出答案。唯一確定的是,dLLM與AR的Scaling Law有很大區別,繼續擴展下去也會面臨新的挑戰。

但不管怎樣,我們會在這條路上繼續走下去。在我看來,AR發展了三年(從ChatGPT出來之后發展了三年),dLLM的訓推生態才剛起步,希望社區一起下場共建,謝謝。

- 10億美元OpenAI股權兌換迪士尼版權!米老鼠救Sora來了2025-12-12

- 梁文鋒,Nature全球年度十大科學人物!2025-12-09

- 英偉達巧用8B模型秒掉GPT-5,開源了2025-12-06

- SpaceX估值8000億美元超OpenAI,IPO就在明年2025-12-06