僅1/70的數(shù)據(jù)量,多模態(tài)檢索效果卻更優(yōu)! 智源發(fā)布BGE-VL,合成數(shù)據(jù)立大功

算法能夠以極低成本持續(xù)生成多樣化且高質(zhì)量的多模態(tài)三元組

允中 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

BGE系列模型自發(fā)布以來廣受社區(qū)好評。近日,智源研究院聯(lián)合多所高校開發(fā)了多模態(tài)向量模型BGE-VL,進一步擴充了原有生態(tài)體系。

BGE-VL在圖文檢索、組合圖像檢索等主要多模態(tài)檢索任務(wù)中均取得了最佳效果。BGE-VL借助大規(guī)模合成數(shù)據(jù)MegaPairs訓(xùn)練而成。

這一設(shè)計具備以下兩大核心優(yōu)勢:

- 優(yōu)異的可擴展性:MegaPairs 結(jié)合多模態(tài)表征模型、多模態(tài)大模型和大語言模型,在海量圖文語料庫中高效挖掘多模態(tài)三元組數(shù)據(jù)。其算法能夠以極低成本持續(xù)生成多樣化且高質(zhì)量的多模態(tài)三元組。本次發(fā)布的版本涵蓋 2600 萬條樣本,為多模態(tài)檢索模型的訓(xùn)練提供了大規(guī)模、高價值的數(shù)據(jù)支持。

- 卓越的數(shù)據(jù)質(zhì)量:相較于傳統(tǒng)多模態(tài)數(shù)據(jù),MegaPairs?僅需 1/70 的數(shù)據(jù)量即可實現(xiàn)更優(yōu)的訓(xùn)練效果。利用該合成數(shù)據(jù),智源訓(xùn)練了多模態(tài)檢索模型 BGE-VL,顯著提升了多個主流多模態(tài)檢索基準(zhǔn)的性能。

BGE-VL的技術(shù)報告已發(fā)布,相關(guān)數(shù)據(jù)、模型及代碼資源將陸續(xù)向社區(qū)全面開放。

MegaPairs構(gòu)造

在大模型時代,信息檢索需要滿足人們?nèi)找娑鄻踊男枨螅@種需求不僅體現(xiàn)在用戶的多模態(tài)查詢輸入上,也體現(xiàn)在對多模態(tài)信息的需求上。例如,用戶可能拍攝一張汽車外觀圖,并希望獲取該款汽車的指定信息。在這種情況下,多模態(tài)檢索器需要綜合理解用戶的圖像和文本指令,并從多種模態(tài)的信息中檢索出最相關(guān)的內(nèi)容。

然而,現(xiàn)有的多模態(tài)檢索模型通常基于單一形式的跨模態(tài)配對數(shù)據(jù)(如圖像-文本對)進行訓(xùn)練,這使得它們難以處理復(fù)雜的組合模態(tài)輸入。近年來,指令微調(diào)技術(shù)在文本檢索和大語言模型等領(lǐng)域已經(jīng)證明了其增強多任務(wù)能力的有效性。然而,以往的多模態(tài)檢索指令數(shù)據(jù)集大多依賴人工標(biāo)注,限制了大規(guī)模多樣化數(shù)據(jù)的獲取。

為解決這一限制,智源BGE團隊創(chuàng)新性地提出了MegaPairs數(shù)據(jù)合成方法。該方法通過從現(xiàn)有大規(guī)模圖像數(shù)據(jù)集中挖掘多樣的關(guān)聯(lián)圖像對,并利用開源多模態(tài)大模型和大語言模型進行自動化指令生成,從而構(gòu)建出高質(zhì)量、可擴展、泛化性強的多模態(tài)檢索指令微調(diào)數(shù)據(jù)集。團隊基于MegaPairs的高質(zhì)量數(shù)據(jù),訓(xùn)練并開源多模態(tài)向量模型BGE-VL系列,實現(xiàn)了當(dāng)前最佳的多模態(tài)檢索能力。

MegaPairs提出從現(xiàn)有大規(guī)模圖文語料庫中挖掘并構(gòu)造大規(guī)模、高質(zhì)量多模態(tài)檢索指令數(shù)據(jù)集。

具體地,MegaPairs的構(gòu)造主要分為兩個關(guān)鍵步驟:

(1)使用多種相似度模型從圖像數(shù)據(jù)集中挖掘多樣的圖像對;

(2)使用開源的多模態(tài)大模型和大語言模型合成開放域檢索指令。

以下圖為例,MegaPairs首先從大規(guī)模圖像數(shù)據(jù)集中采樣一對圖像-文本數(shù)據(jù)作為查詢數(shù)據(jù)。然后,利用多種圖像和文本相似度模型,挖掘出多組關(guān)聯(lián)圖像對(例如:同款汽車的外飾與內(nèi)飾、同款汽車不同涂裝、同品牌汽車未來概念圖等)。接著,針對這些挖掘出的圖像對,MegaPairs采用兩階段標(biāo)注方法:首先使用多模態(tài)大語言模型(MLLM)總結(jié)兩張圖片之間的關(guān)聯(lián)關(guān)系,然后使用大語言模型(LLM)撰寫最終的開放域檢索指令。

值得注意的是,MegaPairs完全基于開源數(shù)據(jù)集和開源模型進行自動化構(gòu)建和標(biāo)注。通過引入多個相似度模型和兩階段標(biāo)注方法,MegaPairs能夠在無需人工參與的情況下,擴展性地生成大規(guī)模、高質(zhì)量且多樣化的多模態(tài)檢索指令數(shù)據(jù)集。

△MegaPairs多模態(tài)三元數(shù)據(jù)構(gòu)造流程

基于上述流水線,MegaPairs合成了超過2600萬條(查詢圖像, 查詢語句, 目標(biāo)圖像)三元數(shù)據(jù)對。此外,鑒于“難負(fù)例”在訓(xùn)練檢索模型的重要性,MegaPairs對于每組挖掘的圖像對數(shù)據(jù)都選取了其他相似圖片作為難負(fù)例。

BGE-VL模型

基于MegaPairs合成的大規(guī)模多模態(tài)檢索指令數(shù)據(jù)集,智源BGE團隊訓(xùn)練出了3款不同尺寸的多模態(tài)檢索模型。包括基于CLIP架構(gòu)的BGE-VL-Base和BGE-VL-Large,以及基于多模態(tài)大模型架構(gòu)的BGE-VL-MLLM。團隊發(fā)現(xiàn),僅僅使用MegaPairs三元組數(shù)據(jù)訓(xùn)練,模型就在多個任務(wù)上實現(xiàn)了遠(yuǎn)超以往方法的的領(lǐng)先性能優(yōu)勢。

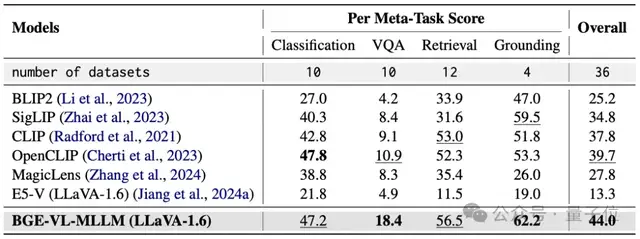

綜合多模態(tài)嵌入任務(wù)性能表現(xiàn)

團隊首先在Massive Multimodal Embedding Benchmark(MMEB)上驗證了BGE-VL模型的性能。MMEB是一個綜合性基準(zhǔn)測試,涵蓋了4大類共計36個不同多模態(tài)嵌入評測任務(wù):分類(Classification)、視覺問答(Visual Question Answering)、檢索(Retrieval)和視覺定位(Visual Grounding)。

△MMEB評測任務(wù)示例圖

在零樣本性能表現(xiàn)方面,BGE-VL在MMEB的多個任務(wù)類型和整體評分均實現(xiàn)了最優(yōu)性能。更令人興奮的是,MegaPairs并未包含MMEB中的絕大部分任務(wù)類型數(shù)據(jù)(例如Classification、VQA,Grounding),卻能夠?qū)崿F(xiàn)良好的任務(wù)泛化能力。

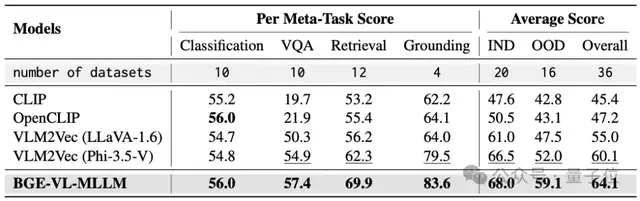

根據(jù)MMEB的設(shè)置,團隊進一步在MMEB的分布內(nèi)(IND)集合(包含36個評測任務(wù)中的20個任務(wù))上對BGE-VL進行了有監(jiān)督微調(diào)。實驗結(jié)果顯示,BGE-VL的平均性能指標(biāo)相比直接在MMEB上微調(diào)的VLM2Vec (LLaVA-1.6) 模型高出9.1個百分點。同時,在分布外(OOD)數(shù)據(jù)集上的平均表現(xiàn)也比兩版VLM2Vec分別高出11.6%和7.1%。這些結(jié)果證明了MegaPairs數(shù)據(jù)的高質(zhì)量和泛化能力。

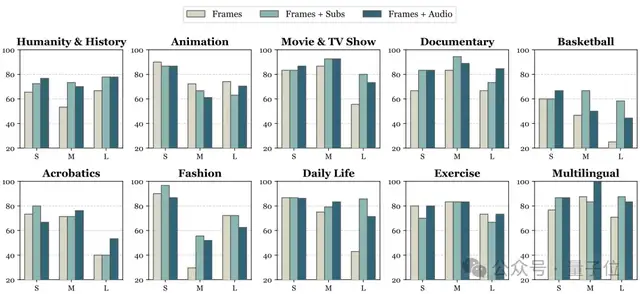

組合圖像檢索性能

傳統(tǒng)圖像檢索通常采用“文搜圖”或“圖搜圖”的方式。近年來,組合圖像檢索作為一種新興的圖像搜索范式,允許用戶同時輸入圖像和搜索指令,實現(xiàn)更精準(zhǔn)的圖像檢索效果。這一方法被谷歌稱為“下一代圖像搜索范式”。

在當(dāng)前主流的組合圖像檢索評測集CIRCO上,BGE-VL在不同模型尺寸上均顯著刷新了現(xiàn)有基準(zhǔn)。大幅超越包括谷歌的MagicLens系列和英偉達的MM-Embed等對比基線。具體而言,BGE-VL-MLLM較之前的SOTA模型提升了8.1個百分點。此外,BGE-VL-Base模型以不到1/50的參數(shù)量超越了如MM-Embed和E5-V等大模型底座的多模態(tài)檢索器。這些實驗結(jié)果有力展示了MegaPairs數(shù)據(jù)的有效性。

團隊還對MegaPairs的可擴展性和數(shù)據(jù)質(zhì)量進行了深入研究。如圖所示,一方面,隨著MegaPairs數(shù)據(jù)規(guī)模的增加,BGE-VL模型表現(xiàn)出一致的性能增長趨勢,證明了MegaPairs數(shù)據(jù)構(gòu)造方法的良好可擴展性。

另一方面,與在37M閉源數(shù)據(jù)上訓(xùn)練的SOTA模型Google MagicLens相比,MegaPairs僅需1/70的數(shù)據(jù)規(guī)模(0.5M)即可實現(xiàn)顯著的性能優(yōu)勢,證明了MegaPairs數(shù)據(jù)的高效性和高質(zhì)量。

△MegaPairs可擴展性分析:使用不同規(guī)模的MegaPairs數(shù)據(jù)訓(xùn)練BGE-VL-base模型在各評測基準(zhǔn)上的性能變化趨勢。虛線表示基于CLIP-base并在37M MagicLens數(shù)據(jù)集上訓(xùn)練的MagicLens-B模型的性能。

BGE-VL檢索可視化結(jié)果

未來,智源將繼續(xù)探索MegaPairs與更豐富的多模態(tài)檢索場景結(jié)合,進一步打造更全能通用的多模態(tài)檢索器。

更多方法和實驗細(xì)節(jié)請參照論文。

論文地址:https://arxiv.org/abs/2412.14475

項目主頁:?https://github.com/VectorSpaceLab/MegaPairs

模型地址:?https://huggingface.co/BAAI/BGE-VL-MLLM-S1

- 空間智能卡脖子難題被杭州攻克!難倒GPT-5后,六小龍企業(yè)出手了2025-08-28

- 陳丹琦有了個公司郵箱,北大翁荔同款2025-08-28

- 英偉達最新芯片B30A曝光2025-08-20

- AI應(yīng)用如何落地政企?首先不要卷通用大模型2025-08-12