何愷明上榜CVPR 2021獲獎(jiǎng)名單,4篇「最佳」是華人一作

最佳學(xué)生論文作者GPA滿分

曉查 發(fā)自 凹非寺?

量子位 報(bào)道 | 公眾號(hào) QbitAI

CVPR 2021本周正式召開啦,作為計(jì)算機(jī)視覺領(lǐng)域最重要的學(xué)術(shù)會(huì)議,大會(huì)的最佳論文自然是領(lǐng)域?qū)W者們關(guān)注的重要風(fēng)向標(biāo)。

就在上周,CVPR官方公布了入圍的32篇最佳論文候選名單,其中華人一作占據(jù)了16篇,國(guó)內(nèi)北大、騰訊、商湯等學(xué)校機(jī)構(gòu)上榜。

那么最終哪些論文摘得榮譽(yù)呢?今天凌晨,也就是大會(huì)首日,官方公布了結(jié)果:

其中最佳論文獎(jiǎng)和最佳學(xué)生論文獎(jiǎng)1篇,最佳學(xué)生論文提名3篇,最佳論文提名2篇。

在這7篇文章里,有4篇是華人一作,我們還看到了熟悉的大神何愷明的名字。

7篇獲獎(jiǎng)?wù)撐?/h2>

最佳論文獎(jiǎng)

GIRAFFE: Representing Scenes as Compositional Generative Neural Feature Fields

這篇論文來(lái)自德國(guó)蒂賓根大學(xué)的兩位學(xué)者。

摘要:

這篇文章提出,將復(fù)合三維場(chǎng)景表示納入生成模型,會(huì)導(dǎo)致更可控的圖像合成。將場(chǎng)景表示為復(fù)合生成神經(jīng)特征場(chǎng),能使我們能夠從背景中解開一個(gè)或多個(gè)對(duì)象以及單個(gè)對(duì)象的形狀和外觀,同時(shí)從非結(jié)構(gòu)化和非定位的圖像集合中學(xué)習(xí),而無(wú)需任何額外的監(jiān)督。

本文將這種場(chǎng)景表示與神經(jīng)渲染pipeline相結(jié)合,可以生成快速逼真的圖像合成模型。實(shí)驗(yàn)所證明的,該模型能夠解開單個(gè)物體,并允許在場(chǎng)景中平移和旋轉(zhuǎn)它們,并改變相機(jī)視角。

論文地址:

https://arxiv.org/abs/2011.12100

源代碼:

https://github.com/autonomousvision/giraffe

最佳論文提名

今年何愷明獲得了最佳論文提名,這篇論文就是:

Exploring Simple Siamese Representation Learning

摘要:

在本文中,作者發(fā)現(xiàn),Simple Siamese網(wǎng)絡(luò)即使不使用以下任何一種方式,也可以學(xué)習(xí)有意義的表示:(i)負(fù)樣本對(duì),(ii)大batch,(iii)動(dòng)量編碼器。

實(shí)驗(yàn)表明,坍塌解決方案確實(shí)存在于損失和結(jié)構(gòu)上,但停止梯度操作在防止崩塌方面發(fā)揮著至關(guān)重要的作用。作者給出了停止梯度含義的假設(shè),并進(jìn)一步展示了驗(yàn)證它的概念驗(yàn)證實(shí)驗(yàn)。

“SimSiam”方法在ImageNet和下游任務(wù)上取得了有競(jìng)爭(zhēng)力的結(jié)果。作者希望這個(gè)簡(jiǎn)單的baseline將激勵(lì)人們重新思考SimSiam架構(gòu)在無(wú)監(jiān)督表示學(xué)習(xí)中的作用。

另外,何愷明表示,不久后將提供論文代碼。

本文的第一作者是Xinlei Chen,本科畢業(yè)于浙江大學(xué),之后在卡內(nèi)基梅隆大學(xué)獲得博士學(xué)位,現(xiàn)在與何愷明一樣同在Facebook AI研究院工作。

論文地址:

https://arxiv.org/abs/2011.10566

源代碼:

https://github.com/facebookresearch/simsiam

另一篇獲得提名的是來(lái)自明尼蘇達(dá)大學(xué)的兩位學(xué)者。

Learning High Fidelity Depths of Dressed Humans by Watching Social Media Dance Videos

摘要:

學(xué)習(xí)穿戴人體幾何的一個(gè)關(guān)鍵挑戰(zhàn)在于,ground truth數(shù)據(jù)的可用性有限,這導(dǎo)致3D人體重建在應(yīng)用于現(xiàn)實(shí)世界圖像時(shí)的性能下降。

本文通過(guò)利用新的數(shù)據(jù)資源來(lái)應(yīng)對(duì)這一挑戰(zhàn):一些社交媒體舞蹈視頻,這些視頻跨越了不同的外觀、服裝風(fēng)格、表演和身份。每段視頻都描繪了一個(gè)人身體和衣服的動(dòng)態(tài)運(yùn)動(dòng),同時(shí)缺乏3D ground truth幾何。

為了利用這些視頻,作者提出了一種使用局部變換的新方法,將人預(yù)測(cè)的局部幾何形狀從圖像扭曲到另一個(gè)圖像的局部幾何。這種方法是端到端可訓(xùn)練的,從而產(chǎn)生高保真深度估計(jì),預(yù)測(cè)忠實(shí)于輸入真實(shí)圖像的精細(xì)幾何形狀。實(shí)驗(yàn)證明,該方法在真實(shí)和渲染圖像上都優(yōu)于最先進(jìn)的人類深度估計(jì)和人類形狀恢復(fù)方法。

論文地址:

https://arxiv.org/abs/2103.03319

最佳學(xué)生論文獎(jiǎng)

Task Programming: Learning Data Efficient Behavior Representations

作者來(lái)自加州理工和西北大學(xué)。

摘要:

要進(jìn)行專業(yè)領(lǐng)域知識(shí)的深入分析,通常是準(zhǔn)確注釋訓(xùn)練集是必需的,但從領(lǐng)域?qū)<夷抢铽@得這些既繁瑣又耗時(shí)。這個(gè)問題在自動(dòng)行為分析中非常突出。

為了減少注釋工作量,本文提出了TREBA:一種基于多任務(wù)自監(jiān)督學(xué)習(xí)的注釋-行為分析樣本高效軌跡嵌入方法。該方法中的任務(wù)可以由領(lǐng)域?qū)<彝ㄟ^(guò)“任務(wù)編程”的過(guò)程高效地進(jìn)行工程化。通過(guò)交換數(shù)據(jù)注釋時(shí)間來(lái)構(gòu)建少量編程任務(wù),可以減少領(lǐng)域?qū)<业目偣ぷ髁俊?/p>

本文在兩個(gè)領(lǐng)域的三個(gè)數(shù)據(jù)集中給出了實(shí)驗(yàn)結(jié)果指出,該方法減少了多達(dá)10倍的注釋負(fù)擔(dān),而不影響與SOTA方法相比的準(zhǔn)確性。

值得一提的是,論文第一作者Jennifer J. Sun目前就讀于加州理工學(xué)院,本科就讀于多倫多大學(xué),GPA是4.0。

論文地址:

https://arxiv.org/abs/2011.13917

源代碼:

https://github.com/neuroethology/TREBA

最佳學(xué)生論文提名

Less is More: CLIPBERT for Video-and-Language Learning via Sparse Sampling

論文來(lái)自北卡大學(xué)教堂山分校。

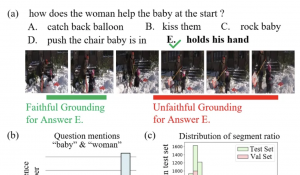

這篇文章主要研究了視頻問答(VQA)問題。

作者提出了一個(gè)通用框架ClipBERT,通過(guò)使用稀疏的采樣,在每個(gè)訓(xùn)練步驟中只使用一個(gè)或幾個(gè)視頻中稀疏的采樣短片,從而為視頻和語(yǔ)言任務(wù)提供負(fù)擔(dān)得起的端到端學(xué)習(xí)。

論文地址:

https://arxiv.org/abs/2102.06183

源代碼:

https://github.com/jayleicn/ClipBERT

Binary TTC: A Temporal Geofence for Autonomous Navigation

論文來(lái)自英偉達(dá)和加州大學(xué)圣芭芭拉分校。

本文研究的問題與自動(dòng)駕駛技術(shù)有關(guān),即接觸時(shí)間(TTC),這是物體與觀察者平面碰撞的時(shí)間,是路徑規(guī)劃的有力工具,它可能比場(chǎng)景中物體的深度、速度和加速度提供信息更多。

TTC有幾個(gè)優(yōu)點(diǎn),包括只需要一臺(tái)單目、未校準(zhǔn)的相機(jī)。然而,每個(gè)像素的回歸TTC并不簡(jiǎn)單,大多數(shù)現(xiàn)有方法對(duì)場(chǎng)景進(jìn)行了過(guò)度簡(jiǎn)化的假設(shè)。本文通過(guò)一系列更簡(jiǎn)單的二元分類來(lái)估計(jì)TTC來(lái)應(yīng)對(duì)這一挑戰(zhàn)。這是第一個(gè)能偶以足夠高的幀速率提供TTC信息的方法。

論文地址:

https://arxiv.org/abs/2101.04777

Real-Time High-Resolution Background Matting

論文來(lái)自華盛頓大學(xué)。

這篇文章提出了一種實(shí)時(shí)高分辨率替換視頻背景的方法,能夠在4K分辨率下以30fps運(yùn)行。

主要挑戰(zhàn)是計(jì)算高質(zhì)量的阿爾法啞光,保留頭發(fā)級(jí)別的細(xì)節(jié),同時(shí)實(shí)時(shí)處理高分辨率圖像。為了實(shí)現(xiàn)這一目標(biāo),作者使用兩個(gè)神經(jīng)網(wǎng)絡(luò);一個(gè)基網(wǎng)絡(luò)計(jì)算低分辨率的結(jié)果,該結(jié)果再通過(guò)第二個(gè)在選擇性補(bǔ)丁上以高分辨率運(yùn)行的網(wǎng)絡(luò)來(lái)改進(jìn)。

與之前方法相比,該方法可以產(chǎn)生更高的質(zhì)量結(jié)果,同時(shí)在速度和分辨率方面都顯著提高。

該項(xiàng)目代碼在GitHub上已經(jīng)收獲3.7k星。

論文地址:

https://arxiv.org/abs/2012.07810

源代碼:

https://github.com/PeterL1n/BackgroundMattingV2

PAMITC獎(jiǎng)

除了最佳論文相關(guān)獎(jiǎng)項(xiàng)外,今年大會(huì)還頒發(fā)了PAMITC獎(jiǎng),包括Longuet-Higgins獎(jiǎng)、年輕研究者獎(jiǎng)以及首屆Thomas Huang紀(jì)念獎(jiǎng)。

獲得Longuet-Higgins獎(jiǎng)的兩篇論文分別是:

《Real-time human pose recognition in parts from single depth image》

《Baby talk: Understanding and generating simple image descriptions》

獲得年輕研究者獎(jiǎng)的是來(lái)自FAIR的Georgia Gkioxari和來(lái)自MIT的Phillip Isola。

去年計(jì)算機(jī)視覺領(lǐng)域先驅(qū)學(xué)者黃煦濤去世,為了紀(jì)念他,CVPR決定從今年開始頒發(fā)Thomas Huang紀(jì)念獎(jiǎng)。

第一屆Thomas Huang紀(jì)念獎(jiǎng)的獲獎(jiǎng)?wù)呤荕IT計(jì)算機(jī)教授Antonio Torralba,今年他共有4篇論文入選CVPR。

本屆CVPR簡(jiǎn)介

由于受新冠疫情影響,今年的CVPR仍在線上以虛擬會(huì)議形式舉行。

今年CVPR共有7039篇有效投稿,接收論文1661篇。

在CVPR召開之際,各大科技公司也陸續(xù)曬出了自己成績(jī)單,谷歌發(fā)布超過(guò)70篇,Facebook發(fā)布了52篇。

國(guó)內(nèi)科技公司近年來(lái)在CVPR上發(fā)表的論文也與國(guó)外巨頭看齊,如商湯發(fā)表66篇、華為諾亞方舟實(shí)驗(yàn)室發(fā)表30篇,曠視發(fā)表22篇,騰訊優(yōu)圖發(fā)表20篇,快手發(fā)表14篇。

當(dāng)然,本屆CVPR相關(guān)的workshop和turotial等活動(dòng)還在進(jìn)行,感興趣的讀者可訪問下方鏈接持續(xù)關(guān)注~

參考鏈接:

http://cvpr2021.thecvf.com/node/141

http://cvpr2021.thecvf.com/node/329