6.99元租H800,一鍵部署Llama3,有羊毛速來薅!

支持OpenSora低成本部署

明敏 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

猛然間,大模型圈掀起一股“降價(jià)風(fēng)潮”。

前腳,智譜、DeepSeek等大模型廠商將API價(jià)格一降再降,輸入100萬tokens僅需1元。

緊接著,GPU租賃的價(jià)格也被打了下來。

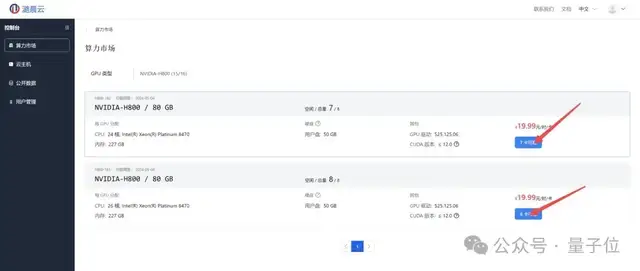

現(xiàn)在潞晨云官方進(jìn)行限時(shí)大額算力補(bǔ)貼,NVIDIA H800的租用價(jià)格,低至6.99元/卡/時(shí);NVIDIA A800為5.99元/卡/時(shí),4090甚至低至1.39元/卡/時(shí)。

不只有租賃服務(wù),平臺(tái)上還支持快速簡(jiǎn)易部署Llama 3微調(diào)、訓(xùn)練、推理。

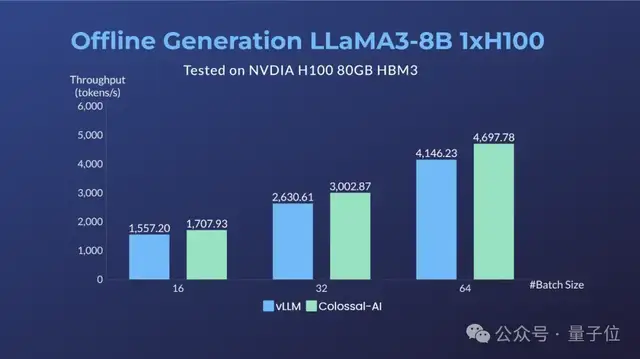

其中在64卡H100集群上,經(jīng)過Colossal-AI優(yōu)化,相比微軟+英偉達(dá)方案,可提升LLaMA3 70B的訓(xùn)練性能近20%,推理性能也優(yōu)于vLLM等方案。

Open-Sora也能玩轉(zhuǎn)。

如上最新動(dòng)向來自潞晨云(https://cloud.luchentech.com)。

他們不僅將個(gè)人開發(fā)者、中小企業(yè)用戶玩轉(zhuǎn)大模型的成本大幅降低,而且上手門檻也不高。

具體來看實(shí)操演示~

部署Llama 3微調(diào)訓(xùn)練推理

潞晨云提供一鍵部署功能,只需簡(jiǎn)單操作即可快速啟動(dòng)計(jì)算環(huán)境。

在最開始時(shí)需要先創(chuàng)建云主機(jī)。比如對(duì)Llama3微調(diào)訓(xùn)練,可在8卡H800上完成,在算力市場(chǎng)中選擇即可。

此處選擇Colossal-llama3訓(xùn)練微調(diào)鏡像,單擊創(chuàng)建按鈕,創(chuàng)建云主機(jī)。

確認(rèn)當(dāng)前路徑名,并修改config文件,輸入教程中的Llama3訓(xùn)練腳本,本腳本已預(yù)置已處理數(shù)據(jù)集為例進(jìn)行微調(diào)。

首先編譯安裝Colossal-AI,其次創(chuàng)建訓(xùn)練需要的文件夾,接著修改hostfile,在鏡像中安裝IP address指令,查看鏡像內(nèi)IP地址。輸入IP address指令將機(jī)內(nèi)IP地址復(fù)制并更新到hostfile中,就完成了Llama3微調(diào)的全部流程。

如果是對(duì)Llama 3推理,可在云主機(jī)上選擇單張H800作為算力資源。

Colossal-Inference現(xiàn)已適配支持了LLaMA-3推理加速。

模型權(quán)重已準(zhǔn)備好,無需額外安裝。然后運(yùn)行生成腳本:

PRETRAINED_MODEL_PATH="/root/notebook/common_data/Meta-Llama-3-8B" # huggingface or local model path

cd ColossalAI/examples/inference/

colossalai run --nproc_per_node 1 llama_generation.py -m PRETRAINED_MODEL_PATH --max_length 80進(jìn)行多卡TP推理、如下例使用兩卡生成:

colossalai run --nproc_per_node 2 llama_generation.py -m PRETRAINED_MODEL_PATH --max_length 80 --tp_size 2運(yùn)行吞吐Benchmark測(cè)試:

PRETRAINED_MODEL_PATH="/root/notebook/common_data/Meta-Llama-3-8B"

git pull # update example benchmark from branch feature/colossal-infer

cd ColossalAI/examples/inference/

python benchmark_llama3.py -m llama3-8b -b 32 -s 128 -o 256 -p PRETRAINED_MODEL_PATH單卡H100對(duì)LLaMA3-8B進(jìn)行Benchmark結(jié)果與vLLM對(duì)比(例:輸入序列長(zhǎng)度128,輸出長(zhǎng)度256)。

而且支持常用的計(jì)算環(huán)境配置保存為私有鏡像,隨時(shí)調(diào)用,減少重復(fù)配置的時(shí)間,并保證環(huán)境的一致性和穩(wěn)定性。

部署Open-Sora推理

除了大火的語言模型外,潞晨云也支持視頻生成模型部署。

前段時(shí)間,潞晨開源全球首個(gè)類Sora架構(gòu)視頻生成模型「Open-Sora 1.0」。

現(xiàn)在在潞晨云上即可部署Open-Sora推理。

Open-Sora推理可以在單卡H800上完成,可在算力市場(chǎng)中選擇1卡H800。

潞晨云Open-Sora鏡像中內(nèi)置了運(yùn)行環(huán)境,同時(shí)預(yù)置了Open-Sora權(quán)重,支持開箱即用。

速來薅羊毛

值得一提的是,潞晨云是按秒計(jì)費(fèi)模式,有效降低了不必要的成本支出,特別適合短期或動(dòng)態(tài)計(jì)算任務(wù)。

除了復(fù)雜機(jī)器學(xué)習(xí)模型訓(xùn)練、海量數(shù)據(jù)分析外,還支持高性能圖形渲染,能為廣泛應(yīng)用場(chǎng)景提供強(qiáng)大的計(jì)算支持和優(yōu)化方案。

用戶在此還能利用市場(chǎng)波動(dòng)實(shí)現(xiàn)成本優(yōu)化,通過算力市場(chǎng)提供潮汐定價(jià)機(jī)制,用戶可根據(jù)需求和預(yù)算選擇不同的算力資源,

最近他們正在搞特別活動(dòng),提供百萬補(bǔ)貼并定期發(fā)放代金券。

用戶在社交媒體和專業(yè)論壇(如知乎、小紅書、微博、CSDN等)上分享使用體驗(yàn),有效分享一次可得100元代金券。每月最佳分享可額外再獲500元代金券。

在平臺(tái)分享AI應(yīng)用鏡像等,可根據(jù)后續(xù)平臺(tái)用戶的調(diào)用時(shí)長(zhǎng),獲得現(xiàn)金獎(jiǎng)勵(lì)。同時(shí)還在社群中不定時(shí)發(fā)放特價(jià)資源、代金券等優(yōu)惠活動(dòng)。

感興趣的童鞋,戳下方鏈接即可了解更多詳情!

https://cloud.luchentech.com

- DeepSeek-V3.2-Exp第一時(shí)間上線華為云2025-09-29

- 你的AI助手更萬能了!天禧合作字節(jié)扣子,解鎖無限新功能2025-09-26

- 你的最快安卓芯片發(fā)布了!全面為Agent鋪路2025-09-26

- 任少卿在中科大招生了!碩博都可,推免學(xué)生下周一緊急面試2025-09-20