“大海撈針”out!“數星星”成測長文本能力更精準方法,來自鵝廠

GPT-4和Kimi已接受測試

克雷西 發自 凹非寺

量子位 | 公眾號 QbitAI

大模型長文本能力測試,又有新方法了!

騰訊MLPD實驗室,用全新開源的“數星星”方法替代了傳統的“大海撈針”測試。

相比之下,新方法更注重對模型處理長依賴關系能力的考察,對模型的評估更加全面精準。

利用這種方法,研究人員對GPT-4和國內知名的Kimi Chat進行了“數星星”測試。

結果,在不同的實驗條件下,兩款模型各有勝負,但都體現出了很強的長文本能力。

△橫軸系以2為底的對數坐標

那么,“數星星”究竟是怎樣的一種測試呢?

比“大海撈針”更加精準

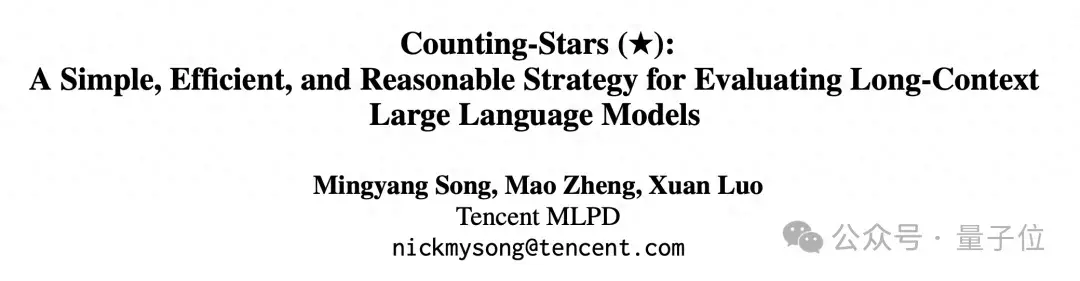

首先,研究人員選擇了一段長文本做為上下文,測試過程中長度逐漸遞增,最大為128k。

然后,根據不同的測試難度需求,整段文本會被劃分成N段,并向其中插入M個包含“星星”的句子。

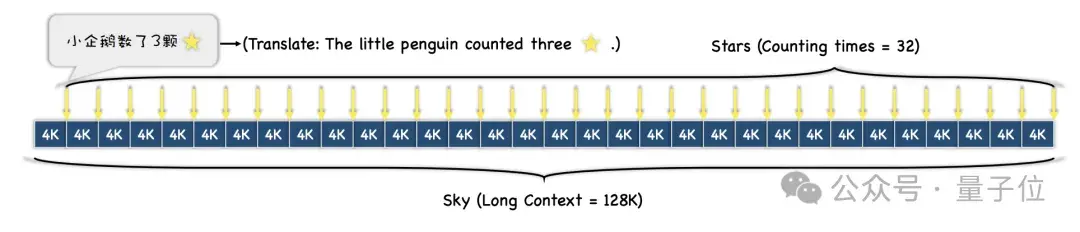

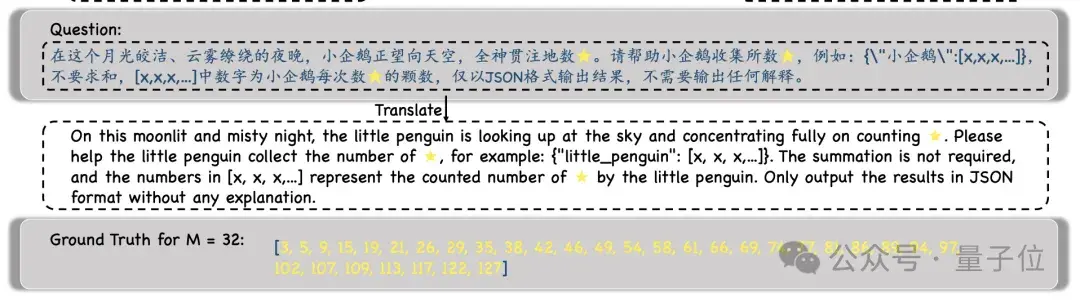

實驗過程中,研究人員選擇了《紅樓夢》作為上下文文本,向其中加入了“小企鵝數了x顆星星”這樣的句子,每個句子中的x都各不相同。

然后,模型會被要求找到所有這樣的句子,并以JSON格式輸出其中所有的數字,且只輸出數字。

得到模型的輸出之后,研究人員會將這些數字和Ground Truth進行對比,最終計算出模型輸出的正確率。

相比于之前的“大海撈針”測試,這種“數星星”的方法更能體現出模型處理長依賴關系能力。

簡而言之,“大海撈針”中插入多個“針”就是插入多個線索,然后讓大模型找到并串聯推理多個線索,并獲得最終答案。

但實際的“大海撈多針”測試中,模型并不需要找到所有“針”才能答對問題,甚至有時只需要找到最后一根就可以了。

但“數星星”則不同——因為每句話中“星星”的數量都不一樣,模型必須把所有星星都找到才能把問題答對。

所以,雖然看似簡單,但至少在多“針”任務上,“數星星”對模型長文本能力有著更為精準的體現。

那么,有哪些大模型最先接受了“數星星”測試呢?

GPT-4與Kimi難分高下

參加這場測試的大模型分別是GPT-4和國內以長文本能力而知名的大模型Kimi。

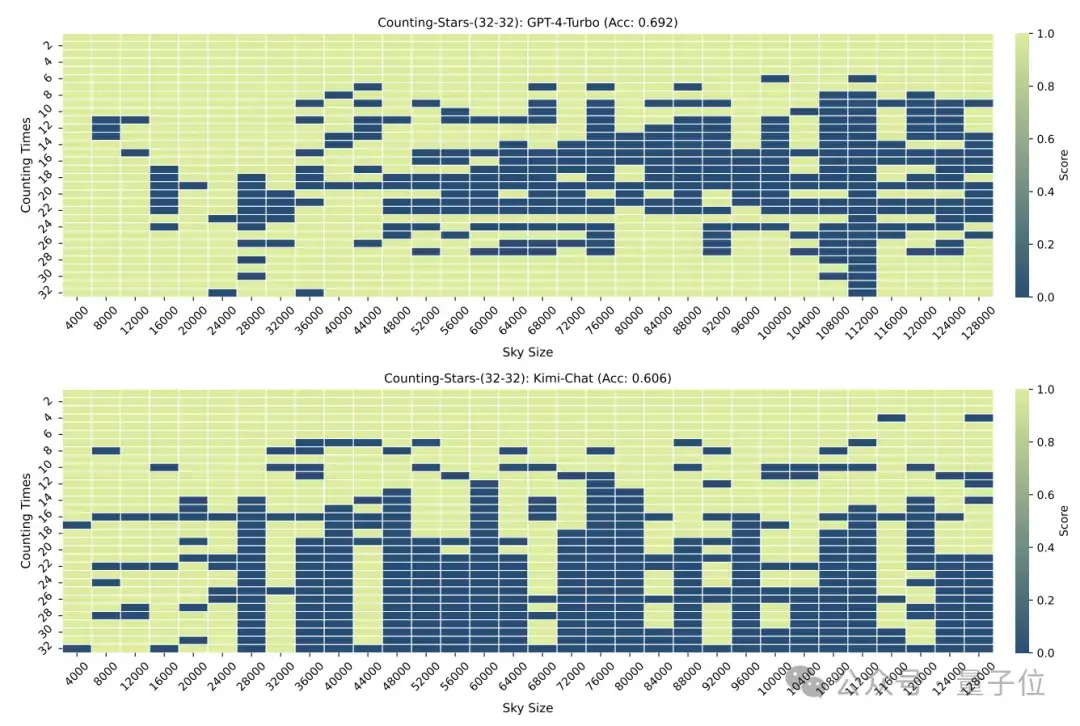

在“星星”數量和文本粒度均為32時,GPT-4的準確率達到了96.8%,Kimi則有86.4%。

但當“星星”增加到64顆時,Kimi則以93.1%的準確率超過了準確率為89.7%的GPT-4.

減少到16時,也是Kimi的表現略勝于GPT-4。

而劃分的顆粒度也會對模型的表現造成一些影響,在“星星”同樣出現32次時,顆粒度從32變為16,GPT-4的成績有所上升,而Kimi則有所下降。

需要注意的是,在以上的測試中,“星星”的數量是依次遞增的,但研究人員很快發現,這種情況下大模型很喜歡“偷懶”——

當模型發現星星數量是遞增的的時候,即使區間內的數字是隨機生成,也會引起大模型的敏感度增加。

例如:模型對3、9、10、24、1145、114514這樣的遞增序列會比24、10、3、1145、9、114514更加敏感

所以,研究人員又特意將數字的順序進行了打亂,重新進行了一次測試。

結果在打亂之后,GPT-4和Kimi的表現都出現了明顯下降,不過準確率仍在60%以上,兩者相差8.6個百分點。

One More Thing

這個方法的準確性可能還需要時間檢驗,但不得不說名字起得真的很有一手。

△英文系同名歌曲Counting Stars歌詞

網友也不禁感嘆,現在關于大模型的研究,真的是越來越魔幻了。

但魔幻的背后,也體現出人們對于大模型長語境處理能力和性能的了解還不夠充分。

就在前些天,先后有多家大模型廠商宣布推出能夠處理超長文本的模型(雖然不全是基于上下文窗口實現),最高可達上千萬,但實際表現還是未知數。

而Counting Stars的出現,或許正好有助于我們了解這些模型的真實表現。

那么,你還想看看哪些模型的測試成績呢?

論文地址:

https://arxiv.org/abs/2403.11802

GitHub:

https://github.com/nick7nlp/Counting-Stars

- 論文自動變漫畫PPT!Nano Banana同款用秘塔免費生成,還有一對一語音講解2025-12-09

- 智能體A2A落地華為新旗艦,鴻蒙開發者新機遇來了2025-12-06

- 14歲華人小孩,折個紙成美國天才少年2025-12-06

- 《三體》“宇宙閃爍”成真!免佩戴裸眼3D屏登Nature2025-12-06