OpenAI突然開源新模型!99.9%的權重是0,新稀疏性方法代替MoE

讓大模型推理像電路圖一樣清晰

聞樂 發自 凹非寺

量子位 | 公眾號 QbitAI

破解AI胡說八道的關鍵,居然是給大模型砍斷99.9%的連接線?

OpenAI悄悄開源新模型,僅有0.4B參數,且99.9%的權重為零。

也就是Circuit Sparsity技術的開源實現。

這是一種通過人為約束模型內部連接的稀疏性,讓模型計算過程可拆解、可理解的大語言模型變體,本質上是為了解決傳統稠密Transformer的黑箱問題,讓內部的計算電路能被人類清晰解讀,知道AI是如何做決策的,避免輕易相信AI的胡話(doge)。

更有人直言這種「極致稀疏+功能解耦」的思路可能會讓當下熱門的MoE(混合專家模型)走上末路。

那么,當Transformer的權重被訓練到近乎全0,會發生什么呢?

放棄粗糙近似,追求原生稀疏

先說說為啥這個模型的思考過程能像電路圖一樣好懂。

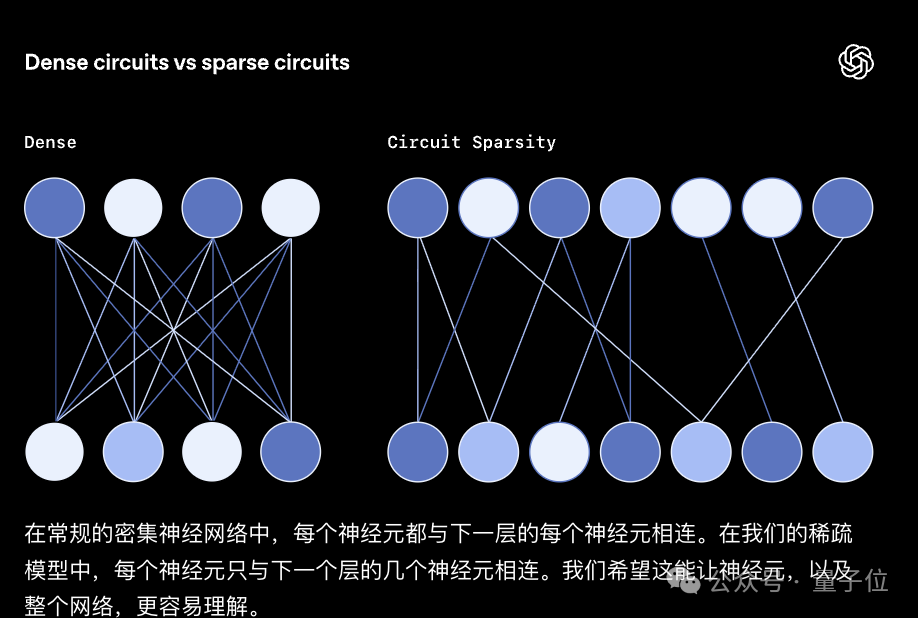

咱們平時用的傳統大模型,內部神經元連接得密密麻麻,權重矩陣幾乎全為非零值,信息傳遞呈現出高度疊加狀態,就像一團扯不開的亂線,沒人能說清它是怎么得出某個結論的。

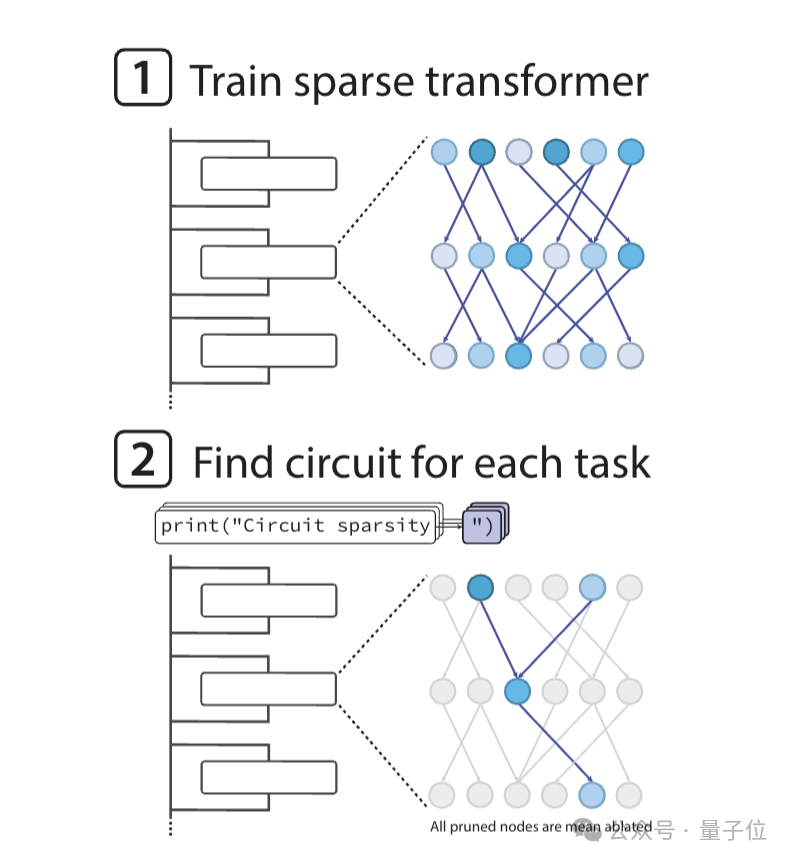

而Circuit Sparsity模型反其道而行之,基于GPT-2風格的Transformer架構訓練時,通過嚴格約束讓權重的L0范數極小,直接把99.9%的無效連接砍斷,只留下千分之一的有效通路。

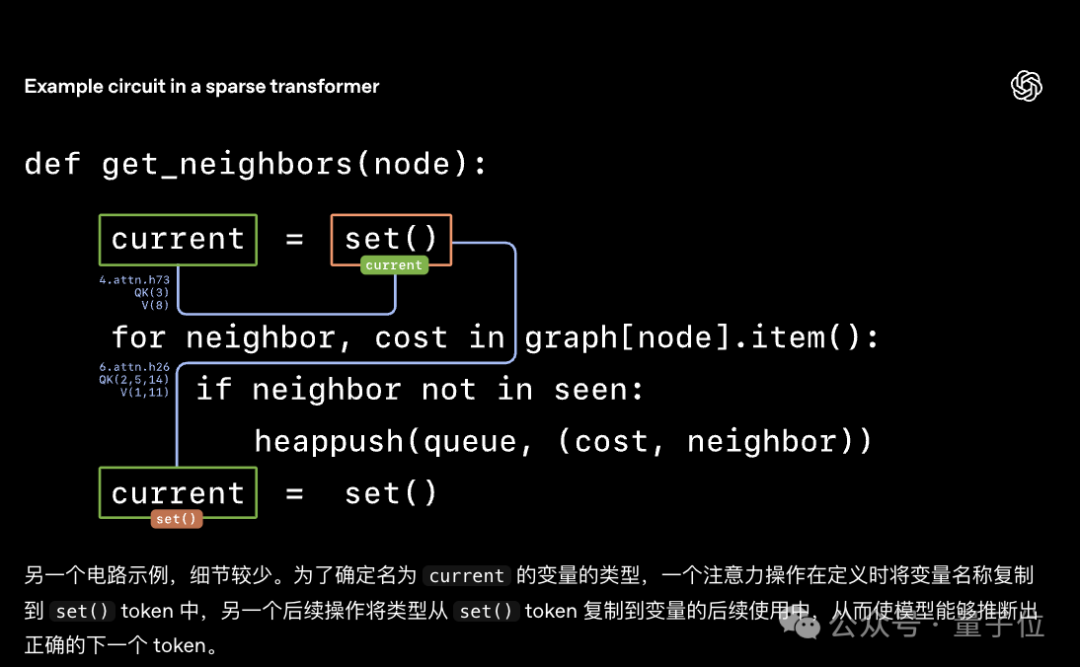

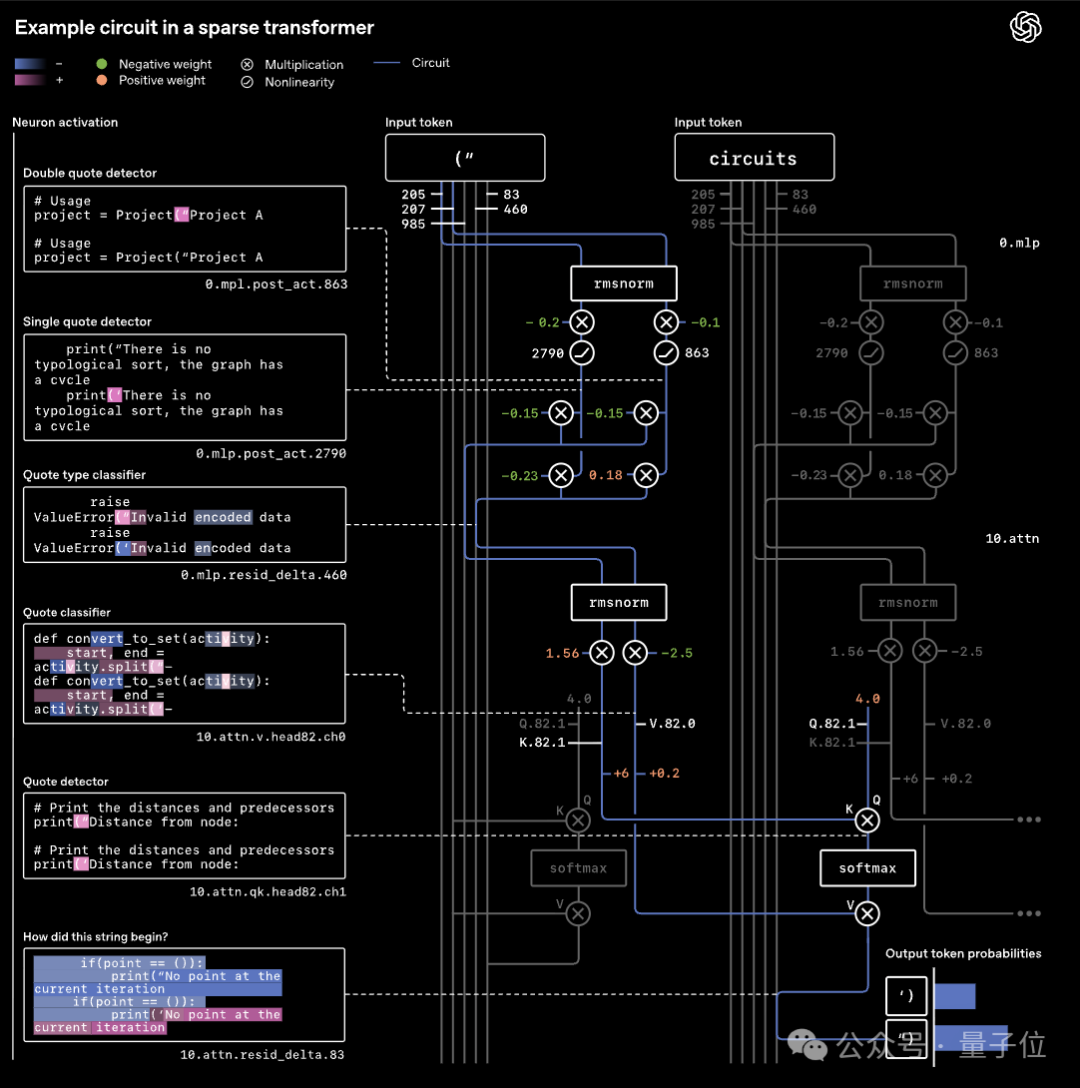

這些留存的非零權重連接就像電路圖里的導線,信息只能沿著固定路徑傳遞;同時,模型還會通過均值屏蔽剪枝方法,為每個任務拆出專屬的最小電路。

比如處理Python引號閉合任務時,僅需2個MLP神經元和1個注意力頭就能構成核心電路,包含專門的引號檢測器、類型分類器等功能模塊,就像電路圖里的電阻、電容,各自管各自的事。

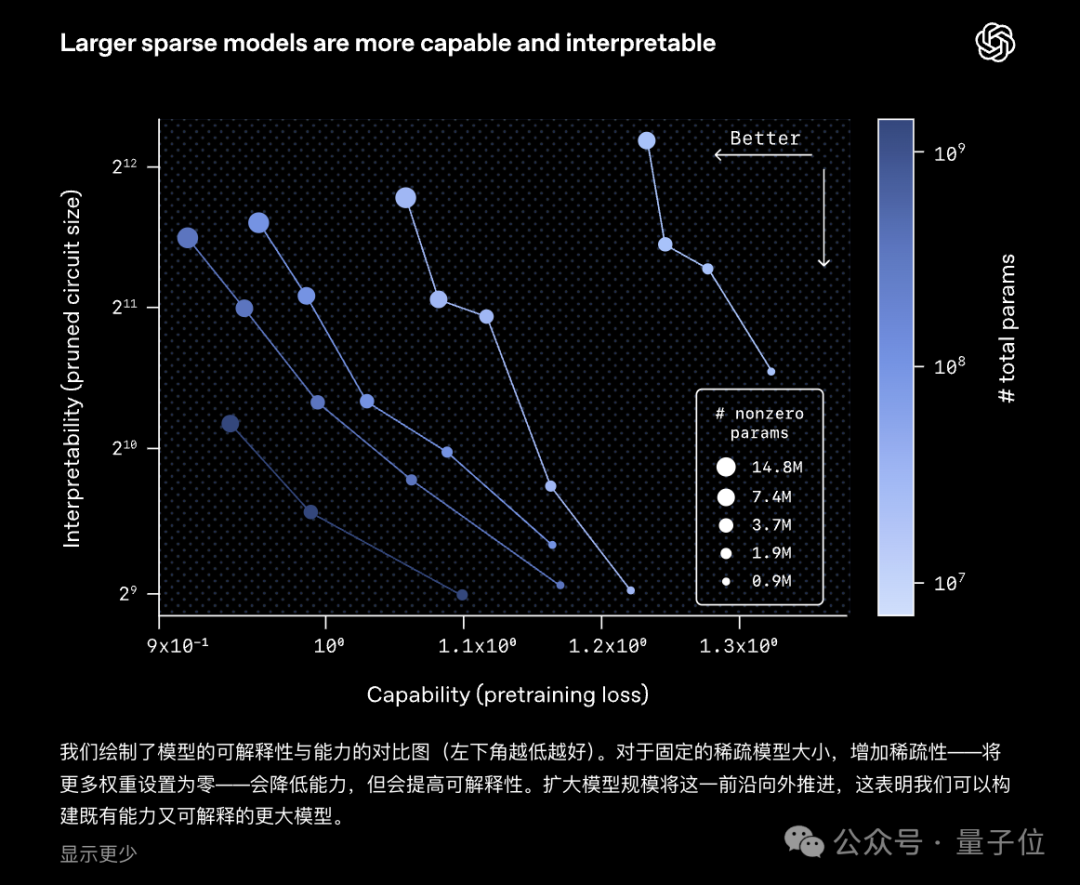

實驗數據顯示,在預訓練損失相同的前提下,稀疏模型的任務專屬電路規模比稠密模型小16倍,且具備嚴格的必要性與充分性——保留這些模塊就能完成任務,刪掉任一節點則直接失效。

這樣,每一步的邏輯都能精準追蹤。

那這時候就不得不提當下主流的MoE模型了。

MoE的核心思路是通過門控網絡將模型拆分為多個專家子網絡,每個專家負責處理一部分任務,靠路由器分配任務來提升效率,本質上是用拆分專家這種粗糙的方式近似稀疏性,目的只是為了適配硬件的稠密矩陣計算需求。

但這種架構存在致命缺陷:

- 一是會割裂模型的特征流形,導致專家同質化嚴重、知識冗余等問題,不同專家間的信息協同依賴復雜的負載均衡損失函數調控,穩定性堪憂;

- 二是專家功能邊界模糊,無法像Circuit Sparsity模型那樣實現微觀機制的精準拆解。

反觀Circuit Sparsity,追求的是模型原生的稀疏性,通過把特征投射到超大維度,再嚴格限制有效激活的節點數量,從設計上就讓每個特征變得單義、正交,從根源上解決了傳統模型一個概念分散在多個節點的疊加問題,不用靠路由器這種hack手段也能避免信息干擾。

不過Circuit Sparsity目前也有明顯的短板,最突出的就是算力成本極高。

訓練和推理的計算量是傳統稠密模型的100-1000倍,暫時還達不到頂尖大模型的能力;

而MoE模型在算力效率和性能平衡上已經很成熟,短期內依然會是工業界的主流選擇。

并且,這項工作也只是AI可解釋性探索的早期一步,未來團隊計劃將技術擴展到更大的模型,解鎖更復雜的推理電路。

目前,團隊發現有兩種克服稀疏模型訓練效率低下的方法:

- 一個是直接從現有的密集模型中提取稀疏電路,這樣直接復用基礎框架,不額外訓練稀疏模型,能大幅降低成本;

- 另一種途徑則是不放棄從頭訓練可解釋稀疏模型的這種思路,但針對訓練慢、成本高的短板,從技術層面優化訓練機制,造出原生可解釋、且能高效落地的模型。

那么就期待研究人員后續用更成熟的工具或技術,逐步揭開大模型的黑箱面紗了。

參考鏈接:

[1]https://openai.com/zh-Hans-CN/index/understanding-neural-networks-through-sparse-circuits/

[2]https://x.com/byebyescaling/status/1999672833778287033?s=20

— 完 —

- 低調霸榜全球最難SQL榜單超兩月,國產AI這次選擇高調開源!2025-12-14

- 谷歌智能體發力:增強版Gemini Deep Research和專屬API都來了2025-12-12

- 又一高管棄庫克而去!蘋果UI設計負責人轉投Meta2025-12-04

- 萬卡集群要上天?中國硬核企業打造太空超算!2025-11-29