具身智能大腦+首個(gè)SaaS開(kāi)源框架,智源研究院刷新10項(xiàng)測(cè)評(píng)基準(zhǔn),加速群體智能新范式

加速具身智能技術(shù)從實(shí)驗(yàn)室走向真實(shí)場(chǎng)景

允中 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

具身智能大腦+全球首個(gè)具身智能SaaS開(kāi)源框架,智源研究院在具身智能領(lǐng)域發(fā)力了——

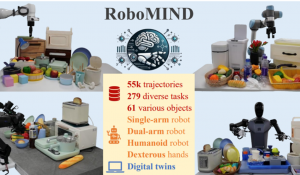

“通用具身大腦”RoboBrain 2.0,面向真實(shí)物理環(huán)境,集感知、推理與規(guī)劃于一體。

全新32B版本憑借時(shí)空認(rèn)知能力的突破,在多項(xiàng)權(quán)威具身智能基準(zhǔn)上全面刷新紀(jì)錄。

RoboOS 2.0,作為全球首個(gè)具身智能SaaS開(kāi)源框架,創(chuàng)新性集成MCP協(xié)議與無(wú)服務(wù)器架構(gòu),實(shí)現(xiàn)輕量化部署,打通智能大腦與異構(gòu)本體協(xié)同通路。

兩招齊出,并且全部開(kāi)源,發(fā)布便在全球社交媒體和技術(shù)社區(qū)引發(fā)廣泛熱議。

不少具身智能專(zhuān)業(yè)人士就指出,具身大腦+跨本體大小腦協(xié)同框架,是推動(dòng)機(jī)器人從“單機(jī)智能”邁向“群體智能”的有效路徑,能加速具身智能技術(shù)從實(shí)驗(yàn)室走向真實(shí)場(chǎng)景。

一起來(lái)看具體技術(shù)細(xì)節(jié)。

RoboBrain 2.0:突破三大核心瓶頸

當(dāng)前主流AI模型在應(yīng)對(duì)真實(shí)物理環(huán)境時(shí),普遍存在三大核心瓶頸:空間理解精度不足、時(shí)間依賴建模薄弱、長(zhǎng)鏈推理能力欠缺。

RoboBrain 2.0正是針對(duì)于此,在三大關(guān)鍵能力上實(shí)現(xiàn)了全面突破,顯著提升了對(duì)復(fù)雜具身任務(wù)的理解與執(zhí)行能力。

- 空間理解:

- 精確點(diǎn)定位和邊界框預(yù)測(cè):能夠根據(jù)復(fù)雜指令在圖像中定位物體或區(qū)域。

- 空間關(guān)系理解:理解物體之間的相對(duì)位置和方向。

- 空間推理:支持基于場(chǎng)景圖的實(shí)時(shí)構(gòu)建和更新,進(jìn)行復(fù)雜的三維空間推理。

- 時(shí)間建模:

- 長(zhǎng)期規(guī)劃:能夠進(jìn)行多步任務(wù)規(guī)劃,支持長(zhǎng)期目標(biāo)的實(shí)現(xiàn)。

- 閉環(huán)交互:支持基于反饋的動(dòng)態(tài)調(diào)整,適應(yīng)動(dòng)態(tài)環(huán)境。

- 多智能體協(xié)作:能夠協(xié)調(diào)多個(gè)智能體的行為,完成復(fù)雜任務(wù)。

- 長(zhǎng)鏈推理:

- 鏈?zhǔn)酵评恚耗軌蜻M(jìn)行多步推理,支持復(fù)雜任務(wù)的逐步解決。

- 因果邏輯:能夠從復(fù)雜指令中提取因果邏輯,并與環(huán)境狀態(tài)對(duì)齊。

- 決策透明性:能夠生成推理過(guò)程的詳細(xì)解釋?zhuān)С譀Q策的透明性和可解釋性。

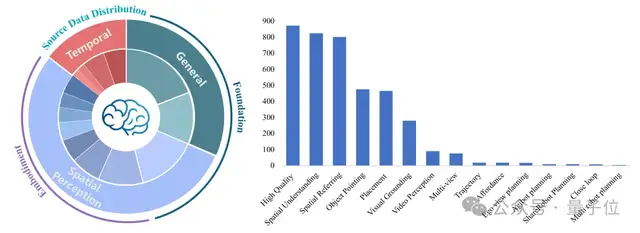

△RoboBrain能力概覽圖

模塊化編碼器-解碼架構(gòu)

具體來(lái)說(shuō),RoboBrain 2.0采用模塊化的編碼器 – 解碼器架構(gòu),為復(fù)雜的具身任務(wù)實(shí)現(xiàn)了感知、推理和規(guī)劃的統(tǒng)一。

與專(zhuān)注于通用靜態(tài)視覺(jué)問(wèn)答(VQA)的傳統(tǒng)視覺(jué) – 語(yǔ)言模型(VLMs)不同,RoboBrain 2.0在保持強(qiáng)大通用VQA能力的同時(shí),專(zhuān)門(mén)針對(duì)具身推理任務(wù),如空間感知、時(shí)間建模和長(zhǎng)鏈因果推理。該架構(gòu)將高分辨率圖像、多視圖輸入、視頻幀、語(yǔ)言指令和場(chǎng)景圖編碼為統(tǒng)一的多模態(tài)標(biāo)記序列,以進(jìn)行全面處理。

△RoboBrain2.0模型架構(gòu)圖

多模態(tài)數(shù)據(jù)集和分階段訓(xùn)練策略

訓(xùn)練方面,RoboBrain 2.0采用的是多模態(tài)數(shù)據(jù)集和分階段訓(xùn)練策略。

RoboBrain 2.0基于全面且多樣化的多模態(tài)數(shù)據(jù)集,融合高分辨率圖像、多視角視頻序列、場(chǎng)景圖、3D場(chǎng)景數(shù)據(jù)及復(fù)雜自然語(yǔ)言指令,能全面賦能機(jī)器人在具身環(huán)境中的感知、推理與行動(dòng)能力。

△RoboBrain 2.0訓(xùn)練數(shù)據(jù)集

該多模態(tài)數(shù)據(jù)集聚焦三大核心領(lǐng)域,為復(fù)雜物理場(chǎng)景提供有力支持:

- 通用多模態(tài)理解:整合標(biāo)準(zhǔn)視覺(jué)問(wèn)答、區(qū)域級(jí)查詢、OCR視覺(jué)問(wèn)答及多輪視覺(jué)對(duì)話,優(yōu)化語(yǔ)言表達(dá)的多樣性與語(yǔ)義一致性,通過(guò)豐富的視覺(jué)-語(yǔ)言交互數(shù)據(jù),提升模型對(duì)復(fù)雜任務(wù)的理解與響應(yīng)能力,適應(yīng)從簡(jiǎn)單問(wèn)答到多輪對(duì)話的多樣場(chǎng)景。

- 空間感知:支持高精度物體定位、邊界框預(yù)測(cè)及對(duì)象功能性識(shí)別,覆蓋室內(nèi)外復(fù)雜視覺(jué)場(chǎng)景與3D空間推理,助力機(jī)器人精準(zhǔn)解析物體關(guān)系、空間屬性及場(chǎng)景上下文,應(yīng)對(duì)遮擋、多視角變化等挑戰(zhàn),滿足高精度定位與交互需求。

- 時(shí)間建模:通過(guò)多模態(tài)數(shù)據(jù)支持長(zhǎng)程任務(wù)規(guī)劃、閉環(huán)反饋機(jī)制及多智能體協(xié)作,強(qiáng)化模型在動(dòng)態(tài)環(huán)境中的任務(wù)分解、動(dòng)作序列預(yù)測(cè)及實(shí)時(shí)交互能力,確保在復(fù)雜物理場(chǎng)景中實(shí)現(xiàn)連續(xù)決策、靈活協(xié)作與高效任務(wù)執(zhí)行。RoboBrain 2.0以卓越的多模態(tài)感知、精細(xì)的空間推理及強(qiáng)大的長(zhǎng)時(shí)規(guī)劃能力,賦能機(jī)器人在具身環(huán)境中進(jìn)行交互推理、多智能體協(xié)作及高效任務(wù)規(guī)劃,助力復(fù)雜物理場(chǎng)景的智能感知與決策。

RoboBrain 2.0采用三階段遞進(jìn)式訓(xùn)練流程。

- 第一階段:基礎(chǔ)時(shí)空學(xué)習(xí)(Foundational Spatiotemporal Learning)

在第一階段,RoboBrain 2.0專(zhuān)注于構(gòu)建其在空間感知和時(shí)間理解方面的基礎(chǔ)能力。模型通過(guò)大規(guī)模多模態(tài)數(shù)據(jù)集進(jìn)行訓(xùn)練,這些數(shù)據(jù)集涵蓋了密集標(biāo)注的圖文數(shù)據(jù)、視頻問(wèn)答以及指代表達(dá)理解任務(wù)。

通過(guò)這一階段的訓(xùn)練,模型能夠處理靜態(tài)圖像和視頻流,掌握物體的基本空間關(guān)系和運(yùn)動(dòng)事件,為后續(xù)更復(fù)雜的任務(wù)奠定了堅(jiān)實(shí)的基礎(chǔ)。

- 第二階段:具身時(shí)空增強(qiáng)(Embodied Spatiotemporal Enhancement)

在第二階段,RoboBrain 2.0通過(guò)引入高分辨率多視圖圖像、第一人稱(chēng)視頻數(shù)據(jù)以及導(dǎo)航和交互任務(wù),進(jìn)一步增強(qiáng)其在具身任務(wù)中的時(shí)空建模能力。模型學(xué)習(xí)處理長(zhǎng)序列的時(shí)空信息,支持多智能體協(xié)調(diào)、長(zhǎng)期規(guī)劃和動(dòng)態(tài)環(huán)境中的適應(yīng)性決策。

這一階段的訓(xùn)練使模型能夠更好地將歷史視覺(jué)信息與當(dāng)前指令相結(jié)合,從而在動(dòng)態(tài)交互環(huán)境中實(shí)現(xiàn)更連貫的長(zhǎng)期規(guī)劃和穩(wěn)健的場(chǎng)景理解。

- 第三階段:具身情境中的推理鏈訓(xùn)練(Chain-of-Thought Reasoning in Embodied Contexts)

在第三階段,RoboBrain 2.0通過(guò)監(jiān)督微調(diào)和強(qiáng)化微調(diào),進(jìn)一步提升其在復(fù)雜具身任務(wù)中的推理能力。模型使用多輪推理示例進(jìn)行訓(xùn)練,這些示例涵蓋了長(zhǎng)期任務(wù)規(guī)劃、操作預(yù)測(cè)、閉環(huán)交互、時(shí)空理解以及多機(jī)器人協(xié)作等任務(wù)。

通過(guò)這一階段的訓(xùn)練,模型能夠生成推理鏈,支持復(fù)雜任務(wù)的逐步推理和決策,從而在具身情境中實(shí)現(xiàn)更高效、更準(zhǔn)確的推理和規(guī)劃能力。

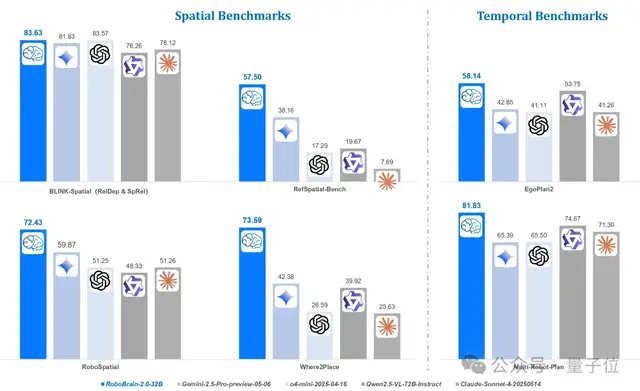

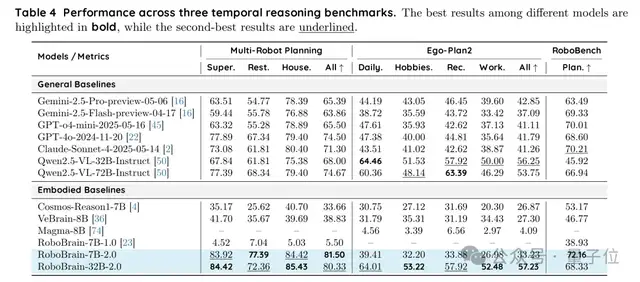

研究人員采用FlagEvalMM框架,全面驗(yàn)證了RoboBrain 2.0的空間與時(shí)間推理能力。

- 空間推理:在BLINK(83.95)、CV-Bench(85.75)、Where2Place(73.59)等9項(xiàng)基準(zhǔn)測(cè)試中,RoboBrain-32B/7B-2.0屢獲SOTA,精準(zhǔn)實(shí)現(xiàn)物體定位、邊界框預(yù)測(cè)及空間參照,超越Gemini、GPT-4o等基線。

- 時(shí)間推理:在多機(jī)器人規(guī)劃(80.33)、Ego-Plan2(57.23)、RoboBench(72.16)中,展現(xiàn)卓越長(zhǎng)程規(guī)劃、閉環(huán)反饋及多智能體協(xié)作能力,領(lǐng)跑Qwen2.5-VL、Claude等模型。

值得一提的是,除了32B版本,此前智源研究院還推出了RoboBrain 2.0?7B版本,具備緊湊高效的模型結(jié)構(gòu),其輕量化設(shè)計(jì)適配邊緣設(shè)備部署需求,能在低資源環(huán)境下穩(wěn)定運(yùn)行,同時(shí)相比主流的開(kāi)閉源模型性能依舊強(qiáng)勁。

從單機(jī)智能邁向群體智能

依托跨本體大小腦協(xié)作框架RoboOS 2.0的多本體規(guī)劃能力,RoboBrain 2.0已實(shí)現(xiàn)多智能體間協(xié)作執(zhí)行任務(wù),支持商超廚房居家等多場(chǎng)景部署。

跨本體具身大小腦協(xié)作框架RoboOS 2.0是全球首個(gè)基于具身智能SaaS平臺(tái)、支持無(wú)服務(wù)器一站式輕量化機(jī)器人本體部署的開(kāi)源框架。

同時(shí),RoboOS 2.0也是全球首個(gè)支持MCP的跨本體具身大小腦協(xié)作框架,旨在構(gòu)建具身智能領(lǐng)域的“應(yīng)用商店”生態(tài)。

RoboOS 2.0實(shí)現(xiàn)了大腦云端優(yōu)化推理部署與小腦技能的免適配注冊(cè)機(jī)制,顯著降低開(kāi)發(fā)門(mén)檻,典型場(chǎng)景下,相關(guān)代碼量?jī)H為傳統(tǒng)手動(dòng)注冊(cè)方式的1/10。

具體來(lái)說(shuō),RoboOS是面向多機(jī)器人協(xié)作的“大腦-小腦”分層系統(tǒng),包含三大核心組件:(a) 基于云計(jì)算的具身大腦模型,負(fù)責(zé)高級(jí)認(rèn)知與多智能體協(xié)同;(b) 分布式小腦模塊群,專(zhuān)司機(jī)器人專(zhuān)項(xiàng)技能執(zhí)行;(c) 實(shí)時(shí)共享內(nèi)存機(jī)制,強(qiáng)化環(huán)境態(tài)勢(shì)感知能力。

△RoboOS 2.0框架(SaaS + MCP模式)

相較于1.0,RoboOS 2.0對(duì)端到端推理鏈路進(jìn)行了系統(tǒng)級(jí)優(yōu)化,整體性能提升達(dá)30%,全鏈路平均響應(yīng)時(shí)延低至3ms以下,端云通信效率提升27倍。

在功能層面,新增了多本體時(shí)空記憶場(chǎng)景圖(Scene Graph)共享機(jī)制,支持動(dòng)態(tài)環(huán)境下的實(shí)時(shí)感知與建模;同時(shí)引入多粒度任務(wù)監(jiān)控模塊,實(shí)現(xiàn)任務(wù)閉環(huán)反饋,有效提升機(jī)器人任務(wù)執(zhí)行的穩(wěn)定性與成功率。

RoboOS多機(jī)協(xié)作實(shí)現(xiàn)流程包含四個(gè)關(guān)鍵階段:首先通過(guò)分層任務(wù)分解將復(fù)雜任務(wù)逐級(jí)拆解,隨后基于網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)進(jìn)行子任務(wù)動(dòng)態(tài)分配,再由分布式智能體集群并行執(zhí)行各子任務(wù),最后通過(guò)實(shí)時(shí)共享內(nèi)存機(jī)制動(dòng)態(tài)更新環(huán)境狀態(tài)與任務(wù)進(jìn)度。

基于RoboOS 2.0協(xié)作框架,可充分發(fā)揮RoboBrain 2.0強(qiáng)大的空間理解、時(shí)序規(guī)劃與閉環(huán)推理能力的同時(shí),一鍵下載并部署來(lái)自全球開(kāi)發(fā)者創(chuàng)建的相同型號(hào)機(jī)器人本體的小腦技能,完成大小腦的全鏈路無(wú)縫整合。

RoboBrain 2.0可通過(guò)像素級(jí)空間理解,支持下游小腦模型高精度抓取、搬運(yùn)、放置等操作,同時(shí),根據(jù)實(shí)時(shí)感知任務(wù)執(zhí)行狀態(tài)調(diào)整執(zhí)行計(jì)劃,適應(yīng)動(dòng)態(tài)環(huán)境變化,實(shí)現(xiàn)閉環(huán)反饋機(jī)制。

目前,RoboBrain 2.0及RoboOS 2.0已全面開(kāi)源,模型權(quán)重、訓(xùn)練代碼與評(píng)測(cè)基準(zhǔn)全部可用。

智源研究院還同步推出單機(jī)版產(chǎn)品線及RoboSkill技能商店,通過(guò)深度集成實(shí)現(xiàn)機(jī)器人技能模塊智能匹配與一鍵適配功能,標(biāo)準(zhǔn)化接口有效消除廠商與硬件適配流程差異。還有開(kāi)箱即用鏡像,支持“三行指令”極速部署,全面賦能開(kāi)發(fā)者高效構(gòu)建智能機(jī)器人系統(tǒng)。

傳送門(mén)

RoboBrain 2.0

Page:https://superrobobrain.github.io

GitHub:https://github.com/FlagOpen/RoboBrain2.0

ArXiv:https://arxiv.org/abs/2507.02029

Checkpoint-7B:https://huggingface.co/BAAI/RoboBrain2.0-7B

Checkpoint-32B:https://huggingface.co/BAAI/RoboBrain2.0-32B

RoboBrain2.0的FlagRelease多芯片鏡像:

https://huggingface.co/FlagRelease/RoboBrain2.0-7B-FlagOS

https://huggingface.co/FlagRelease/RoboBrain2.0-32B-FlagOS

https://huggingface.co/FlagRelease/RoboBrain2.0-7B-FlagOS-Ascend

RoboOS 2.0

Page:https://flagopen.github.io/RoboOS

GitHub:https://github.com/FlagOpen/RoboOS

GitHub單機(jī)輕量版:https://github.com/FlagOpen/RoboOS/tree/stand-alone

GitHub技能商店:https://github.com/FlagOpen/RoboSkill

ArXiv:https://arxiv.org/abs/2505.03673

— 完 —

計(jì)-18.png)