DeepSeek-R2為什么還沒發?

一覽R2“難產”始末

全網翹首以盼的DeepSeek-R2,再次被曝推遲!

據The Information報道,由于DeepSeek CEO梁文鋒始終對R2的表現不滿意,因此R2遲遲未能發布。

此外,他們還援引兩位國內知情人士的消息稱,R2研發進程緩慢可能是由于缺少英偉達H20芯片。

要知道R1的訓練總計耗費了3萬塊H20(國內特供版)、1萬塊H800和1萬塊H100。

所以在H20吃緊的情況下,預計耗費更多算力資源的R2難免受到波及。

事實上,這不是R2第一次被曝項目延期了,最早能追溯到今年4月——

一覽R2“難產”始末

仔細一梳理,原來人們對R2的期待,早在V3新版本出來后就開始了。

去年12月底,DeepSeek發布了至今被視為“性價比代表”的DeepSeek-V3模型。到了今年3月24日,官方發布公告稱對V3進行了一次升級,新版本代號為V3-0324。

雖然官方輕描淡寫只說是“小版本升級”,但很多人實測下來可一點也不小。

于是人們開始推測,在V3-0324已經取得明顯進步的情況下,是不是可以用它來訓練R2模型。

這里需要補充一下,DeepSeek主打推理的R1模型,正是在DeepSeek-V3-Base的基礎上,結合冷啟動數據和多階段訓練流程構建的。

所以說,V3更新了,R2還會遠嗎?

并且結合R1是在初代V3一個月之后發布,當時人們按照這一節奏預測——

R2大概率將在4月上線。(網友os:3月發布V3-0324,4月上R2,完美~)

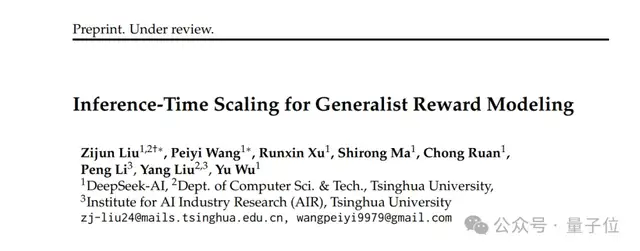

剛進入4月,DeepSeek就發了一篇關于推理時Scaling Law的論文,引得大家紛紛聯想是不是R2馬上要來了。

論文題目為《Inference-Time Scaling for Generalist Reward Modeling》,由DeepSeek和清華大學共同提出。

他們核心提出了一種叫做SPCT(Self-Principled Critique Tuning)的方法——

首次提出通過在線強化學習(RL)優化原則和批判生成,實現推理時擴展。

之所以要做這么一項研究,是因為之前大家用獎勵模型(Reward Model, RM)在RL中為大語言模型生成獎勵信號。但現有的RM在通用領域卻表現出受限的情況,尤其是在面對復雜、多樣化任務的時候。

不過論文發布后,中間一直沒啥動靜。

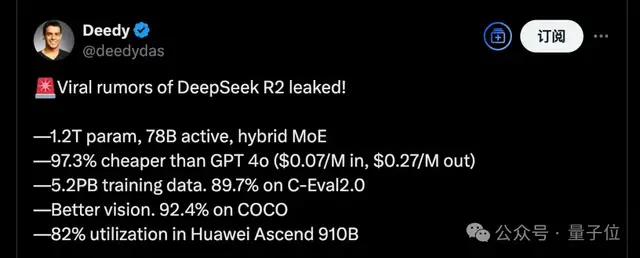

直到4月底,坊間開始瘋傳一組R2的泄露參數:1.2T萬億參數,5.2PB訓練數據,高效利用華為芯片……一整個真假難辨。

時間不知不覺就進入了5月,R2依舊沒有絲毫官方消息。

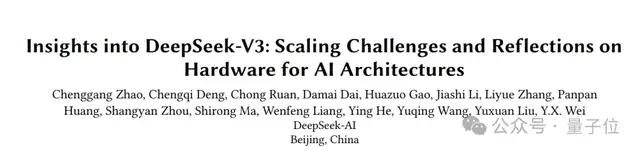

5月中旬,DeepSeek發布了一篇有梁文鋒親自署名的論文。

這一次,團隊把DeepSeek-V3在訓練和推理過程中,如何解決“硬件瓶頸”的方法公布了出來。

后來又在月末端午節前,官方上線了新版R1——DeepSeek-R1-0528。

看名字你可能以為是個小版本更新,但實際上它在LiveCodeBench上幾乎與OpenAI o3-high相當。

由于編程能力強悍,當時一眾網友驚呼:講真這其實就是R2吧!

但直到目前為止,R2依舊未能真正和大家見面。

網友反應亮了

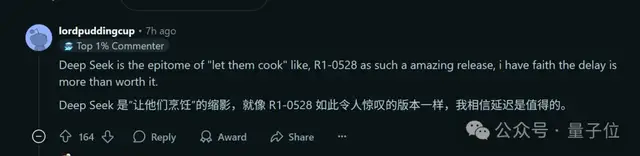

BTW,就在The Information曝出延遲消息后,Reddit相關帖子下最高贊網友表示:

我相信延遲是值得的。

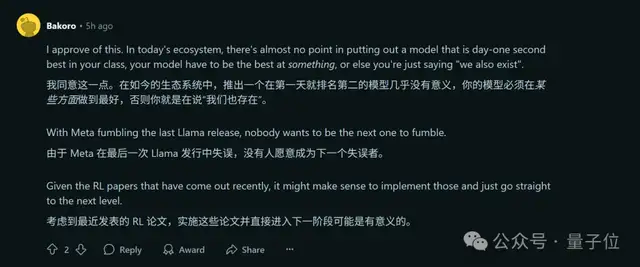

畢竟Llama 4 翻車在前,“沒有人愿意成為下一個失誤者”。

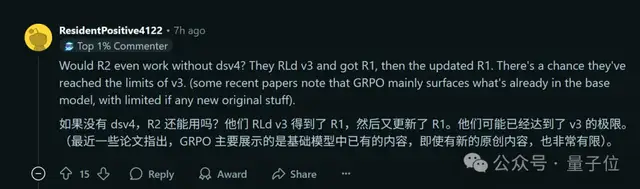

但與此同時,也有人合理推測,R2好歹要等V4出來再說。

理由是,從官方當前發布的論文和一些版本更新來看,V3可能已經到達極限了。

嗯,6月即將結束,誰說7月不值得期待呢(doge)。

- 英偉達巧用8B模型秒掉GPT-5,開源了2025-12-06

- SpaceX估值8000億美元超OpenAI,IPO就在明年2025-12-06

- 騰訊發布EdgeOne Pages正式版:國內首個邊緣全棧開發平臺,內測階段用戶突破15萬2025-12-05

- 中國AI計算開放架構創新風向標:HAIC2025重磅啟幕2025-12-04