5分鐘端側(cè)部署視覺(jué)大模型!專為Transformer優(yōu)化的AI芯片來(lái)了

性能可達(dá)361 FPS

豐色 發(fā)自 凹非寺

量子位 | 公眾號(hào) QbitAI

有沒(méi)有人好奇:

大模型那么香,我們將它從云側(cè)拿到端側(cè)開(kāi)發(fā)應(yīng)用,比如讓每臺(tái)手機(jī)都標(biāo)配一個(gè)大模型,豈不是更香?

——我們還沒(méi)實(shí)現(xiàn)這個(gè)愿望,當(dāng)然不是因?yàn)椴幌耄遣荒堋?/p>

由于芯片架構(gòu)不同,在端側(cè)部署時(shí)往往需要開(kāi)發(fā)人員對(duì)模型網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行一通修改才能勉強(qiáng)“上車”,但改完之后性能難保證,更別提功耗、成本等一系列本就存在的問(wèn)題了。

不過(guò)現(xiàn)在,一款號(hào)稱現(xiàn)實(shí)開(kāi)源模型直接拿來(lái)用,還能讓性能、功耗與自動(dòng)駕駛領(lǐng)域基于GPU的端側(cè)芯片有得一拼的平臺(tái)誕生了。

它叫AX650N,來(lái)自愛(ài)芯元智,對(duì)Transformer架構(gòu)支持效果尤甚。

Transformer不用多說(shuō),它是當(dāng)下最火的ChatGPT、Stable Diffusion等大模型背后的基礎(chǔ)架構(gòu)。

那么具體效果如何?咱這就展開(kāi)參數(shù)一一來(lái)看。

5分鐘就能完成原版Swin Transformer端側(cè)部署

AX650N是AI芯片公司愛(ài)芯元智發(fā)布的第三代端側(cè)芯片。

其構(gòu)成包括CPU和NPU等,其中CPU采用的是八核A55處理器,NPU則采用了自研混合精度技術(shù),可以做到43.2TOPs(INT4)或10.8TOPs(INT8)的高算力。

AX650N主要用于端側(cè)視覺(jué)感知。

目前在該領(lǐng)域,業(yè)界主要還是基于CNN網(wǎng)絡(luò)開(kāi)發(fā)應(yīng)用。

相反,準(zhǔn)確率和性能雙佳的Swin Transformer并沒(méi)有得到突出的大規(guī)模落地,還是多部署于云端服務(wù)器。

愛(ài)芯元智表示,這是因?yàn)镚PU對(duì)于MHA結(jié)構(gòu)(Transformer中的多頭注意力機(jī)制)計(jì)算支持更友好。

而目前的大部分端側(cè)AI芯片由于其架構(gòu)限制為了保證CNN結(jié)構(gòu)的模型效率更好,基本上對(duì)MHA結(jié)構(gòu)沒(méi)有過(guò)多性能優(yōu)化,因此我們需要修改Swin Transformer的網(wǎng)絡(luò)結(jié)構(gòu)才能勉強(qiáng)將其部署在端側(cè)——

一旦修改網(wǎng)絡(luò)結(jié)構(gòu),就意味著將出現(xiàn)一系列問(wèn)題,例如精度下降,精度一降就得對(duì)模型進(jìn)行重訓(xùn),這個(gè)過(guò)程就要以星期甚至是月來(lái)計(jì)算了。

愛(ài)芯元智聯(lián)合創(chuàng)始人、副總裁劉建偉介紹:

用AX650N在端側(cè)部署原版Swin Transformer,從拿到測(cè)試板到demo復(fù)現(xiàn),只需要5分鐘,再到在自己的私有環(huán)境里跑起來(lái)私有模型,只要1個(gè)小時(shí)就能搞定。

——不僅能跑起來(lái),還跑得飛快、性能高且功耗低。

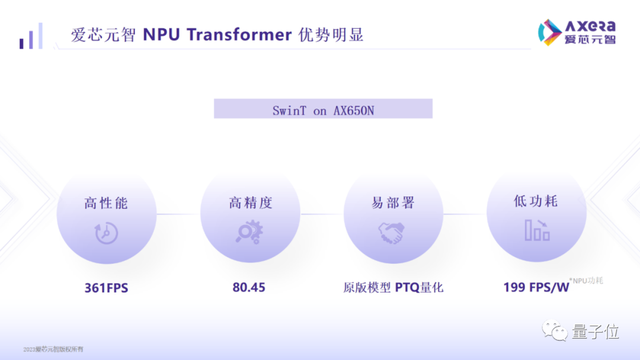

具體而言,AX650N端側(cè)部署Swin Transformer性能可達(dá)361 FPS。

這是什么概念?

某知名芯片商開(kāi)發(fā)的基于GPU的高端域控SoC,用于自動(dòng)駕駛領(lǐng)域,跑的也是400幀以內(nèi)的一個(gè)數(shù)字。AX650N基本可與之相媲美了。

不僅性能高,AX650N還能保證準(zhǔn)確率,做到高于市場(chǎng)水平的80.45%精度。

與此同時(shí),功耗也非常低,即能效非常高,它可以跑到199 FPS/W,是上面提到的基于GPU的高端域控SoC的數(shù)倍(該芯片整體TDP大約是15到60W,實(shí)測(cè)增量功耗20多W,合下來(lái)大約是20 FPS/W)。

除了這些優(yōu)勢(shì),AX650N還支持低比特混合精度,遇到大規(guī)模參數(shù)的模型,我們就可以采用INT4來(lái)減少內(nèi)存和帶寬占用率,從而降低大模型在端側(cè)邊緣側(cè)部署的成本。

基于此,愛(ài)芯元智表示,AX650N可以說(shuō)是成為了目前對(duì)Transformer架構(gòu)支持最好的一個(gè)端側(cè)部署平臺(tái)。

對(duì)了,除了上面的Swin Transformer,AX650N還適配ViT/DeiT、DETR在內(nèi)的Transformer模型,Meta最新發(fā)布的視覺(jué)模型DINOv2也達(dá)到了30幀以上的運(yùn)行結(jié)果。

因此,有了AX650N,我們?cè)谙掠芜M(jìn)行檢測(cè)、分類、分割等操作也更加方便。

據(jù)悉,接下來(lái),愛(ài)芯元智AX650N將會(huì)針對(duì)Transformer結(jié)構(gòu)進(jìn)行進(jìn)一步優(yōu)化,并且將探索多模態(tài)方向的Transformer模型。

Ps. Swin Transformer以及DETR和EfficientViT的具體部署方法,愛(ài)芯元智官方提供了詳細(xì)教程,這里就不再贅述,大家戳文末鏈接即可查看~

△Swin Transformer性能實(shí)測(cè),3.6Tops都能跑100多幀

邊緣側(cè)、端側(cè)部署大模型,是趨勢(shì)

再回到大模型本身這個(gè)話題,大家有沒(méi)有思考過(guò)它的蓬勃發(fā)展究竟會(huì)給我們帶來(lái)什么?

奇績(jī)創(chuàng)壇CEO陸奇博士在最近的一場(chǎng)演講中提到:

當(dāng)年他剛從CMU畢業(yè)時(shí),買一張地圖需要3美元,現(xiàn)在咱們只需要在網(wǎng)上花費(fèi)300毫秒就能搜到一張,信息獲取的成本已接近免費(fèi)。

愛(ài)芯元智相關(guān)負(fù)責(zé)人就表示,大模型從某種程度上會(huì)重復(fù)如上故事,也就是說(shuō),我們可以暢想以后打開(kāi)手機(jī)或者其他終端,就能獲得一個(gè)諸如私人醫(yī)生和律師、廚師的AI助理,它無(wú)所不知無(wú)所不曉,為我們提供成本非常低廉的咨詢等服務(wù)。

另一方面,比如智能音箱,如果能夠在本地用上大模型,它就能做一些真正稱得上是智能的交互,而不是只會(huì)提取關(guān)鍵詞。

為了實(shí)現(xiàn)諸如這樣的愿望,大模型部署就不會(huì)只局限于云端。

△圖源愛(ài)芯元智官網(wǎng)

“而從量的角度來(lái)講,邊緣側(cè)、端側(cè)的需求一定比云側(cè)更大,畢竟邊緣側(cè)、端側(cè)設(shè)備會(huì)更多。”

像我們今天講的Transformer端側(cè)部署,“但凡是會(huì)用到攝像頭的業(yè)務(wù),都會(huì)對(duì)它感興趣。”

愛(ài)芯元智介紹,相比CNN網(wǎng)絡(luò),在端側(cè)部署Transformer最大的好處之一就是可以解決以前長(zhǎng)尾場(chǎng)景下,AI智能投入太高的問(wèn)題。

比如河道垃圾監(jiān)測(cè),用CNN等網(wǎng)絡(luò),可能出現(xiàn)一類新的垃圾就得花數(shù)月去重新采集數(shù)據(jù)進(jìn)行訓(xùn)練,不然系統(tǒng)就認(rèn)不出來(lái)。

而基于Transformer的視覺(jué)大模型,采用無(wú)監(jiān)督學(xué)習(xí)的方式進(jìn)行了訓(xùn)練,遇到新的就能直接識(shí)別(也就是zero-shot或者one-shot能力),可以省去很大的時(shí)間和訓(xùn)練成本。

不過(guò)要開(kāi)發(fā)可以讓Transformer模型輕松又高效地在端側(cè)跑起來(lái)的平臺(tái),要面對(duì)的困難并不少。

例如:

硬件架構(gòu)上早期定位就要準(zhǔn),要對(duì)Transformer去做針對(duì)性的優(yōu)化,要想辦法能降低大參數(shù)模型帶寬的使用情況,以及加載的時(shí)候怎么做到更順暢一些。

軟件上,在推理的時(shí)候,則要求做量化、而不是浮點(diǎn)推理,而這就比較需要經(jīng)驗(yàn)。

……

在目前的成果之上,愛(ài)芯元智AX650N也還有很多迭代要做,比如怎么讓硬件對(duì)離散數(shù)據(jù)擁有比較高效的讀取能力,并且配套的計(jì)算還要跟上新的讀取速度,以及對(duì)網(wǎng)絡(luò)稀疏化、MOE(Mixture of Experts)、硬件底層低比特優(yōu)化等方面的工作。

關(guān)于愛(ài)芯元智

愛(ài)芯元智成立于2019年5月,是一家人工智能視覺(jué)感知芯片研發(fā)及基礎(chǔ)算力平臺(tái)公司。

創(chuàng)始人、董事長(zhǎng)兼CEO仇肖莘本碩畢業(yè)于清華大學(xué)自動(dòng)化專業(yè),博士畢業(yè)于美國(guó)南加州大學(xué)電子工程專業(yè)。在創(chuàng)立愛(ài)芯元智前,她先后擔(dān)任了美國(guó)博通公司副總裁和紫光展銳CTO。

去年,愛(ài)芯元智宣布完成8億元A++輪融資,投資方包括騰訊、美團(tuán)等公司。加上之前的三輪,公司融資總金額已接近20億元人民幣。

截至目前,愛(ài)芯元智也成功研發(fā)并量產(chǎn)了三代多顆端側(cè)、邊緣側(cè)智能視覺(jué)感知芯片,據(jù)稱所有芯片產(chǎn)品均具備低功耗優(yōu)勢(shì)及優(yōu)異的圖像處理能力,應(yīng)用于智能城市、智能交通、智慧制造等領(lǐng)域。

One More Thing

愛(ài)芯元智基于AX650N推出的愛(ài)芯派pro開(kāi)發(fā)板(類似于樹(shù)莓派)即將上線某寶,相關(guān)教程和工具也可以在GitHub找到。

對(duì)Transformer深度研究有需求的伙伴,可以去“整活”啦。

友情鏈接:

[1]https://mp.weixin.qq.com/s/csuIyfvFXPPVX8wdkQ0yOg

[2]https://mp.weixin.qq.com/s/K_RpTAX97jz2Rpk3BpGrGw

[3]https://mp.weixin.qq.com/s/vqtA9czTaYk7kJTPS3Zc4Q

- 北大開(kāi)源最強(qiáng)aiXcoder-7B代碼大模型!聚焦真實(shí)開(kāi)發(fā)場(chǎng)景,專為企業(yè)私有部署設(shè)計(jì)2024-04-09

- 剛剛,圖靈獎(jiǎng)揭曉!史上首位數(shù)學(xué)和計(jì)算機(jī)最高獎(jiǎng)“雙料王”出現(xiàn)了2024-04-10

- 8.3K Stars!《多模態(tài)大語(yǔ)言模型綜述》重大升級(jí)2024-04-10

- 谷歌最強(qiáng)大模型免費(fèi)開(kāi)放了!長(zhǎng)音頻理解功能獨(dú)一份,100萬(wàn)上下文敞開(kāi)用2024-04-10