在線可玩!智譜開源圖生視頻模型,網友直呼Amazing!

網友:Amazing!

叨樂 發自 凹非寺

量子位 | 公眾號 QbitAI

剛剛,智譜把清影背后的圖生視頻模型CogVideoX-5B-I2V給開源了!(在線可玩)

一起開源的還有它的標注模型cogvlm2-llama3-caption。

在實際應用中,CogVideoX-5B-I2V支持「一張圖」+「提示詞」生成視頻。

而cogvlm2-llama3-caption則是負責將視頻內容轉換成文本描述。

不過用過的網友卻對它的表現褒貶不一:

有人在用過之后直呼Amazing。

也有人試了半天,最后還是選擇了CogVideoX之前的版本,還夸夸說:我最看好這個型號!

所以到底效果如何,咱們來實測一波!

實測CogVideoX-5B-I2V

測試開始~輸入提示詞:咖啡店員握住雙手笑著對客人表示歡迎,說話時身體自然活動(依舊是老生常談的“手部”問題)

第二次實測,試了一下簡短提示詞:嗎嘍顛著二郎腿打電話(效果不理想,主體還是靜態的沒有動起來)

第三次的提示詞是:“明月圓圓,幾個人坐在河邊談心說話,舉杯高歌。”顯示生成完成,但是到最后顯示環節卻直接NAN了(嗚嗚嗚)

整體效果有些一言難盡,而且生成速度有些慢。

咱們還是來看一下團隊自己發布的一些成功作品吧:

提示詞:當萬花筒般的蝴蝶在花朵中翩翩起舞時,花園變得生機勃勃,它們精致的翅膀在下面的花瓣上投下陰影。

提示詞:一位穿著西裝的宇航員,靴子上沾滿了火星的紅色塵埃,在第四顆行星的粉紅色天空下,他伸出手與一個外星人握手

提示詞:湖岸邊長滿了柳樹,細長的枝條在微風中輕輕搖曳。平靜的湖面倒映著清澈的藍天,幾只優雅的天鵝在平靜的水面上優雅地滑翔

論文也已公開

值得一提的是,目前CogVideoX-5B-I2V模型的代碼均已開源,支持在抱抱臉中進行部署。

相關研究論文也已公開,縱觀論文內容,有三大技術亮點值得說道說道~

首先便是團隊自研了一個高效的三維變分自編碼器結構(3D VAE),將原視頻空間壓縮至2%大小,大大減少了視頻擴散生成模型的訓練成本及訓練難度。

模型結構包括編碼器、解碼器和潛在空間正則化器,通過四個階段的下采樣和上采樣實現壓縮。時間因果卷積確保了信息的因果性,減少了通信開銷。團隊采用上下文并行技術以適應大規模視頻處理。

在實驗中,團隊發現大分辨率編碼易于泛化,而增加幀數則挑戰較大。

因此,團隊分兩階段訓練模型:首先在較低幀率和小批量上訓練,然后通過上下文并行在更高幀率上進行微調。訓練損失函數結合了L2損失、LPIPS感知損失和3D判別器的GAN損失。

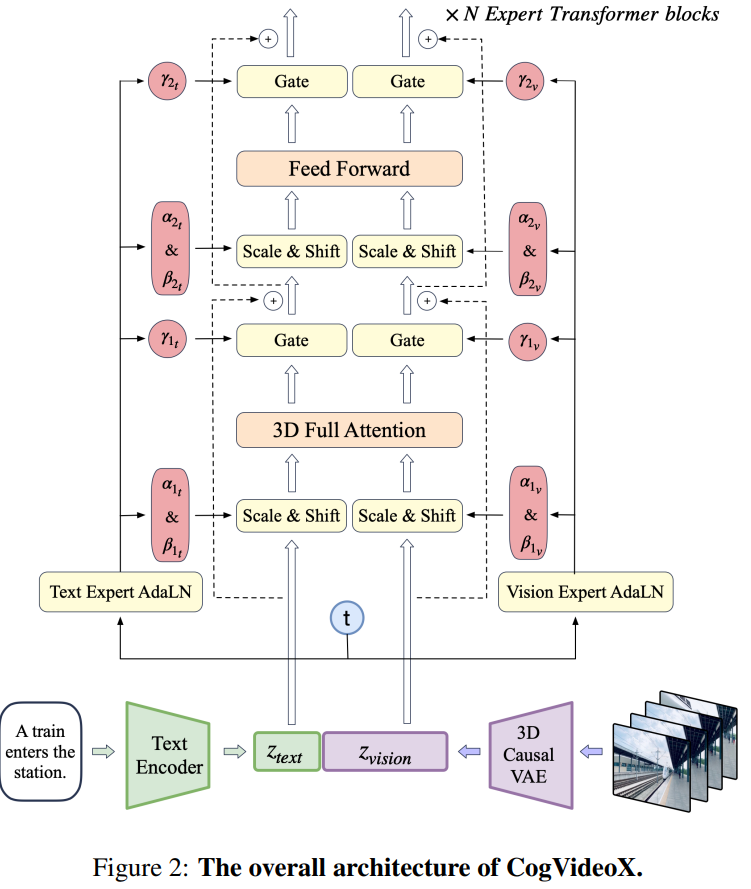

其次是專家Transformer。

團隊使用VAE的編碼器將視頻壓縮至潛在空間,然后將潛在空間分割成塊并展開成長的序列嵌入z_vision。

同時,他們使用T5,將文本輸入編碼為文本嵌入z_text,然后將z_text和z_vision沿序列維度拼接。拼接后的嵌入被送入專家Transformer塊堆棧中處理。

最后,團隊反向拼接嵌入來恢復原始潛在空間形狀,并使用VAE進行解碼以重建視頻。

最后的亮點,便是在于數據了。

團隊開發了負面標簽來識別和排除低質量視頻,如過度編輯、運動不連貫、質量低下、講座式、文本主導和屏幕噪音視頻。

通過video-llama訓練的過濾器,他們標注并篩選了20000個視頻數據點。同時,計算光流和美學分數,動態調整閾值,確保生成視頻的質量。

視頻數據通常沒有文本描述,需要轉換為文本描述以供文本到視頻模型訓練。現有的視頻字幕數據集字幕較短,無法全面描述視頻內容。

為此,團隊還提出了一種從圖像字幕生成視頻字幕的管道,并微調端到端的視頻字幕模型以獲得更密集的字幕。

這種方法通過Panda70M模型生成簡短字幕,使用CogView3模型生成密集圖像字幕,然后使用GPT-4模型總結生成最終的短視頻。

他們還微調了一個基于CogVLM2-Video和Llama 3的CogVLM2-Caption模型,使用密集字幕數據進行訓練,以加速視頻字幕生成過程。

One more thing

值得一提的是,CogVideoX近來這一個月也沒有閑著,化身勤更達人碼出了一堆更新!

2024年9月17日,提供了SAT權重的推理和微調代碼和安裝依賴的命令,使用GLM-4優化了提示詞

跳轉鏈接:https://github.com/THUDM/CogVideo/commit/db309f3242d14153127ffaed06a3cf5a74c77062

2024年9月16日,用戶可以利用本地開源模型+FLUX+CogVideoX,實現自動化生成高質量視頻。

跳轉鏈接:https://github.com/THUDM/CogVideo/blob/CogVideoX_dev/tools/llm_flux_cogvideox/llm_flux_cogvideox.py

2024年9月15日,CogVideoX的LoRA微調權重已成功導出,并在diffusers庫中成功通過測試。

跳轉鏈接:https://github.com/THUDM/CogVideo/blob/CogVideoX_dev/sat/README_zh.md

2024年8月29日,在CogVideoX-5B的推理代碼中加入了pipe.enable_sequential_cpu_offload()和pipe.vae.enable_slicing()功能,使顯存占用降至5GB。

2024年8月27日,CogVideoX-2B模型的開源協議已修改為Apache 2.0協議.

當天,智譜AI開源了更大規模的CogVideoX-5B模型,顯著提升了視頻生成的質量與視覺效果。這個模型優化了推理性能,允許用戶在RTX 3060等桌面顯卡上進行推理,降低了硬件的要求。

2024年8月20日,VEnhancer工具已支持對CogVideoX生成的視頻進行增強,提升視頻分辨率和質量。

2024年8月15日,CogVideoX依賴的SwissArmyTransformer庫升級至0.4.12版本,微調不再需要從源代碼安裝該庫。同時,引入了Tied VAE技術以優化生成效果。

而這次CogVideoX-5B-I2V的開源,也代表著CogVideoX系列模型已經支持文生視頻、視頻延長、圖生視頻三種任務。

- 字節AI版小李子一開口:黃風嶺,八百里2024-09-13

- 小心!AI能「看懂」你的唇語,悄悄話不再安全!2024-09-12

- 機器人也會系鞋帶了!斯坦福團隊賦予機器人新技能丨已開源2024-09-11

- 通用端到端OCR模型開源,拒絕多模態大模型降維打擊2024-09-10