港大北航等1bit大模型引熱議,IEEE刊物評“解決AI能源需求”!作者親自解讀在此

量化后模型表現甚至超過全精度

BiLLM團隊 發自 凹非寺

量子位 | 公眾號 QbitAI

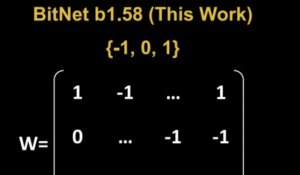

極限量化,把每個參數占用空間壓縮到1.1bit!

IEEE Spectrum專欄,一種名為BiLLM的訓練后量化(PTQ)方法火了。

通俗來講,隨著LLM參數規模越來越大,模型計算的內存和資源也面臨著更大的挑戰。如何把模型變得小巧經濟實惠,能塞進手機等設備中?

BiLLM解決的正是這樣的一個問題。它使用1bit來近似網絡中的大多數參數,使用2bit來表示一些對性能最有影響的權重。

實驗測試中,研究人員對OPT模型、Llama系列進行了二值化。

在OPT模型家族上,BiLLM以1.1bit的平均權重大小實現了目前最極限的LLM訓練后壓縮;在Llama系列模型上,BiLLM在1.08bit下的表現甚至超過了使用全精度的OPT-66B模型。

效率方面,BiLLM能夠在單個GPU上半小時內完成7B LLM的二值化。

BiLLM發布當天,便引發了網友對大模型優化的熱議,有網友就表示:

量化不是沒有代價。Llama3模型的量化效果比Llama2模型要差,量化過程中的質量損失更大。

直覺是,一個訓練不足的模型受到量化的影響較小,因為其訓練過程并沒有充分利用每一個權重。關于Llama的一個關鍵發現,以及它為何能在其大小范圍內表現出色,是因為它們在比文獻中所謂的“最佳”狀態更大的數據集上訓練了更長時間。

綜合這些因素,似乎可以得出以下結論:小型模型、大量數據、長時間訓練>大型模型+量化。基本上,量化是一種用于縮短長時間訓練的損失性的捷徑。數據的數量和質量,一如既往是所有這些中最重要。

這項研究由香港大學、蘇黎世聯邦理工學院、北京航空航天大學聯合推出,目前已被ICML 2024接收。

量子位也聯系到了作者,給大伙兒解讀一下。

LLM權重分布探究

為了應對超低位寬下大語言模型的能力崩潰問題,研究人員對多個預訓練大語言模型的權重和其Hessian矩陣(損失的二階梯度)分布情況進行了初步研究,得到以下觀察:

首先,研究人員發現大語言模型的Hessian矩陣表現出極端的長尾分布特性。

這也意味著大多數位置權重的變化對模型的輸入輸出并不敏感,而少部分元素對于權重的輸出非常敏感。

其次,大語言模型中的權重密度遵循不均勻的鐘形分布形式。

這種鐘形分布在特征方面與高斯分布或拉普拉斯分布非常相似,即大多數權重集中在0附近,整體呈現非均勻的鐘形分布。

上述觀察表明大多數權重在LLM當中是冗余的,而少部分權重發揮著極其重要的作用;同時,在極端的二值化壓縮場景下,這種非均勻鐘形分布會產生更大的量化誤差。

對此,研究人員對少部分顯著權重和大部分非顯著權重分別提出了二階殘差逼近和最優鐘形分組方法進行量化,在1.1bit的權重下首次實現了LLM的性能保證。

△LLM權重分布現象

顯著權重:二階殘差逼近

研究人員發現,顯著權重往往積聚在特定的通道當中。

因此, BiLLM采用一種通道級別的分組方式來區分顯著權重和非顯著權重。這種結構化劃分相比于非結構化處理引入的開銷可以忽略不計,對硬件部署十分友好。

△顯著通道權重二階殘差逼近示意圖

由于顯著權重的重要性,先前工作往往直接將這部分權重保存為原精度或量化到8-bit來保證LLM的性能。然而,這種方式會導致整體位寬的增加。

為此,研究人員開發了一種用二值化殘差逼近方法作用于顯著通道的權重。

這一方法通過直接二值化和殘差二值化有效降低了顯著權重的極端量化誤差。與直接保留顯著權值為16位或者8位相比,該方法僅通過2位開銷存儲顯著權值,同時有效保護了權重中的重要元素。

非顯著權重:最優鐘形劃分

由于顯著通道數量極低,剩余的大部分權重仍然保持著鐘形分布。

同時,在排除顯著權重影響的情況下變得更加對稱。由于二進制量化代表均勻量化的極端形式,直接將鐘形分布下的權重舍入到二值權重會帶來巨大的的量化誤差。

因此研究人員對這部分權重采用了分組二值化的方式,通過自動搜索策略尋找最優的分割點。

此外,研究結果表明,盡管非顯著權重并非理想的高斯分布或拉普拉斯分布,但搜索函數的誤差曲線仍然表現出凸性,證實了最佳分割點的存在。

△非顯著權重分布搜索(左),搜索誤差曲線的凸性(右)

同時由于外側分組的數值方差較大,搜索中總是以較小的比例出現(0.5%~3%)。可以進一步采用稀疏行壓縮的策略來進行分組標識,進一步提升細粒度分組方案下的硬件友好性。

實驗結果

研究團隊在OPT和Llama系列模型上驗證了BiLLM性能。此外,考慮到LLM通常需要基于指令進行微調以適應不同的應用環境,實驗還報告了Vicuna-7B和Vicuna-13B的量化結果。

BiLLM在平均1.1bit權重時,在多個評價指標上實現了超過GPTQ,PB-LLM等方法在2-bit時的性能,同時在部分模型體積上接近3-bit權重的性能。

結果表明, BiLLM 率先在接近1位的平均比特率下實現了LLM性能保證,推動了LLM無訓練量化的邊界。

△opt系列困惑度對比結果

△Llama系列困惑度對比結果

△Zero-Shot評測數據集對比結果

BiLLM在Llama-13B和Vicuna-7B上實現了更好對話效果。

論文鏈接:https://arxiv.org/abs/2402.04291

參考鏈接:

[1]https://spectrum.ieee.org/1-bit-llm

[2]https://news.ycombinator.com/item?id=40529355

- DeepSeek-V3.2-Exp第一時間上線華為云2025-09-29

- 你的AI助手更萬能了!天禧合作字節扣子,解鎖無限新功能2025-09-26

- 你的最快安卓芯片發布了!全面為Agent鋪路2025-09-26

- 任少卿在中科大招生了!碩博都可,推免學生下周一緊急面試2025-09-20