綜藝后期狂喜:編輯一幀,整個視頻跟著變!比LNA渲染快5倍,Adobe聯合出品

尚恩 發自 凹非寺

量子位 | 公眾號 QbitAI

前不久跑男為了讓“kunkun”原地消失,后期只能一幀一幀的摳圖。

現在,只要編輯一幀,整個視頻就跟著變!

就是點點kunkun,整集就自動消失的那種(手動狗頭)。

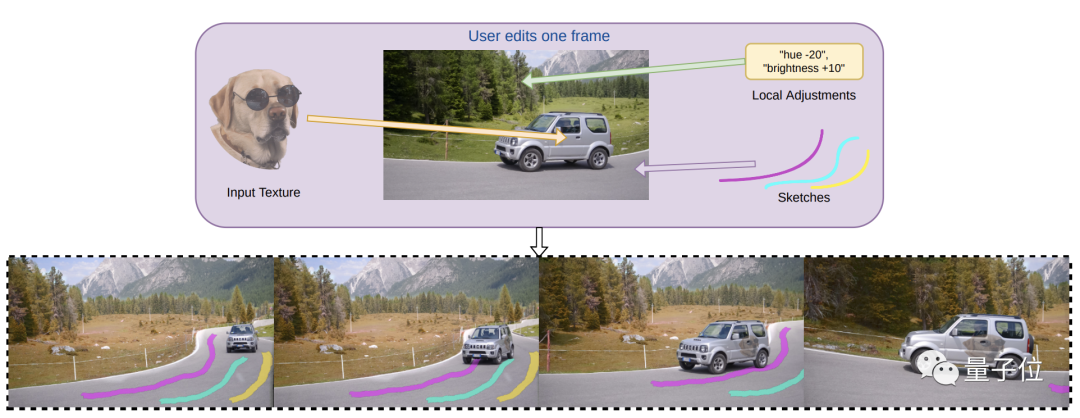

Adobe Research和英屬哥倫比亞大學的研究人員發現,使用INVE(交互式神經視頻編輯),只需在單幀上“畫筆涂鴉”,就能自動應用改動到整個視頻中。

不僅可以編輯視頻中的對象并保留空間和光影關系,甚至可以編輯移動對象的紋理色彩。

網友驚呼:太牛了!

交互式神經視頻編輯

INVE(Interactive Neural Video Editing)是一種實時視頻編輯解決方案。

研究團隊受到分層神經圖集(LNA)的研究啟發。測試發現,通過使用INVE,可以將稀疏幀編輯一致地傳播到整個視頻剪輯,輔助視頻編輯過程。

視頻中的場景通常由非靜態背景和一個或多個前景物體組成,運動軌跡也會不同。

早期的2D方法需要獨立編輯每一幀,并使用幀間跟蹤來協調整個視頻。

假如我們要把這個小狗頭像放在車門上,按照傳統方式,視頻中車是往前移動的,為避免不出現溢出效果,就需要一幀一幀訓練和測試反復編輯。

這種方式費時費力不說,還容易導致明顯的視覺偽影。

而最近發展起來的分層神經圖集(LNA)方法,可以通過一組分層神經網絡2D圖集對單個訓練和測試,達到編輯整個視頻的效果。

雖避免了逐幀編輯,但也有一些問題,比如處理速度較慢、對某些編輯用例支持不足。

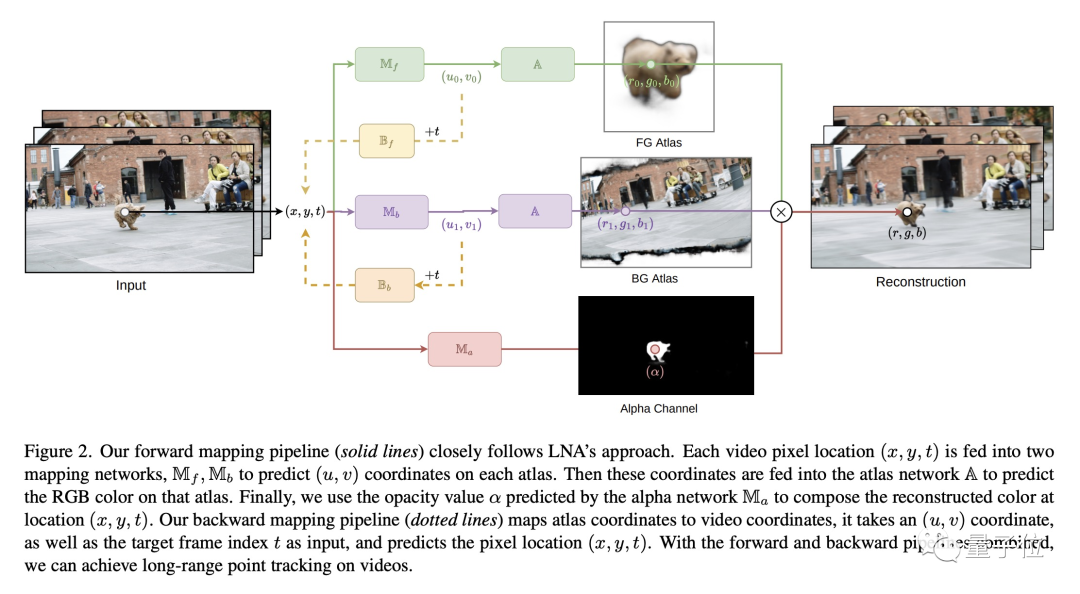

因此,研究團隊基于LNA方法,通過學習圖像圖集和圖像之間的雙向函數映射,并引入矢量化編輯,使得在圖集和圖像中一致編輯成為可能。

同時,采用多分辨率哈希編碼來改善模型的收斂速度。

如何實現

研究團隊基于光流提取算法RAFT,在包含70幀且分辨率為768×432的視頻上訓練和測試模型。

首先,團隊在每個訓練批次中隨機采樣了10,000個視頻像素,然后設定了一個模型參數值。

通過將GPU優化的Fully Fused MLP架構引入,僅迭代大約12,000個次數就完成訓練,相比于LNA的300,000個迭代次數要少得多。

測試顯示該方法在單個NVIDIA RTX 4090 GPU上的渲染速度為24.81 FPS,對比LNA的渲染速度5.34 FPS,渲染速度快了近5倍。

經過相同數量的迭代訓練,團隊模型的重建、流場損失都比LNA更快地收斂。

此外,為實現點跟蹤,團隊選擇逆映射的方法,允許添加跟蹤單個/少數點的剛性紋理。

團隊提出“矢量化素描技術”,將多邊形鏈直接映射到圖集中,更精確地控制線條,從而減少計算成本并避免有視覺偽影。

再通過分層編輯,允許在圖集之上疊加多個可編輯圖層,使每個圖層都可獨立訪問和編輯。

分層編輯支持多種類型的編輯,包括畫筆涂鴉、局部調整、紋理編輯。

比如畫筆涂鴉,就可以直接使用畫筆工具草圖涂鴉。

比如紋理編輯,可以導入外部圖形,跟蹤和變形的運動對象。

研究團隊

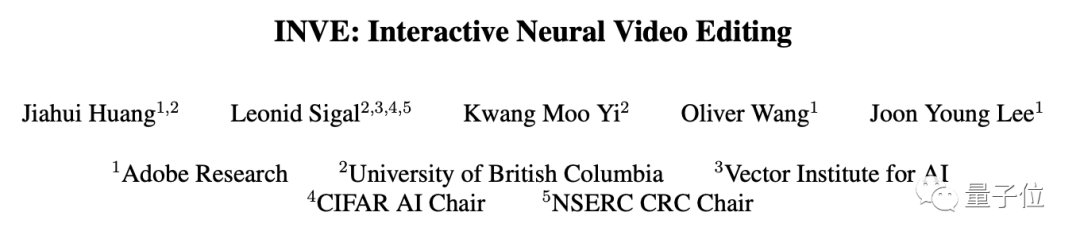

作者團隊由來自Adobe Research、英屬哥倫比亞大學、AI Vector研究所和CIFAR AI組成。

第一作者是Jiahui Huang,目前是Adobe Research的研究工程師,碩士畢業于英屬哥倫比亞大學。

其他作者包括Kwang Moo Yi、Oliver Wang和Joon Young Lee,整個團隊研究方向主要也是在計算機視覺、機器學習和視頻編輯領域。

論文地址已貼,感興趣的可以去看看。

論文傳送門 :

https://arxiv.org/abs/2307.07663

參考鏈接:

[1]https://twitter.com/_akhaliq/status/1681162394393886720/

[2]https://gabriel-huang.github.io/inve/

- 特斯拉CFO突然辭職,未來去向成迷,離任前已拋600萬美元股票2023-08-08

- 韓國LK-99作者發布新視頻,樣本室溫25度懸浮,已有網友估算磁化率2023-08-04

- 馬斯克買下ai.com域名!奧特曼剛砸千萬美元購入,4個月轉手給鋼鐵俠2023-08-03

- 谷歌用大模型重寫超級助手,為推進度先裁員重組!2023-08-01