視頻P圖新SOTA:推理速度快近15倍,任意分辨率均可上演人像消失大法,來自南開大學|CVPR 2022

填補缺失也毫不違和

豐色 發自 凹非寺

量子位 | 公眾號 QbitAI

眾所周知:視頻是可以P的。

這不,在CVPR 2022收錄的論文中,就出現了這么一個P圖神器,它可以分分鐘給你上演各種人像消失大法,不留任何痕跡。

去水印、填補缺失更是不在話下,并且各種分辨率的視頻都能hold住。

正如你所見,這個模型如此絲滑的表現讓它在兩個基準數據集上都實現了SOTA性能。

△ 與SOTA方法的對比

同時它的推理時間和計算復雜表現也很搶眼:

前者比此前的方法快了近15倍,可以在Titan XP GPU上以每幀0.12秒的速度處理432 × 240的視頻;后者則是在所有比較的SOTA方法中實現了最低的FLOPs分數。

如此神器,什么來頭?

改善光流法

目前很多視頻修復算法利用的都是光流法?(Optical flow)。

也就是利用圖像序列中像素在時間域上的變化以及相鄰幀之間的相關性,找到上一幀跟當前幀之間存在的對應關系,從而計算出相鄰幀之間物體的運動信息。

這個方法的缺點很明顯:計算量大、耗時長,也就是效率低。

為此,研究人員設計了三個可訓練模塊,分別為流完成?(flow completion)、特征傳播?(feature propagation)和內容幻想(content hallucination),提出了一個流引導(flow-guided)的端到端視頻修復框架:

E2FGVI。

這三個模塊與之前基于光流的方法的三個階段相對應,不過可以進行聯合優化,從而實現更高效的修復過程。

具體來說,對于流完成模塊,該方法直接在mask viedo中一步完成操作,而不是像此前方法采用多個復雜的步驟。

對于特征傳播模塊,與此前的像素級傳播相比,該方法中的流引導傳播過程在特征空間中借助可變形卷積進行。

通過更多可學習的采樣偏移和特征級操作,傳播模塊釋放了此前不能準確進行流估計的壓力。

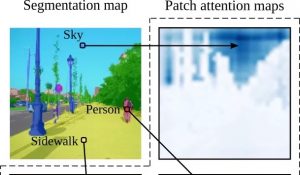

對于內容幻想模塊,研究人員則提出了一種時間焦點Transformer來有效地建模空間和時間維度上的長程依賴關系。

同時該模塊還考慮了局部和非局部時間鄰域,從而獲得更具時間相關性的修復結果。

作者:希望成為新基線

定量實驗:

研究人員在數據集YouTube VOS和DAVIS上進行了定量實驗,將他們的方法與之前的視頻修復方法進行了比較。

如下表所示,E2FGVI在全部四個量化指標上都遠遠超過了這些SOTA算法,能夠生成變形更少(PSNR和SSIM)、視覺上更合理(VFID)和時空一致性更佳(Ewarp)的修復視頻,驗證了該方法的優越性。

此外,E2FGVI也具有最低的FLOPs值(計算復雜度),盡管訓練是在432 × 240分辨率的視頻上進行,它的HQ版本做到了支持任意分辨率。

定性實驗:

研究人員首先選擇了三種最有代表性的方法,包括CAP、FGVC(基于光流法)和Fuseformer(入選ICCV 2021),進行對象移除(下圖前三行)和缺失補全(下圖后兩行)的效果比較。

可以發現,前三種方法很難在遮擋區域恢復出合理的細節、擦除人物也會造成模糊,但E2FGVI可以生成相對真實的紋理和結構信息。

此外,它們還選用了5種方法進行了用戶研究,結果大部分人都對E2FGVI修復后的效果更滿意。

綜上,研究人員也表示,希望他們提出的方法可以成為視頻修復領域新的強大基線。

作者介紹

E2FGVI由南開大學和海思合作完成。

一作Li Zhen為南開大學博士生,共同一作Lu ChengZe也來自南開。

通訊作者為南開大學計算機學院教授程明明,主要研究方向是計算機視覺和圖形學。

目前,E2FGVI的代碼已經開源,作者也提供了Colab實現,未來還將在Hugging Face給出demo。

論文地址:

https://arxiv.org/abs/2204.02663

GitHub主頁:

https://github.com/MCG-NKU/E2FGVI

- 北大開源最強aiXcoder-7B代碼大模型!聚焦真實開發場景,專為企業私有部署設計2024-04-09

- 剛剛,圖靈獎揭曉!史上首位數學和計算機最高獎“雙料王”出現了2024-04-10

- 8.3K Stars!《多模態大語言模型綜述》重大升級2024-04-10

- 谷歌最強大模型免費開放了!長音頻理解功能獨一份,100萬上下文敞開用2024-04-10