CVPR 2022:微笑識別也帶性別歧視?浙大武大聯合螞蟻Adobe搞了個公平性提升框架

無須改變已部署模型

作者:董小威

武漢大學

AI模型存在偏見怎么辦?

近年來,AI在多個領域展現出卓越的性能,給人類生活帶來便捷和改善。

與此同時,不少AI系統被發現存在對特定群體的偏見或者歧視現象。

犯罪預測系統COMPAS在美國被廣泛使用,通過預測再次犯罪的可能性來指導判刑。

研究者發現,相比于白人,黑人被預測為高暴力犯罪風險的可能性竟然高77%。這里就存在一個嚴肅的問題:犯罪與否難道能由膚色來決定?

我們經常使用的搜索引擎也普遍存在偏見。如果搜索“護士”的圖片,返回的結果中大部分都是女性。

亞馬遜的員工招聘系統,被曝出傾向于給男性打高分,給女性打低分。

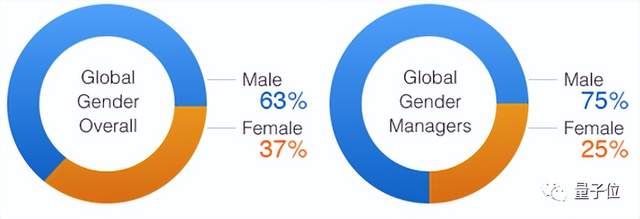

為什么AI系統存在偏見?它是如何學會的?多半是數據教會了它。

例如,在亞馬遜的雇員數據中,男性遠多于女性,導致AI學到了性別和錄用間的虛假關聯,誤以為男性更有資格被錄用。

針對這一問題,研究者提出了多種公平性提升方案,但它們本質上都要修改已部署的深度學習模型。

“如果已部署上線的深度學習模型存在偏見,如何在不修改模型的情況下提升公平性呢?”浙江大學王志波教授提出了這個問題。

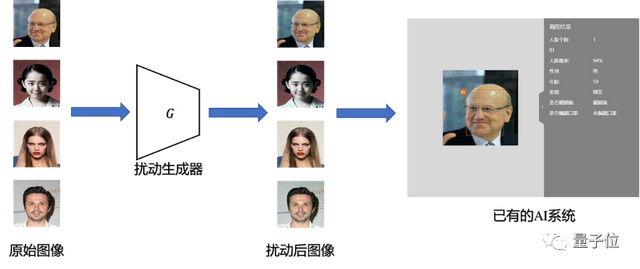

針對該問題,浙大王志波和任奎團隊聯合武漢大學、螞蟻集團與Adobe公司,提出了一種基于對抗性擾動的深度學習模型公平性提升方案,在無須改變已部署模型的情況下提升系統的公平性。

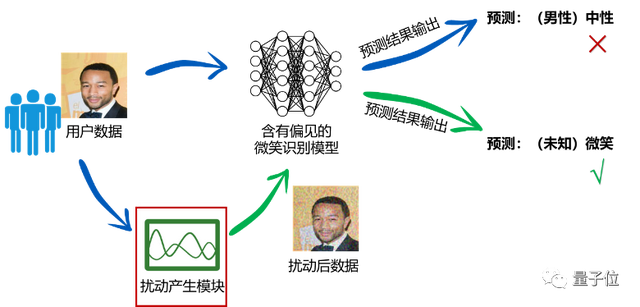

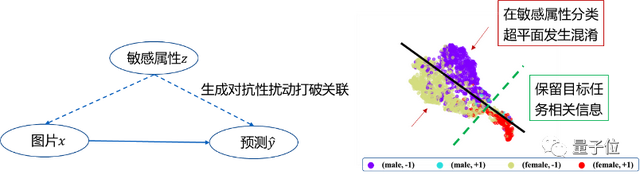

該方案的基本思想是:通過自適應地對輸入數據添加對抗性擾動,阻止模型提取出敏感屬性相關信息,保留目標任務相關信息,從而使得模型公平地對待不同敏感屬性的群體,給出公平的預測結果。

公平性提升方案FAAP

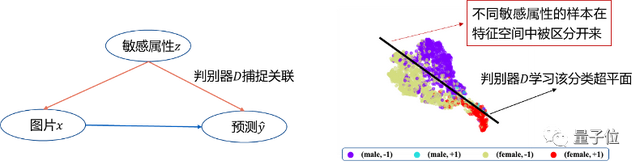

FAAP框架包含已部署的模型、擾動生成器和判別器三個部分:

首先,用擾動生成器對圖像添加對抗性擾動,擾動后的圖像會輸入到部署模型的特征提取器,獲得圖像的隱空間表示,并分別輸入到標簽預測器和判別器。

接著衡量擾動后的圖像中包含的敏感屬性的信息,訓練判別器從隱空間表示中預測敏感屬性,并對判別器進行更新。

之后對擾動生成器進行更新,欺騙判別器,使擾動后的圖像在隱空間表示中不包含敏感屬性的信息,同時使標簽預測器的預測結果準確。

對以上步驟進行迭代,獲得最終的擾動生成器,作為數據預處理單元,為已有的AI系統提升公平性。

模型預測真的變公平了嗎?

通過觀察注意力顯著圖可以發現,有性別偏見的微笑識別模型,會關注于原始圖像的頭發區域,不可避免地使用性別相關特征進行預測。相比之下,該方案可以讓模型更關注于圖像嘴部區域,從而不受敏感屬性的影響,做出公平的預測:

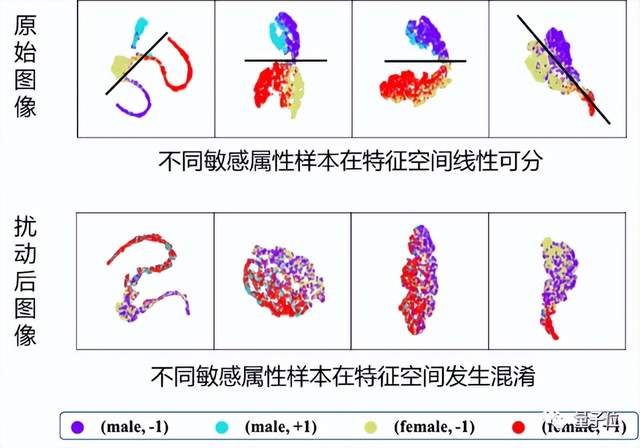

使用T-SNE處理模型特征空間的輸出,可以發現,帶有性別偏見的模型,在特征空間能分辨出原始圖像中不同性別的樣本,因而區別對待不同性別的人群。相比之下,該方案讓具有不同敏感屬性的樣本在特征空間發生混淆,使得它們被模型公平對待:

該項研究首次考慮在不改變深度學習模型的前提下提升公平性,提出的方案更貼合真實應用場景。

對于一般的部署模型,在基本不影響準確率的情況下,該方案可以大幅提升公平性,例如,在公平性指標DP和DEO上平均能夠獲得27.5%和66.1%的提升。

目前,該研究成果的相關論文“Fairness-aware Adversarial Perturbation Towards Bias Mitigation for Deployed Deep Models”已被CVPR 2022錄用。

論文地址:

https://arxiv.org/abs/2203.01584

- 空間智能卡脖子難題被杭州攻克!難倒GPT-5后,六小龍企業出手了2025-08-28

- 陳丹琦有了個公司郵箱,北大翁荔同款2025-08-28

- 英偉達最新芯片B30A曝光2025-08-20

- AI應用如何落地政企?首先不要卷通用大模型2025-08-12