5分鐘端側部署視覺大模型!專為Transformer優化的AI芯片來了

性能可達361 FPS

豐色 發自 凹非寺

量子位 | 公眾號 QbitAI

有沒有人好奇:

大模型那么香,我們將它從云側拿到端側開發應用,比如讓每臺手機都標配一個大模型,豈不是更香?

——我們還沒實現這個愿望,當然不是因為不想,是不能。

由于芯片架構不同,在端側部署時往往需要開發人員對模型網絡結構進行一通修改才能勉強“上車”,但改完之后性能難保證,更別提功耗、成本等一系列本就存在的問題了。

不過現在,一款號稱現實開源模型直接拿來用,還能讓性能、功耗與自動駕駛領域基于GPU的端側芯片有得一拼的平臺誕生了。

它叫AX650N,來自愛芯元智,對Transformer架構支持效果尤甚。

Transformer不用多說,它是當下最火的ChatGPT、Stable Diffusion等大模型背后的基礎架構。

那么具體效果如何?咱這就展開參數一一來看。

5分鐘就能完成原版Swin Transformer端側部署

AX650N是AI芯片公司愛芯元智發布的第三代端側芯片。

其構成包括CPU和NPU等,其中CPU采用的是八核A55處理器,NPU則采用了自研混合精度技術,可以做到43.2TOPs(INT4)或10.8TOPs(INT8)的高算力。

AX650N主要用于端側視覺感知。

目前在該領域,業界主要還是基于CNN網絡開發應用。

相反,準確率和性能雙佳的Swin Transformer并沒有得到突出的大規模落地,還是多部署于云端服務器。

愛芯元智表示,這是因為GPU對于MHA結構(Transformer中的多頭注意力機制)計算支持更友好。

而目前的大部分端側AI芯片由于其架構限制為了保證CNN結構的模型效率更好,基本上對MHA結構沒有過多性能優化,因此我們需要修改Swin Transformer的網絡結構才能勉強將其部署在端側——

一旦修改網絡結構,就意味著將出現一系列問題,例如精度下降,精度一降就得對模型進行重訓,這個過程就要以星期甚至是月來計算了。

愛芯元智聯合創始人、副總裁劉建偉介紹:

用AX650N在端側部署原版Swin Transformer,從拿到測試板到demo復現,只需要5分鐘,再到在自己的私有環境里跑起來私有模型,只要1個小時就能搞定。

——不僅能跑起來,還跑得飛快、性能高且功耗低。

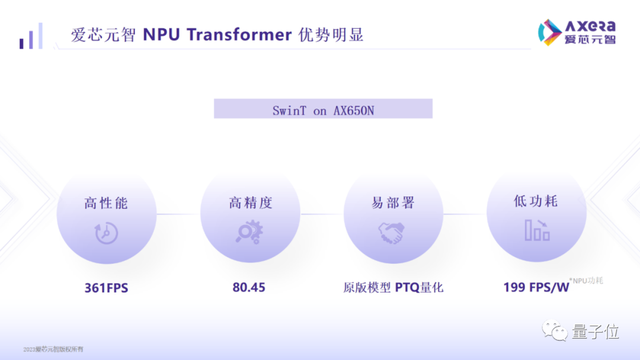

具體而言,AX650N端側部署Swin Transformer性能可達361 FPS。

這是什么概念?

某知名芯片商開發的基于GPU的高端域控SoC,用于自動駕駛領域,跑的也是400幀以內的一個數字。AX650N基本可與之相媲美了。

不僅性能高,AX650N還能保證準確率,做到高于市場水平的80.45%精度。

與此同時,功耗也非常低,即能效非常高,它可以跑到199 FPS/W,是上面提到的基于GPU的高端域控SoC的數倍(該芯片整體TDP大約是15到60W,實測增量功耗20多W,合下來大約是20 FPS/W)。

除了這些優勢,AX650N還支持低比特混合精度,遇到大規模參數的模型,我們就可以采用INT4來減少內存和帶寬占用率,從而降低大模型在端側邊緣側部署的成本。

基于此,愛芯元智表示,AX650N可以說是成為了目前對Transformer架構支持最好的一個端側部署平臺。

對了,除了上面的Swin Transformer,AX650N還適配ViT/DeiT、DETR在內的Transformer模型,Meta最新發布的視覺模型DINOv2也達到了30幀以上的運行結果。

因此,有了AX650N,我們在下游進行檢測、分類、分割等操作也更加方便。

據悉,接下來,愛芯元智AX650N將會針對Transformer結構進行進一步優化,并且將探索多模態方向的Transformer模型。

Ps. Swin Transformer以及DETR和EfficientViT的具體部署方法,愛芯元智官方提供了詳細教程,這里就不再贅述,大家戳文末鏈接即可查看~

△Swin Transformer性能實測,3.6Tops都能跑100多幀

邊緣側、端側部署大模型,是趨勢

再回到大模型本身這個話題,大家有沒有思考過它的蓬勃發展究竟會給我們帶來什么?

奇績創壇CEO陸奇博士在最近的一場演講中提到:

當年他剛從CMU畢業時,買一張地圖需要3美元,現在咱們只需要在網上花費300毫秒就能搜到一張,信息獲取的成本已接近免費。

愛芯元智相關負責人就表示,大模型從某種程度上會重復如上故事,也就是說,我們可以暢想以后打開手機或者其他終端,就能獲得一個諸如私人醫生和律師、廚師的AI助理,它無所不知無所不曉,為我們提供成本非常低廉的咨詢等服務。

另一方面,比如智能音箱,如果能夠在本地用上大模型,它就能做一些真正稱得上是智能的交互,而不是只會提取關鍵詞。

為了實現諸如這樣的愿望,大模型部署就不會只局限于云端。

△圖源愛芯元智官網

“而從量的角度來講,邊緣側、端側的需求一定比云側更大,畢竟邊緣側、端側設備會更多。”

像我們今天講的Transformer端側部署,“但凡是會用到攝像頭的業務,都會對它感興趣。”

愛芯元智介紹,相比CNN網絡,在端側部署Transformer最大的好處之一就是可以解決以前長尾場景下,AI智能投入太高的問題。

比如河道垃圾監測,用CNN等網絡,可能出現一類新的垃圾就得花數月去重新采集數據進行訓練,不然系統就認不出來。

而基于Transformer的視覺大模型,采用無監督學習的方式進行了訓練,遇到新的就能直接識別(也就是zero-shot或者one-shot能力),可以省去很大的時間和訓練成本。

不過要開發可以讓Transformer模型輕松又高效地在端側跑起來的平臺,要面對的困難并不少。

例如:

硬件架構上早期定位就要準,要對Transformer去做針對性的優化,要想辦法能降低大參數模型帶寬的使用情況,以及加載的時候怎么做到更順暢一些。

軟件上,在推理的時候,則要求做量化、而不是浮點推理,而這就比較需要經驗。

……

在目前的成果之上,愛芯元智AX650N也還有很多迭代要做,比如怎么讓硬件對離散數據擁有比較高效的讀取能力,并且配套的計算還要跟上新的讀取速度,以及對網絡稀疏化、MOE(Mixture of Experts)、硬件底層低比特優化等方面的工作。

關于愛芯元智

愛芯元智成立于2019年5月,是一家人工智能視覺感知芯片研發及基礎算力平臺公司。

創始人、董事長兼CEO仇肖莘本碩畢業于清華大學自動化專業,博士畢業于美國南加州大學電子工程專業。在創立愛芯元智前,她先后擔任了美國博通公司副總裁和紫光展銳CTO。

去年,愛芯元智宣布完成8億元A++輪融資,投資方包括騰訊、美團等公司。加上之前的三輪,公司融資總金額已接近20億元人民幣。

截至目前,愛芯元智也成功研發并量產了三代多顆端側、邊緣側智能視覺感知芯片,據稱所有芯片產品均具備低功耗優勢及優異的圖像處理能力,應用于智能城市、智能交通、智慧制造等領域。

One More Thing

愛芯元智基于AX650N推出的愛芯派pro開發板(類似于樹莓派)即將上線某寶,相關教程和工具也可以在GitHub找到。

對Transformer深度研究有需求的伙伴,可以去“整活”啦。

友情鏈接:

[1]https://mp.weixin.qq.com/s/csuIyfvFXPPVX8wdkQ0yOg

[2]https://mp.weixin.qq.com/s/K_RpTAX97jz2Rpk3BpGrGw

[3]https://mp.weixin.qq.com/s/vqtA9czTaYk7kJTPS3Zc4Q

- 北大開源最強aiXcoder-7B代碼大模型!聚焦真實開發場景,專為企業私有部署設計2024-04-09

- 剛剛,圖靈獎揭曉!史上首位數學和計算機最高獎“雙料王”出現了2024-04-10

- 8.3K Stars!《多模態大語言模型綜述》重大升級2024-04-10

- 谷歌最強大模型免費開放了!長音頻理解功能獨一份,100萬上下文敞開用2024-04-10