arXiv爆款:想了解Attention就看它!清華計圖胡事民團隊出品

引用上百篇文獻,GitHub推特雙雙300+熱度

博雯 發自 凹非寺

量子位 報道 | 公眾號 QbitAI

清華計圖胡事民團隊的這篇注意力機制的綜述火了!

在上周的arXiv上,這是最熱的一篇論文:

推特以及GitHub上也有不低的熱度:

而這篇論文引用近200篇內容,對計算機視覺領域中的各種注意力機制進行了全面回顧。

在大量調查之后,論文將注意力機制分為多個類別,GitHub還給出了各類別下提到內容的PDF下載文件:

現在,就來一起看看這篇論文。

文章主要內容

論文首先將基于注意力的模型在計算機視覺領域中的發展歷程大致歸為了四個階段:

- 將深度神經網絡與注意力機制相結合,代表性方法為RAM

- 明確預測判別性輸入特征,代表性方法為STN

- 隱性且自適應地預測潛在的關鍵特征,代表方法為SENet

- 自注意力機制

同時,注意力機制也被分為了通道注意、空間注意、時間注意、分支注意,以及兩個混合類別:

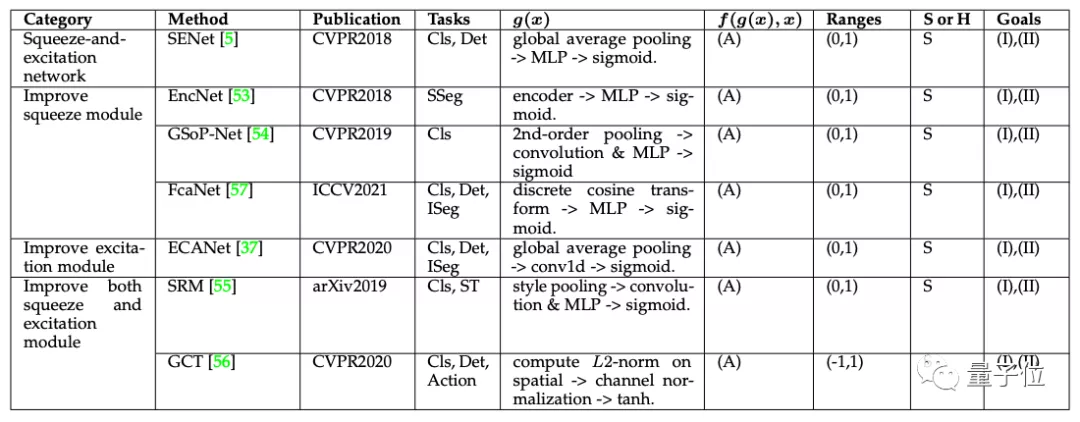

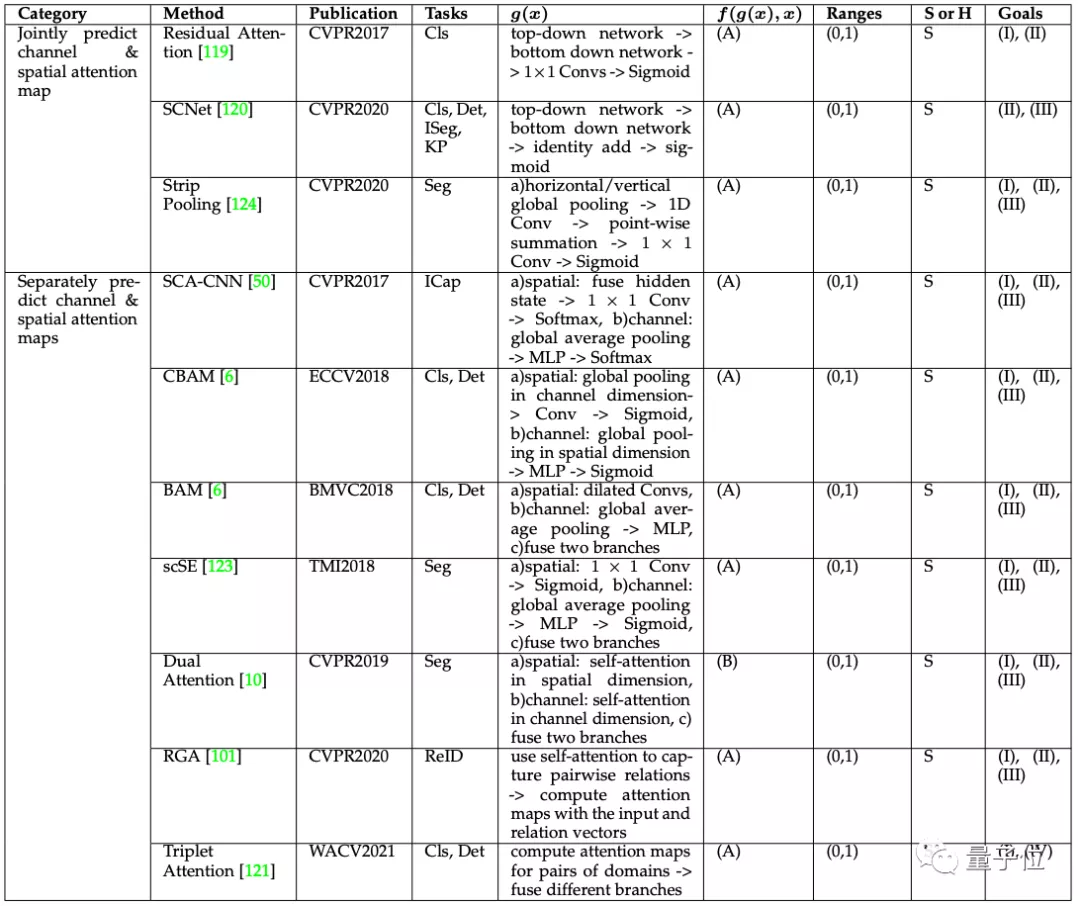

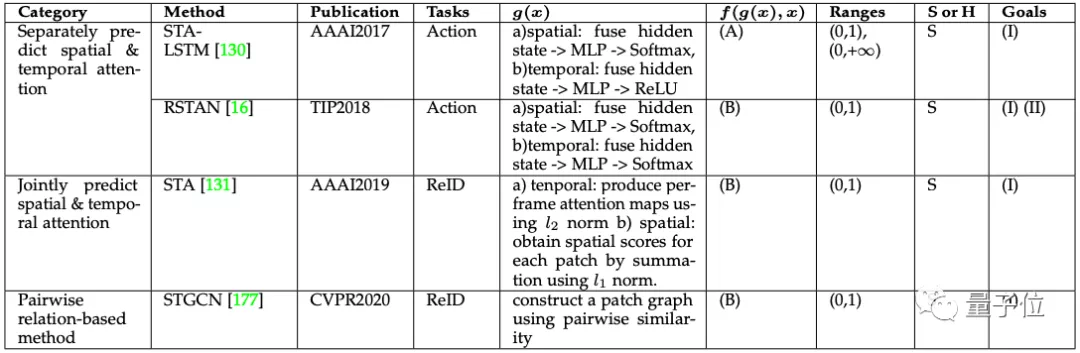

針對不同類別,研究團隊給出了其代表性方法和發展背景:

通道注意力(Channel Attention)

在深度神經網絡中,不同特征圖的不同通道常代表不同對象。

而通道注意力作為一個對象選擇過程,可以自適應地重新校準每個通道的權重,從而決定關注什么。

因此,按照類別和出版日期將代表性通道關注機制進行分類,應用范圍有分類(Cls)、語義分割(SSeg)、實例分割(ISeg)、風格轉換(ST)、動作識別(Action)。

其中,(A)代表Channel-wise product,(I)強調重要通道,(II)捕捉全局信息。

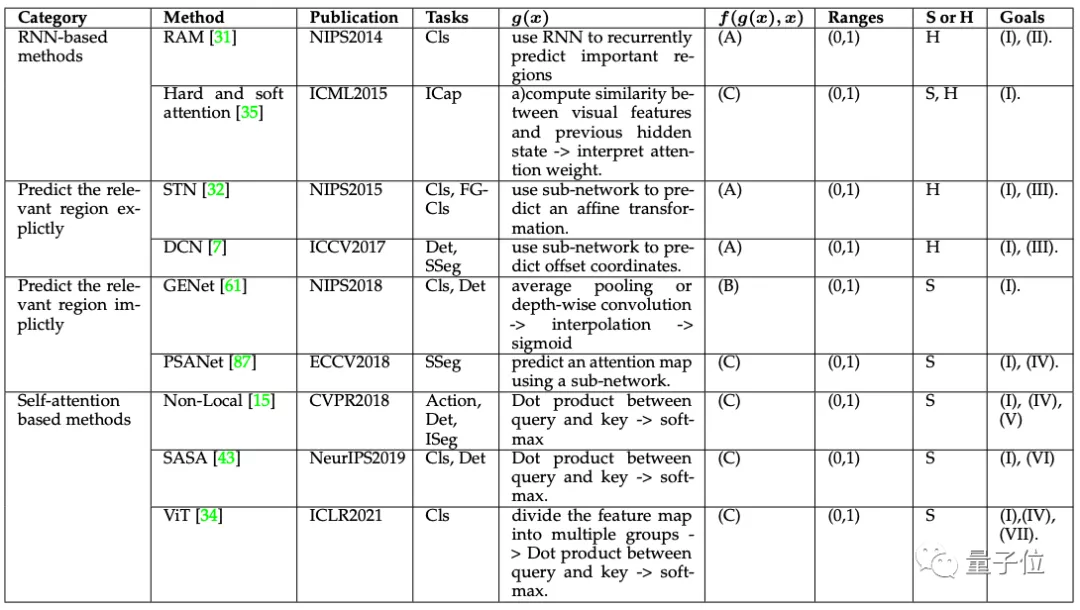

空間注意力(Spatial Attention)

空間注意力可以被看作是一種自適應的空間區域選擇機制。

其應用范圍比通道注意力多出了精細分類(FGCls)和圖像字幕(ICap)。

時間注意力(Temporal Attention)

時間注意力可以被看作是一種動態的時間選擇機制,決定了何時進行注意,因此通常用于視頻處理。

分支注意力(Branch Attention)

分支注意可以被看作是一種動態的分支選擇機制,通過多分支結構決定去注意什么。

通道空間注意力(Channel & Spatial Attention)

通道和空間結合的注意力機制可以自適應地選擇重要的對象和區域,由殘差注意力(Residual Attention)網絡開創了這一內容。

在殘差注意力之后,為了有效利用全局信息,后來的工作又相繼引入全局平均池化(Global Average Pooling),引入自注意力機制等內容。

時空注意力(Spatial & Temporal Attention)

時空注意力機制可以自適應地選擇重要區域和關鍵幀。

最后,作者也提出了注意力機制在未來的一些研究方向:

- 探索注意力機制的必要和充分條件

- 是否可以有一個通用的注意塊,可以根據具體的任務在各類注意力機制之間進行選擇

- 開發可定性和可解釋的注意力模型

- 注意力機制可以產生稀疏的激活,這促使我們去探索哪種架構可以更好地模擬人類的視覺系統

- 進一步探索基于注意力的預訓練模型

- 為注意力模型研究新的優化方法

- 找到簡單、高效、有效的基于注意力的模型,使其可以廣泛部署

關于作者

這篇論文來自清華大學計算機系胡事民團隊。

胡事民為清華大學計算機系教授,教育部長江學者特聘教授,曾經和現任IEEE、Elsevier、Springer等多個期刊的主編、副主編和編委。

同時,他也是清華“計圖”框架團隊的負責人,這是首個由中國高校開源的深度學習框架。

文章一作為胡事民教授的博士生國孟昊,現就讀于清華大學計算機系,也是清華計圖團隊的一員。

各類資源匯總鏈接:

https://github.com/MenghaoGuo/Awesome-Vision-Attentions

論文地址:

https://arXiv.org/abs/2111.07624

- 有道智能學習燈發布,通過“桌面學習分析引擎”實現全球最快指尖查詞2022-04-08

- 科學證明:狗勾真的懂你有多累,聽到聲音0.25秒后就知道你是誰,對人比對狗更親近2022-04-14

- 在M1芯片上跑原生Linux:編譯速度比macOS還快40%2022-04-05

- 小學生們在B站講算法,網友:我只會阿巴阿巴2022-03-28