視頻上下文學(xué)習(xí)!大模型學(xué)會“照貓畫虎”生成,結(jié)合模擬器還能精準(zhǔn)控制真實環(huán)境交互,來自MSRA

模型與現(xiàn)實世界的交互變得更多樣

Vid-ICL團(tuán)隊 投稿

量子位 | 公眾號 QbitAI

視頻生成也能參考“上下文”?!

MSRA提出視頻上下文學(xué)習(xí)(Video In-Context Learning, Vid-ICL),讓大模型學(xué)會“照貓畫虎”式模仿生成。

Vid-ICL通過一段示例視頻來指導(dǎo)模型在新場景下的生成,使得生成結(jié)果可以在新場景下“模仿”示例視頻中完成的任務(wù)。

比如,示例視頻鏡頭視角向下移動(左),生成視頻同樣視角向下移動(右):

示例視頻物體向上移動(左),生成視頻同樣向上移動(右):

物體抓取也能模仿:

△左:示例視頻,機(jī)械臂抓取物體;右:生成視頻

打開抽屜也可以按示例進(jìn)行:

△左:示例視頻,打開中間的抽屜;右:生成視頻

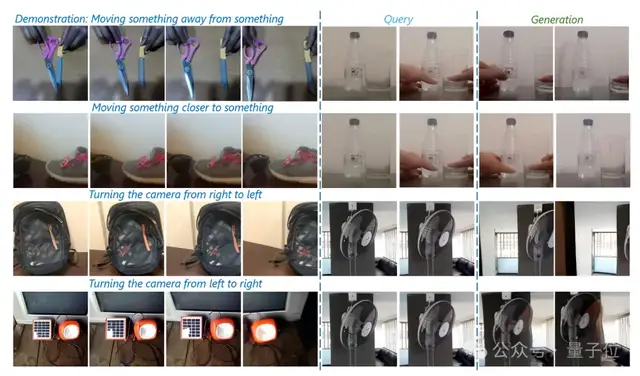

在相同的電風(fēng)扇場景下,用不同示例視頻指導(dǎo)模型生成效果belike:

△左:示例視頻,鏡頭左移;右:生成視頻

△左:示例視頻,鏡頭右移;右:生成視頻

要知道,在一個理想的世界模型中,模型與外界環(huán)境的交互應(yīng)當(dāng)是多樣的。而大部分現(xiàn)有工作都聚焦在用文本作為主要的交互方式,這使得對生成結(jié)果細(xì)節(jié)和多樣性的控制變得困難。

而視頻是高度具象且通用的,能夠傳遞廣泛的信息如完成各種任務(wù)的示例,包括移動或抓取對象等。

研究團(tuán)隊提出的Vid-ICL方法提供了語言和圖像之外的一個新的接口,使模型與現(xiàn)實世界的交互變得更為多樣。

除了上面展示的生成視頻之外,Vid-ICL也可以與模擬器結(jié)合,用生成視頻和當(dāng)前狀態(tài)來預(yù)測與環(huán)境正確交互的相應(yīng)動作,從而實現(xiàn)與真實環(huán)境的交互。

下圖中展示了Vid-ICL與真實環(huán)境交互,從t=0時的狀態(tài)開始,與RoboDesk模擬器交互完成“Push_red”任務(wù)。Vid-ICL對環(huán)境交互提供了更精確的控制:

好家伙,電影《鐵甲鋼拳》照進(jìn)現(xiàn)實了。

Vid-ICL究竟是如何做到的?

Vid-ICL框架解讀

Vid-ICL以視頻為基本單元進(jìn)行運(yùn)作。

具體而言,給定一個查詢視頻片段和k個示例視頻片段,Vid-ICL的目標(biāo)是生成一個視頻片段,該視頻片段應(yīng)首先保持與查詢視頻片段在感知上的連貫性,同時在語義(如鏡頭移動、動作)上與示例視頻一致。

- 自回歸模型訓(xùn)練

Vid-ICL采用Transformer作為模型結(jié)構(gòu)。

Transformer作為文本大模型的基座架構(gòu),在語言的上下文推理、生成任務(wù)上展現(xiàn)了強(qiáng)大的能力。視覺信息的生成式Transformer訓(xùn)練包括兩個階段:

第一,訓(xùn)練視覺編碼器,如 VQ-VAE,將每個圖像轉(zhuǎn)換為離散Token;

第二,每個訓(xùn)練樣本被構(gòu)建為Token序列,Transformer解碼器的目標(biāo)是恢復(fù)該Token序列。

具體實現(xiàn)上,Vid-ICL采用Llama架構(gòu),利用RMSNorm歸一化和旋轉(zhuǎn)位置嵌入(RoPE),以自回歸方式訓(xùn)練 Transformer解碼器。在訓(xùn)練階段,每個序列是從一個原始視頻中采樣的,沒有拼接來自不同視頻的視頻片段。

- 零樣本能力

研究團(tuán)隊在本文中提到一個關(guān)鍵的觀察:

模型可以從沒有顯式上下文形式的視頻數(shù)據(jù),即連續(xù)視頻片段中自發(fā)地學(xué)習(xí)出上下文推理能力,即對于Video In-context Learning的“零樣本能力”。

這可以歸因于兩個關(guān)鍵因素。首先,每個視頻幀之間沒有插入特殊的分隔符,這允許模型在訓(xùn)練期間,將連續(xù)的視頻序列隱式地視為示例視頻+查詢視頻的格式。這意味著模型已經(jīng)學(xué)會了處理類似示例-查詢結(jié)構(gòu)的序列。

其次,Transformer的自回歸特性使其能夠?qū)我粓鼍暗囊曨l序列預(yù)測能力拓展到示例和query來自不同視頻的場景,將文本上下文學(xué)習(xí)的范式無縫地泛化到視頻上下文學(xué)習(xí)上。

- 融合其他模態(tài)

雖然Vid-ICL主要關(guān)注視頻作為示例,但是可以擴(kuò)展到其他模態(tài)如文本上。

為此,只需通過預(yù)訓(xùn)練的語言模型將原始文本描述轉(zhuǎn)換為潛在表示,然后在訓(xùn)練Transformer以及進(jìn)行上下文推理時將該潛在表示作為前綴,通過投影層對齊到Transformer的隱空間內(nèi)。

實驗表明,Vid-ICL可以同時接收文本和視頻作為示例,并且加入文本可以進(jìn)一步增強(qiáng)生成結(jié)果的質(zhì)量。

- 數(shù)據(jù)與模型大小

可以看到,Vid-ICL可以學(xué)習(xí)到示例視頻中包含的語義信息,并遷移到新的場景上進(jìn)行生成,這要求訓(xùn)練數(shù)據(jù)中主要包含的是因果關(guān)系清晰、交互性強(qiáng)的視頻。

因此,研究人員選擇了兩個數(shù)據(jù)集作為主要訓(xùn)練數(shù)據(jù)源: Ego4d和Kinetics-600。

此外,為了增加視頻內(nèi)容的多樣性,一小部分Webvid中的數(shù)據(jù)也加入到訓(xùn)練集中。

團(tuán)隊還驗證了受限于互聯(lián)網(wǎng)視頻中包含的語義信息較為模糊和發(fā)散,簡單地通過添加更多的互聯(lián)網(wǎng)視頻來增加數(shù)據(jù)規(guī)模并不能幫助提高模型的上下文性能。

模型大小上,團(tuán)隊訓(xùn)練了300M,700M和1.1B三種大小的模型,并且發(fā)現(xiàn)模型生成視頻的質(zhì)量和上下文性能都遵循了Scaling Law。

實驗結(jié)果

Vid-ICL主要通過對一條相同的查詢視頻提供不同語義的示例視頻,來評估視頻上下文學(xué)習(xí)的有效性和精確性。

例如,對一個將物體向左移的查詢視頻,通過給向左移、隨機(jī)移動、向相反方向移動的示例視頻來生成不同的視頻,對該生成結(jié)果的評測來判斷模型是否真的生成了示例相關(guān)的視頻。

定性結(jié)果方面,下圖中給出了不同示例視頻下的生成視頻(更多樣例可參照論文原文)。

可以觀察到:

1)對于單個視頻生成的質(zhì)量,Vid-ICL保持了生成視頻與查詢視頻的連貫性,且都有不錯的生成質(zhì)量;

2)對于生成視頻和示例視頻的語義一致性,可以觀察到生成的視頻都跟隨了示例視頻的過程,這表明Vid-ICL有自發(fā)獲取示例視頻語義信息并生成相應(yīng)視頻的能力。

如下圖中,對同一個查詢視頻片段,Vid-ICL根據(jù)示例視頻中鏡頭的移動,選擇對生成視頻進(jìn)行相應(yīng)的移動。

定量結(jié)果方面,研究團(tuán)隊提出了兩個方面的自動評測指標(biāo):

1)視頻質(zhì)量上,采用傳統(tǒng)視覺任務(wù)上基于像素匹配或分布的指標(biāo),如PSNR,F(xiàn)ID等;

2)語義一致性上,采用基于分類準(zhǔn)確率的兩個指標(biāo):視頻分類準(zhǔn)確率和探針分類準(zhǔn)確率。

在不同的指標(biāo)上,Vid-ICL均表現(xiàn)出了超出基準(zhǔn)模型的效果。可以看出,在同類示例視頻的引導(dǎo)下,Vid-ICL均生成了更加真實、語義一致的視頻。

更多細(xì)節(jié)請參考原論文。

項目主頁:https://aka.ms/vid-icl

論文鏈接:https://arxiv.org/abs/2407.0735