中國大模型首登Nature封面!DeepSeek首次披露:R1訓練只花200萬

梁文鋒一句“中國AI不可能永遠跟隨”的含金量還在上升

henry 發自 凹非寺

量子位 | 公眾號 QbitAI

Nature封面認證!DeepSeek R1成果,又拿下了最新殊榮。

就在最新的Nature新刊中,DeepSeek一舉成為首家登上《Nature》封面的中國大模型公司,創始人梁文鋒擔任通訊作者。

縱觀全球,之前也只有極少數如DeepMind者,憑借AlphaGo、AlphaFold有過類似榮譽。

Nature版本的R1論文不僅首次披露了R1的訓練成本——僅約29.4萬美元(折合人民幣約 208 萬),還進一步補充了包括模型訓練所使用的數據類型及安全性的技術細節。

評審該論文的Hugging Face機器學習工程師Lewis Tunstall表示,R1是首個經歷同行評審的大型語言模型,這是一個非常值得歡迎的先例。

而俄亥俄州立大學人工智能研究員Huan Sun更是盛贊R1 ,稱其自發布以來,幾乎影響了所有在大語言模型中使用強化學習的研究。

截至發文前,其數據如下:

- 谷歌學術引用:3596次

- Hugging Face 下載量:1090萬次(開源模型下載量第一)

- GitHub Star:91.1K

不過也是因為DeepSeek,中國AI公司的下一篇工作,恐怕已經不再滿足于 CVPR、ICLR、ICML這些AI頂會了,

是不是得對齊Nature、Science的封面了?

澄清訓練細節

在這次的Nature版本中,DeepSeek在其最新的補充材料中對訓練成本、數據及安全性進行了進一步的澄清。

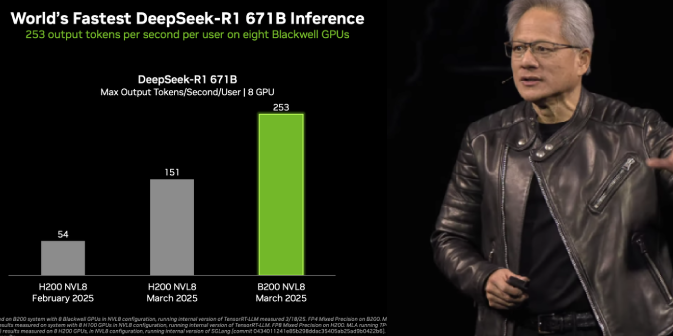

在訓練花費方面, R1-Zero和R1都使用了512張H800GPU,分別訓練了198個小時和80個小時,以H800每GPU小時2美元的租賃價格換算的話,R1的總訓練成本為29.4萬美元。

要知道,R1可是實打實的660B參數的大模型。

相比之下,它不到30萬美元的訓練成本,直接讓那些動輒燒掉上千萬美元的同行們“抬不起頭”。

也難怪它在年初發布時,會在美股掀起一場海嘯,讓那些關于“巨額投入才能打造頂級AI模型”的傳言不再那么漂亮。

(奧特曼:干脆報我身份證號得了)

此外,在數據來源方面,DeepSeek也是一舉打破了拿彼模型之輸出當R1之輸入的傳聞。

根據補充材料,DeepSeek-R1的數據集包含數學、編程、stem、邏輯、通用等5個類型的數據。

具體來說,數學數據集包含2.6萬道定量推理題,包括數學考試題和競賽題;

代碼數據集包含1.7萬道算法競賽題和8千道代碼修復問題;

STEM數據集包含2.2萬道選擇題,涵蓋物理、化學和生物等學科;

邏輯數據集包含真實問題和合成問題等共1.5萬道題;

通用數據集包含6.6萬道題,用于評估模型的有用性,涵蓋創意寫作、文本編輯、事實問答、角色扮演以及評估無害性等多種類別。

在安全性方面,雖然開源共享有助于技術在社區中的傳播,但同時也可能帶來被濫用的潛在風險。因此DeepSeek又一進步發布了詳細的安全評估,涵蓋以下幾個方面;

- DeepSeek-R官方服務的風險控制系統

- 在六個公開安全基準上與其他最先進模型的對比評估

- 基于內部安全測試集的分類學研究

- R1模型的多語言安全性評估

- 模型對越獄攻擊的魯棒性評估。

評估表明,DeepSeek-R1 模型的固有安全水平總體處于中等水平,與 GPT-4o相當,通過結合風險控制系統可進一步提高模型的安全水平。

接下來,我們來一起回顧一下這篇經典論文

將強化學習應用于大語言模型的里程碑

總的來說,DeepSeek-R1(zero)旨在解決大型語言模型在處理復雜問題和對人工數據的依賴,提出了一種純強化學習(RL)框架來提升大語言模型的推理能力。

這一方法不依賴人工標注的推理軌跡,而是通過自我演化發展推理能力,核心在于獎勵信號僅基于最終答案的正確性,而不對推理過程本身施加限制。

具體來說,他們使用DeepSeek-V3-Base作為基礎模型,并采用GRPO(Group Relative Policy Optimization)作為強化學習框架來提高模型在推理任務上的表現。

經過數千步強化學習訓練后,DeepSeek-R1-Zero 在推理基準測試上表現出卓越性能。

例如,在AIME 2024上,pass@1分數從15.6%提升至71.0%,通過多數表決進一步提高至86.7%,與o1的表現相當。

更進一步,為了解決DeepSeek-R1-Zero 在可讀性和語言混合上的問題,研究又引入DeepSeek-R1,采用少量冷啟動數據和拒絕采樣、強化學習和監督微調相結合的多階段訓練框架。

具體而言,團隊首先收集數千條冷啟動數據,對 DeepSeek-V3-Base 模型進行微調。隨后,模型進行了類似 DeepSeek-R1-Zero 的面向推理的強化學習訓練。

在強化學習接近收斂時,團隊通過在強化學習檢查點上進行拒絕采樣,結合來自DeepSeek-V3在寫作、事實問答、自我認知等領域的監督數據,生成新的SFT數據,并重新訓練DeepSeek-V3-Base模型。

經過新數據微調后,模型還經歷了覆蓋各種提示場景的額外的強化學習過程,DeepSeek-R1就由此而來。

實驗表明,DeepSeek-R1與當時的頂尖模型OpenAI-o1-1217不相上下。

此外,將大模型涌現出的推理模式用于指導并提升小模型的推理能力也成為了一種經典方法。

論文中使用Qwen2.5-32B作為基礎模型,結果顯示,從DeepSeek-R1蒸餾出的性能,優于直接在該基礎模型上應用強化學習。

當然,在開拓性論文的基礎上,更讓人津津樂道、也贏得Nature盛贊的,是DeepSeek的透明性與開源精神:

DeepSeek已在HuggingFace上公開了DeepSeek-R1和DeepSeek-R1-Zero的模型權重,同時將基于Qwen2.5 和 Llama3 系列的蒸餾模型一并開源,供社區自由使用。

回想年初DeepSeek在海外爆火時,梁文鋒一句“中國AI不可能永遠跟隨”的豪言壯志令人振奮。

如今,DeepSeek影響力獲得Nature封面認可,如果AI研究機構有S級認可,那DeepSeek毫無疑問已經拿到了S級認證。

下一個,阿里通義、字節Seed、騰訊混元、百度文心、華為、智譜、Kimi、階躍……

Who?

參考鏈接

[1]https://www.nature.com/articles/d41586-025-03015-6

[2]https://www.nature.com/articles/s41586-025-09422-z#Sec4

— 完 —

量子位 QbitAI · 頭條號簽約

關注我們,第一時間獲知前沿科技動態

- 極客公園創新大會 2026在京落幕,羅永浩、張楠、何小鵬、劉靖康等共議 AI 時代「進程由我」2025-12-09

- 機器人集體到香港戶外極限挑戰,狗比人強2025-12-08

- 編程界“奧斯卡”百度之星決賽揭曉,上千選手激烈角逐,山東16歲中學生王茂驊奪冠!2025-12-08

- 清華成立具身智能與機器人研究院2025-12-04