接任湯曉鷗!周伯文以上海AI Lab主任身份WAIC演講:探索AI-45° Law

沿著可信AGI的“因果之梯”拾級而上

衡宇 發自 凹非寺

量子位 | 公眾號 QbitAI

就在剛剛,清華教授周伯文以全新身份,在WAIC 2024全體會議上發表演講——

上海人工智能實驗室主任、首席科學家。

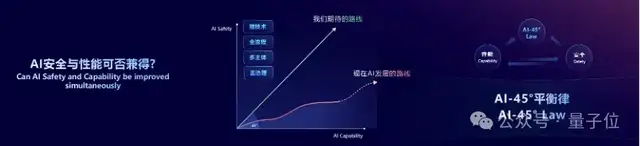

在演講中,他提出一個技術主張:探索人工智能45°平衡律(AI-45° Law)。

即從長期的角度來看,需要找到AI安全優先,但又能保證AI性能長期發展的技術體系。

周伯文在發言中提到,沿著這個思路,上海AI實驗室最近正在探索一條以因果為核心的路徑,取名為“可信AGI‘因果之梯’”。

可信AGI的“因果之梯”將可信AGI的發展分為三個遞進階段:

- 泛對齊

- 可干預

- 能反思

周伯文表示,要沿著可信AGI的“因果之梯”拾級而上:

目前,AI安全和性能技術發展主要停留第一階段,部分在嘗試第二階段,但要真正實現AI的安全與性能平衡,我們必須完善第二階段并勇于攀登第三階段。

2021年,周伯文離開工作4年的京東,投身AI創業,成立大模型公司銜遠科技,聚焦電商領域的生成式AI落地。

今年4、5月份前后,消息傳出,銜遠科技創始人周伯文,已經不再主持公司事務,另有去處。

終于,WAIC 2024上,周伯文的新身份水落石出,接任去年12月中因病去世的湯曉鷗先生,主持上海人工智能實驗室事務。

他履新后正帶領上海AI實驗室的方向,也在首次亮相發言中對外傳遞。

(附周伯文在WAIC 2024全體會議上的演講全文)

周伯文履歷

周伯文,上海人工智能實驗室主任、首席科學家,清華大學惠妍講席教授,銜遠科技創始人。

他是自注意力融合多頭機制的自然語言表征機理的提出者,這是Transformer架構的核心思想之一。

他本科就讀于中國科學技術大學少年班,在中科院獲得碩士學位,后留學美國。

研究方向包括語音和自然語言處理、多模態與知識表征、理解、生成、推理、人機對話、可信賴AI等。

學成后,周伯文曾就職于IBM,負責人工智能和深度學習基礎研究方面的工作。

2017年,周伯文回國加入京東,成為京東首任AI掌門人,歷任京東集團高級副總裁、京東集團技術委員會主席、京東云與AI總裁、京東人工智能研究院創始院長。

負責的業務,包括京東的整體技術,以及云計算、人工智能、物聯網、大數據等技術商業化。

他被視為“京東AI開創者”,親手從零一手組建了最初約400人的團隊。

包括何曉冬(現任京東探索研究院院長)、梅濤(曾任京東集團副總裁,京東探索研究院副院長;現創業文生視頻公司HiDream.ai)在內的京東系AI大牛,都由周伯文引入。

2021年底,周伯文從京東離職,創立銜遠科技。

目標聚焦在生成式AI的產業應用落地,主要是電商領域。

2022年5月30日,清華大學電子工程系宣布,清華大學聘任周伯文博士為電子工程系長聘教授、清華大學惠妍講席教授。

2024年4月,消息傳出,周伯文不再主事銜遠科技,另有任用。

2024年7月,周伯文以上海人工智能實驗室主任、首席科學家身份亮相上海WAIC,并發表演講。

周伯文WAIC發言全文

尊敬的各位領導,各位嘉賓,大家上午好,非常榮幸在WAIC大會上、在上海,與大家分享人工智能安全的前沿技術話題,我想提出一個技術主張:探索人工智能45°平衡律——Towards AI-45°Law。

當前,以大模型為代表的生成式人工智能快速發展,但隨著能力的不斷提升,模型自身及其應用也帶來了一系列潛在風險的顧慮。

從公眾對AI風險的關注程度來看,首先是數據泄露、濫用、隱私及版權相關的內容風險;其次是惡意使用帶來偽造、虛假信息等相關的使用風險;當然也誘發了偏見歧視等倫理相關問題;此外還有人擔心:人工智能是否會對就業結構等社會系統性問題帶來挑戰。在一系列關于人工智能的科幻電影中,甚至出現了AI失控、人類喪失自主權等設定。

這些由AI帶來的風險已初露端倪,但更多的是潛在風險,防范這些風險需要各界共同努力,需要科學社區做出更多貢獻。

去年5月,國際上數百名AI科學家和公眾人物共同簽署了一份公開信《Statement of AI Risk》,表達了對AI風險的擔憂,并呼吁,應該像對待流行病和核戰爭等其他大規模的風險一樣,把防范人工智能帶來的風險作為全球優先事項。

出現對這些風險擔憂,根本原因是我們目前的AI發展是失衡的。

先讓我們來看一下目前的AI發展趨勢:在Transformer為代表的基礎模型架構下,加以(大數據-大參數量與大計算)的尺度定律(Scaling Law),目前AI性能呈指數級增長。與此形成對比的是,在AI安全維度典型的技術,如:紅隊測試、安全標識、安全護欄與評估測量等,呈現零散化、碎片化,且后置性的特性。

最近的一些對齊技術兼顧了性能和安全性。比如:監督式微調SFT、人類反饋的強化學習RLHF等技術,RLAIF、SuperAlignment等。這些方法幫助將人類的偏好傳遞給AI,助推涌現出了ChatGPT、GPT-4等令人興奮的AI系統,以及我們上海AI實驗室的書生Intern大模型等等。雖然瞄準的是安全和性能同時提升,但這些方法在實際使用中往往還是性能優先。

所以總體上,我們在AI模型安全能力方面的提升,還遠遠落后于性能的提升,這種失衡導致AI的發展是跛腳的,我們稱之為Crippled AI。

不均衡的背后是二者投入上的巨大差異。如果對比一下,從研究是否體系化,以及人才密集度、商業驅動力、算力的投入度等方面來看,安全方面的投入是遠遠落后于AI能力的。

李強總理剛才提出“智能向善”。AI要確保可控,統籌發展與安全。毫無疑問地,我們要避免這樣的Crippled AI發展,我們應該追求的是:TrustWorthy AGI,可信的AI,可信的通用人工智能。

可信AGI需要能夠兼顧安全與性能,我們需要找到AI安全優先,但又能保證AI性能長期發展的技術體系。我們把這樣一種技術思想體系叫做“AI-45°平衡律”?(AI-45° Law)。

AI-45°平衡律是指從長期的角度來看,我們要大體上沿著45度安全與性能平衡發展,平衡是指短期可以有波動,但不能長期低于45°(如同現在),也不能長期高于45度(這將阻礙發展與產業應用)。這個技術思想體系要求強技術驅動、全流程優化、多主體參與以及敏捷治理。

實現AI-45°平衡律也許有多種技術路徑。我們上海AI實驗室最近在探索一條以因果為核心的路徑,我們把它取名為:可信AGI的“因果之梯”,致敬因果推理領域的先驅——圖靈獎得主Judea Pearl。

可信AGI的“因果之梯”將可信AGI的發展分為三個遞進階段:泛對齊、可干預、能反思。

“泛對齊”主要包含當前最前沿的人類偏好對齊技術。但需要注意的是,這些安全對齊技術僅依賴統計相關性而忽視真正的因果關系,可能導致錯誤推理和潛在危險。一個典型的例子是巴甫洛夫的狗:當狗僅僅基于鈴聲和食物的統計相關性形成條件反射時,它可能在任何聽到鈴聲的場合都觸發行為分泌唾液——如果這些行為涉及到……時這顯然是不安全的。

“可干預”主要包含通過對AI系統進行干預,探究其因果機制的安全技術,例如人在回路、機械可解釋性,以及我們提出的對抗演練等,它以通過提高可解釋性和泛化性來提升安全性,同時也能提升AI能力。

“能反思”則要求AI系統不僅追求高效執行任務,還能審視自身行為的影響和潛在風險,從而在追求性能的同時,確保安全和道德邊界不被突破。這個階段的技術,包括基于價值的訓練、因果可解釋性、反事實推理等。

目前,AI安全和性能技術發展主要停留第一階段,部分在嘗試第二階段,但要真正實現AI的安全與性能平衡,我們必須完善第二階段并勇于攀登第三階段。沿著可信AGI的“因果之梯”拾級而上,我們相信可以構建真正可信AGI,實現人工智能的安全與卓越性能的完美平衡。

最終,像安全可控的核聚變技術為全人類帶來清潔、豐富的能源一樣,我們希望通過深入理解AI的內在機理和因果過程,從而安全且有效地開發和使用這項革命性技術。

也正如可控核聚變對全人類都是共同利益一樣,我們堅信AI的安全也是全球性的公共福祉,陳吉寧書記剛剛在發布的《人工智能全球治理上海宣言》中提到“要推動各國加強交流和對話”,我們愿與大家一起攜手推進AI-45°平衡律的發展,共享AI安全技術、加強全球AI安全人才交流與合作,平衡AI安全與能力的投入,共同構建開放、安全的通用人工智能創新生態和人才發展環境。

謝謝大家!

- DeepSeek-V3.2系列開源,性能直接對標Gemini-3.0-Pro2025-12-01

- 誤入人均10個頂級offer的技術天團活動,頂尖AI人才的選擇邏輯我悟了2025-12-04

- 字節“豆包手機”剛開賣,吉利系進展也曝光了:首月速成200人團隊,挖遍華為小米榮耀2025-12-01

- 居然有21%的ICLR 2026評審純用AI生成…2025-11-30