北大機器人當上亞運志愿者,全靠學生把多模態大模型結合具身智能

論機器人想在杭州當志愿者有多拼

北大 把投稿扔向 凹非寺

量子位 | 公眾號 QbitAI

亞運會導游,原來背后離不開北大學生團隊!

且看這個智能導游,它可不是一般人:

外觀看上去像一輛小車,四個輪子在地面上快速靈活移動。

上面安裝了機械臂,配有攝像頭及語音等交互設施,使其能夠對周圍環境和需要執行的任務進行識別與理解。

據悉,這名導游機器人系統由北大計算機學院HMI團隊研發,它結合了多模態大模型和具身智能。

在亞運會期間,它為視障人士提供引領和導航等幫助,并可解析視障人士的需求并完成相應任務,如幫助他們撿拾掉落的物品等。

具身智能,搭載多模態大模型那種

那么,這位具身智能導游是怎么煉成的?

在研究員仉尚航的指導和支持下,北大學生們形成了一種創新路徑,即設計感知生成一體化的多模態大模型,以實現對各種視覺場景的精準感知與理解,并生成準確豐富的語言描述。

之所以這樣設計,是因為這個導游最初就設計定位為服務殘障人士、老年人、少數民族等——當前的技術落點,還沒有完全解決他們的需求。

“少數民族的觀眾可能面臨語言障礙,而殘疾人士可能需要更多的輔助工具或特別的服務,以便更好地享受比賽。”團隊成員、北大學生莊棨寧表示,多模態大模型是課題組的重點研究方向,于是一個把多模態大模型和具身智能結合起來,研發一個專門服務殘障人士觀賽的AI系統的想法,誕生了。

于是,多模態愛心助手亮相亞運會。

多模態愛心助手所搭載的系統,基于團隊自研的感知生成一體化通用多模態大模型。

該系統集成了大模型的泛化感知能力和涌現能力。

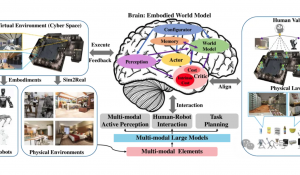

同時,在愛心助手身上,多模態大模型和具身智能結合了起來,為機器人賦予更加智能的大腦,使其可以將人類復雜需求轉化為具體行動指令。

它能做的事情,體現出一體化處理能力,包括:

- 場景感知,能夠識別圖像中的特定目標或特征;

- 場景解析,能夠為圖像生成描述性文本;

- 行為決策與規劃,具備基于圖像和文本信息進行決策和規劃的能力。

考慮到機器人會面對不同場景,需要具備快速適應新場景的泛化能力,團隊設計了基于端云協作的大小模型協同高效微調,提升模型的泛化性,使其可以持續適應不同的場景。

舉個例子。

如果有運動員用戶說“我渴了”,機器人聽到這句話后,完成轉身拿水——遞到用戶手中,過程看似簡單,實際上涉及了一系列子任務:

- 首先捕捉“我渴了”這句語音信號,然后通過語音識別技術,轉換為文字;

- 理解“我渴了”這句話的含義,即用戶現在需要水;

- 通過良好的感知能力,利用CV技術,識別、定位瓶裝水;

- 規劃來到瓶裝水面前的路線,涉及路徑規劃算法;

- 控制自身動作,根據路徑規劃,來到水面前;

- 準確抓住瓶裝水,涉及視覺檢測、機器人控制系統和抓取的相關技術;

- 規劃返回路徑,并控制自身動作,將水送到說話者的手中。

上述的每一個子任務,都需要大量的研究和工程實踐。

不僅如此,機器人還需要能夠處理在訓練數據中未曾出現過的新情況,也就是說,模型需要具有強大的泛化能力,能夠在新的、未知的環境中有效地工作。

為了提升機器人在開放環境下的持續性泛化能力,團隊構建了一個端云協作的持續學習系統。

這一系統的設計旨在兼顧終端計算的個性化、隱私保護和低通信成本等優勢,同時也充分利用云端計算的大規模計算資源、大量標注數據以及卓越的泛化能力。

還研發亞運會賽事解說AI系統

據悉,杭州亞運會的多模態多語種視頻解說系統,也出自這個團隊之手。

基于多模態大模型,團隊通過自研的X-Accessory一體化大模型工具鏈,設計了多模態多語種視頻解說系統,在亞運會期間用于乒乓球、跆拳道、跳水、體操等賽事。

這個解說系統的特點在于,不僅能夠理解和分析正在進行的比賽,生成實時的解說內容,還可以根據觀眾的喜好提供個性化的解說服務,包括將解說內容翻譯成多種語言,包括維吾爾語、阿拉伯語等。

除了應用在本次亞運會,團隊在大模型方面還有許多其他成果。

“多模態大模型是我們組研究的核心,目前也取得了一定的成果。”北京大學計算機學院博士后王冠群介紹,“除了這次自研的感知生成一體化通用多模態大模型、大小模型協同訓練與部署,我們還關注多模態生成式大模型Agent設計、大模型記憶機制設計、面向多場景的智能醫療多模態大模型集群、通用大模型適配器等。”

就拿團隊進行的多模態生成式大模型Agent設計來說。

單模態模型無法有效地結合視覺、聽覺和文本等多種模態信息,這種局限性在復雜的實際場景,如虛擬助手、機器人交互和智慧城市中,可能導致效果并不理想。

因此,團隊開發了一種多模態生成式大模型Agent,將各種模態的優點結合起來,例如視覺的細節捕捉能力、聽覺的時序特性和文本的結構化知識。

這樣的綜合性設計,將有助于推動生成式模型向更加實用和高效的方向發展,滿足未來多種復雜應用場景的需求。

在更復雜的應用場景,團隊還研究過面向多場景的智能醫療多模態大模型集群。

他們設計和實現了一組智能醫療多模態大模型集群,包括面向患者的個性化醫療知識問答多模態時序大模型、面向醫生的臨床影像報告生成多模態大模型和面向導診場景的檢索增強大語言模型。

這樣一來,能使大模型技術適配臨床場景,滿足患者-醫生-醫院多方訴求,解決行業痛點,推動大模型在醫療領域的落地應用。

△杭州亞運會期間科研團隊合影(第一排左起:張雨澤、莊棨寧、謝愛麗、仉尚航、張融宇、羅峪霖、王振宇;第二排左起:侯沂、戴鴻銘、王昊、李忱軒、張啟哲、劉家銘、王冠群)

- 誤入人均10個頂級offer的技術天團活動,頂尖AI人才的選擇邏輯我悟了2025-12-04

- DeepSeek-V3.2系列開源,性能直接對標Gemini-3.0-Pro2025-12-01

- 字節“豆包手機”剛開賣,吉利系進展也曝光了:首月速成200人團隊,挖遍華為小米榮耀2025-12-01

- 居然有21%的ICLR 2026評審純用AI生成…2025-11-30