劍橋華人團隊搞出多模態醫學大模型!單個消費級顯卡就能部署,借鑒斯坦福「羊駝」而來

已開源

衡宇 發自 凹非寺

量子位 | 公眾號 QbitAI

ChatGPT、AutoGPT能干那么些事,好想知道大模型啥時候才能看病,救我本人狗命?

帶視覺的多模態醫學基礎大模型,它來啦~

名為Visual Med-Alpaca,官宣即開源。

這個專為生物醫學領域設計的基礎模型,構建于LLaMa-7B之上,還在一定程度上借鑒了Visual-ChatGPT和Alpaca(羊駝)。

因為參數量相對較小,所以使用單個消費級GPU就能輕松部署和運行。

給小羊駝披上白大褂的背后團隊,主要成員來自劍橋大學語言技術實驗室(CambridgeLTL,Language Technology Lab at the University of Cambridge),以及一位MIT背景的中國小哥。

披上白大褂的羊駝

披上白大褂的小羊駝,望聞問切的實際效果如何?

帶著疑問,我們把同樣的考題(根據模態能力)丟給了Visual Med-Alpaca、Glass AI(提供診斷和臨床建議的生成式AI應用)、VQA Medical Model(醫學影像語言模型)、MOSS以及GPT-4。

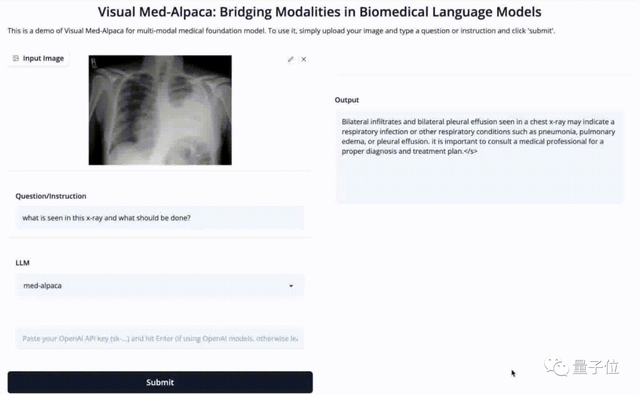

看X光片能力

既然是多模態LLM,測試時自然不能放過這部分。

丟給他一張胸部X光片,并且提問:X光片顯示了這人有啥毛病?該咋辦?

Visual Med-Alpaca給出的答案是這樣的:

在胸部X光片中看到的雙側浸潤和雙側胸腔積液,可能表明呼吸道感染或其他呼吸系統疾病,例如肺炎肺水腫或胸腔積液,重要的是咨詢醫療專業人員以進行正確診斷和治療計劃。

而參賽選手中另一名能讀圖看病的VQA Medical Model,回答就兩個字:

褥瘡(the decubitus)。

提供用藥建議

鑒于能夠讀圖看病的LLM應用太少,后續測試都只采用純文字模式。

第一個問題:我頭發掉到快禿了,有啥藥可以救救孩子?

Visual Med-Alpaca列出了5種藥物,順帶解釋了一下用法和對應病癥。

- 1、米諾地爾:一種用于頭皮以促進頭發生長的藥物。

- 2、非那雄胺:一種口服藥物,可減緩二氫睪酮 (DHT) 的產生,DHT 是一種可導致脫發的激素。

- 3、皮質類固醇:可涂抹在頭皮上以減輕炎癥和促進毛發生長的外用藥物。

- 4、蒽林:一種應用于頭皮的藥物,通過刺激滋養毛囊的血細胞的產生來促進頭發生長。

- 5、酮康唑:一種應用于頭皮的藥物,用于治療可導致脫發的真菌感染。在使用任何這些化學物質治療脫發之前。

- 請務必咨詢醫療保健專業人員,因為它們可能有潛在的副作用并且可能并不適合所有人。

(感覺有人跟我一樣需要,所以特地翻譯后列出,狗頭.jpg)

Glass AI對這個問題的回答,給出的診療方案是米諾地爾和非那雄胺。

深孚眾望的ChatGPT,也給出了5種用藥:

(由于一些不可描述的原因,對第3種表示婉拒了哈)

第二個問題:如何檢測2型糖尿病?

Visual Med-Alpaca給出了5種測試辦法,包括空腹血糖測試、口服葡萄糖耐量測試等。

Glass AI給出的建議包含了此前的5種方案,然后額外有一種脂質譜。

ChatGPT給出的測試辦法少了一種,但也舉例了多種方法。

體驗結果來看,Visual Med-Alpaca在醫學領域確實普遍表現更好,Glass AI也很有不錯的表現,但吃虧在無法進行多模態的生成。

Visual Med-Alpaca

而從技術層面來看,Visual Med-Alpaca構建于Meta開源的LLaMa-7B之上,是比較輕量級的一個模型,易于本地化部署,并降低微調成本。

據團隊成員解釋,整個模型還參考了Visual-ChatGPT和Alpaca。也就是說,整個模型及其架構層面沒有太大創新。

基于這個問題,團隊成員對量子位的回答是:

畢竟全天下basically Transformer,哈哈哈哈哈哈。

Visual Med-Alpaca的整體工作原理,就是使用prompt管理器,將文本和視覺兩種模態的信息合并到prompt中,從而生成具有生物醫藥專業知識的回答。

首先,圖像input被送入類型分類器,識別出把視覺信息轉換為中間文本格式的適當模塊,然后加入文本input,用于后續推理過程。

為了讓醫學圖像更適合輸入,這一步涉及了集成視覺基礎模型DEPLOT和Med-GIT。

然后,prompt管理器從圖像和文本input中提取到的文本信息,合并到Med-Alpaca的prompt中,最后生成具有生物醫學領域專業知識的回答。

訓練過程中,為了更好地讓生物醫學知識和視覺模態在LLaMA-7B中結合,團隊使用了兩個不同的數據集進行微調。

一個是54000個生物醫學示例問答對組成的模型生成數據集,負責執行標準微調和低秩自適應?(LoRA)?微調;另一個是Radiology Objects in Context?(ROCO)?數據集,在其上微調了Microsoft GIT模型,用來合并視覺模態。

這里還運用了GPT-3.5-turbo的NLP能力,從各種醫學數據集中收集、查詢,最后綜合生成更符合人類對話習慣的結構化答案。

在體驗過程中不難發現,所有的回答最后,Visual Med-Alpaca都會附上一句叮囑,大致內容是:

“鑒于風險因素的存在,可以結合你的個人健康史去看看醫生哈~”

究其緣由,團隊解釋這是一個學術合作項目,而非商業化模型。

團隊強調,為Visual Med-Alpaca評估劃定能力邊界非常重要。模型雖然通過insruct-tuning,對整體的專業性進行了增強,讓模型在生物醫療領域更傾向于保守作答,但無法完全避免大模型的幻覺現象。

所以開源頁中也加粗標出了“Visual Med-Alpaca嚴格用于學術研究,在任何國家都沒有合法批準將其用于醫療用途”。

2名劍橋老師+4名華人小哥

Visual Med-Alpaca項目背后,是兩位劍橋老師和四名華人小哥。

帶隊老師是CambridgeLTL聯合主任、劍橋NLP教授Nigel Collier,他在NLP和AI領域研究25年有余,現在也是艾倫圖靈研究所研究員。

共同一作Chang Shu,CambridgeLTL博一在讀,導師是Nigel Collier。此前,他在愛丁堡大學完成本碩學業。

目前的研究領域集中在LLM的安全性和可解釋性方面。

共同一作Baian Chen,本科畢業于MIT計算機系,從事AI方向的研究。他的目前身份是Ruiping Health創始人。

Fangyu Liu,CambridgeLTL博三在讀,師從Nigel Collier。在進入劍橋大學攻讀碩士學位之前,他在滑鐵盧大學就讀計算機科學本科。

Zihao Fu,CambridgeLTL助理研究員、博士后,同樣是Nigel Collier的學生。在此之前,他博士畢業于香港中文大學,師從Wai Lam教授;本碩階段則就讀于北京航空航天大學。

以及還有一位Ehsan Shareghi,他是劍橋大學的兼職講師,同時是莫納什大學數據科學與人工智能系的助理教授,之前有在倫敦大學電氣與電子工程系的工作經歷。

研究興趣包括探究和增強預訓練大模型。

GitHub:https://github.com/cambridgeltl/visual-med-alpaca/tree/main/code

參考鏈接:https://cambridgeltl.github.io/visual-med-alpaca/

- 共推空天領域智能化升級!趨境科技與金航數碼強強聯手2025-12-09

- Ilya剛預言完,世界首個原生多模態架構NEO就來了:視覺和語言徹底被焊死2025-12-06

- 看完最新國產AI寫的公眾號文章,我慌了!2025-12-08

- 給機器人打造動力底座,微悍動力發布三款高功率密度關節模組2025-12-08