谷歌大腦最新操作玩“復古”:不用卷積注意力,圖像分類接近SOTA

沒錯,就是純MLP架構

谷歌大腦的視覺Transformer團隊(ViT),搞了個復古操作。

他們不用卷積神經網絡(CNN)、也不用Transformer,僅憑最早的AI視覺任務采用的多層感知機(MLP)結構,就實現了接近SOTA的性能,更是在ImageNet圖像分類任務上取得了87.94%的準確率。

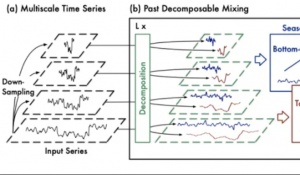

這個架構名為MLP-Mixer,采用兩種不同類型的MLP層,可以看做是一個特殊的CNN,使用 1×1卷積進行通道混合(按位操作),同時全感受野和參數共享的的單通道深度卷積進行字符混合(跨位操作)。

在JFT-300M數據集上預訓練、微調到224分辨率的Mixer-H/14版本取得了86.32%的準確率,比SOTA模型ViT-H/14僅低0.3%,但運行速度是其2.2倍。

論文地址:

https://arxiv.org/abs/2105.01601

項目地址:

https://github.com/google-research/vision_transformer/tree/linen

版權所有,未經授權不得以任何形式轉載及使用,違者必究。

- 首個GPT-4驅動的人形機器人!無需編程+零樣本學習,還可根據口頭反饋調整行為2023-12-13

- IDC霍錦潔:AI PC將顛覆性變革PC產業2023-12-08

- AI視覺字謎爆火!夢露轉180°秒變愛因斯坦,英偉達高級AI科學家:近期最酷的擴散模型2023-12-03

- 蘋果大模型最大動作:開源M芯專用ML框架,能跑70億大模型2023-12-07