谷歌提出新型自動語音識別數據增強大法,直接對頻譜圖“動刀”,提升模型表現

擴增音頻數據新方法了解一下?

銅靈 發自 編譯整理

量子位 出品 | 公眾號 QbitAI

每次用語音輸入完成“打字”過程,你的手機就經歷了一次自動語音識別(ASR)。

這種已經無處不在的音頻轉錄成文本的技術,在缺乏足夠大的數據集,模型過擬合嚴重。因此當前如何去擴增音頻數據是個大問題。

谷歌大腦在最新的一篇博客中,提出了一種用于ASR中擴增數據的新方法:SpecAugment。

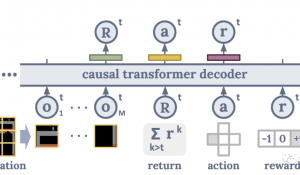

和之前的研究畫風有些不同,這一次,谷歌將這個問題當成了視覺問題而非音頻問題。SpecAugment沒有像傳統擴增方法一樣增加音頻波形,而是將擴增策略直接應用于音頻頻譜圖。

谷歌表示,SpecAugment方法簡單,計算成本低,并且不再需要其他額外數據,在ASR任務LibriSpeech 960h和Switchboard 300h上,這種擴增方法效果驚艷。

不信接著看。

音頻波形圖

在傳統的ASR任務中,在將訓練數據輸入到神經網絡前,通常先通過剪裁、旋轉、調音、加噪等方式先對輸入的音頻數據進行增強,然后再轉換成頻譜圖等視覺表示。因此,每次迭代后,都有新的頻譜圖生成。

在谷歌的新方法中,研究人員將研究重點放在了擴增頻譜圖本身的方法上,并不針對聲音數據進行改造,而是直接對頻譜圖等視覺表示進行增強。

因為擴增可以直接被應用于神經網絡的輸入功能上,因此可以在訓練過程中在線運行,不會影響到訓練速度。

△ 將聲音數據轉換成梅爾頻率倒譜圖,也就是基于聲音頻率的非線性梅爾刻度的對數能量頻譜的線性變換

SpecAugment通過時間方向上的扭曲改造頻譜圖,及時修改、屏蔽連續頻率頻道塊和語言頻道塊。這種擴增方式能讓神經網絡更強健,幫助抵抗時間方向上的變形,也會防止頻率信息和語音片段信息丟失。

下圖就是這種擴增策略的示例圖:

△ 圖中紫色區域為被屏蔽的部分

可以看出,通過在時間方向上進行扭曲,外加屏蔽多個連續時間步長(垂直方向屏蔽)和梅爾頻率頻道(水平方向屏蔽),能有效擴增數據頻譜圖。

詞錯率降5%

這種方法的效果如何?研究人員在實驗基礎上進行了一系列實驗。

研究人員限用大型開源語音識別數據集LibriSpeech上進行實驗,比對模型生成的文字與目標文字的差異。他們選取了端對端谷歌語音識別神經網絡框架Listen, Attend and Spell(LAS),比較了使用SpecAugment擴增數據與不使用情況下訓練出網絡的性能。

在此實驗中采用控制變量法,所有超參數都保持不變,只改變輸入到網絡的數據,用轉錄過程的詞錯率( Word Error Rate,WER)來衡量結果。

結果發現,在LibriSpeech數據集上,SpecAugment擴增方法能明顯降低詞錯率。模型大小的不同對結果影響不大,平均詞錯率大致降低5%。

△ 擴增數據后的詞錯率(藍色)與無擴增數據的詞錯率(黃色)

除了降低詞錯率,SpecAugment還能有效防止神經網絡過擬合。

△ 對訓練數據、清潔數據和嘈雜數據的擴增結果

研究人員增加了網絡容量,在LibriSpeech 960h和Switchboard 300h任務上檢測模型詞錯率,發現用SpecAugment擴增數據過后可獲得當前最優結果。

傳送門:

谷歌官方博客:

http://ai.googleblog.com/2019/04/specaugment-new-data-augmentation.html

研究論文:

SpecAugment: A Simple Data Augmentation Method for Automatic Speech Recognition

https://arxiv.org/abs/1904.08779

—?完?—

誠摯招聘

量子位正在招募編輯/記者,工作地點在北京中關村。期待有才氣、有熱情的同學加入我們!相關細節,請在量子位公眾號(QbitAI)對話界面,回復“招聘”兩個字。

量子位?QbitAI · 頭條號簽約作者

?’?’ ? 追蹤AI技術和產品新動態

- 微軟公布19財年財報:凈利潤增長22%,云計算首超個人計算業務2019-07-19

- 騰訊云推出物聯網邊緣計算平臺,具備五大特點,想攻克物聯網落地難題2019-08-28

- DeepMind醫療業務幾經動蕩,現在團隊并入Google2019-09-20

- 首例基因編輯干細胞治療艾滋病:北大鄧宏魁參與,達最佳治療效果2019-09-14